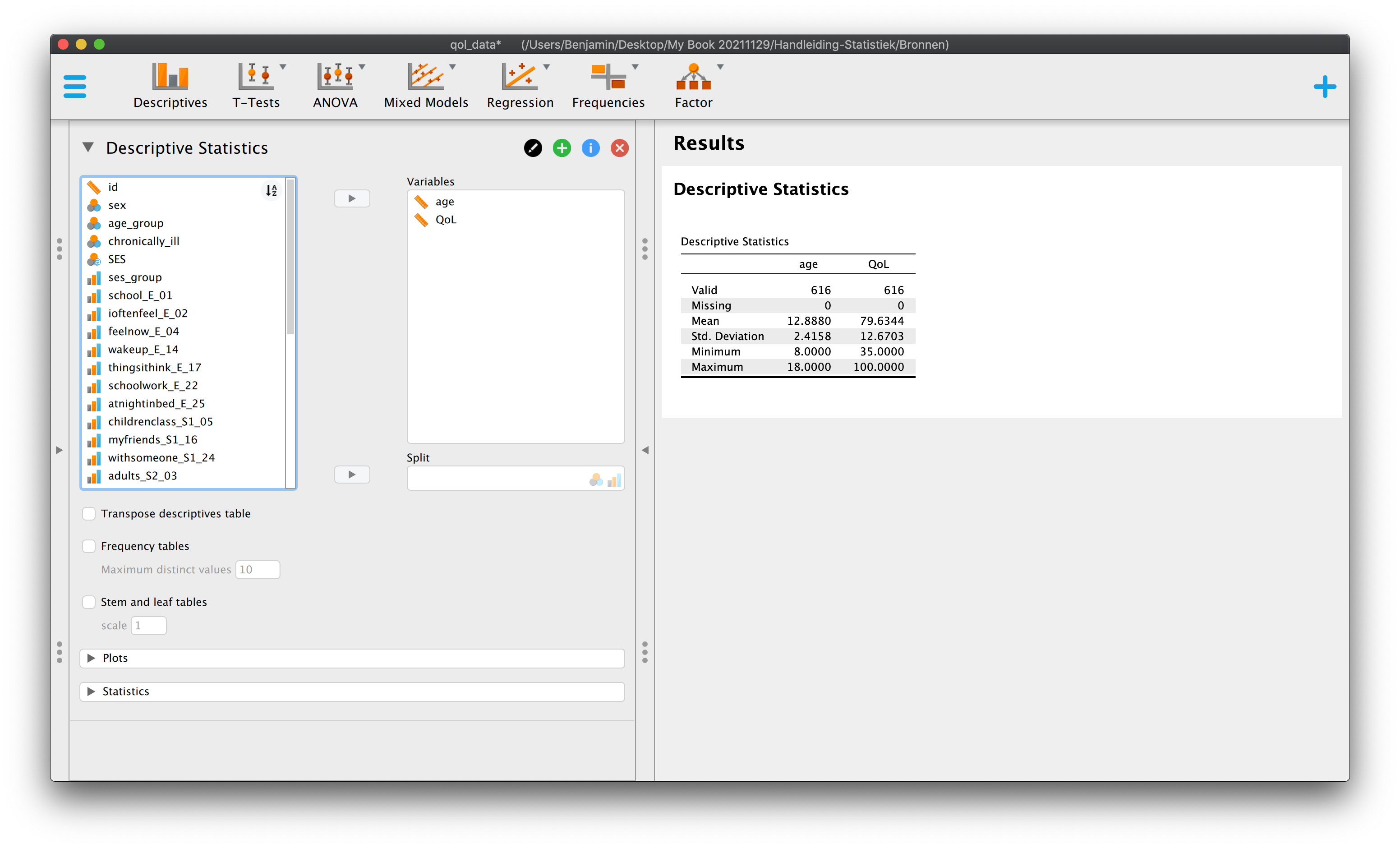

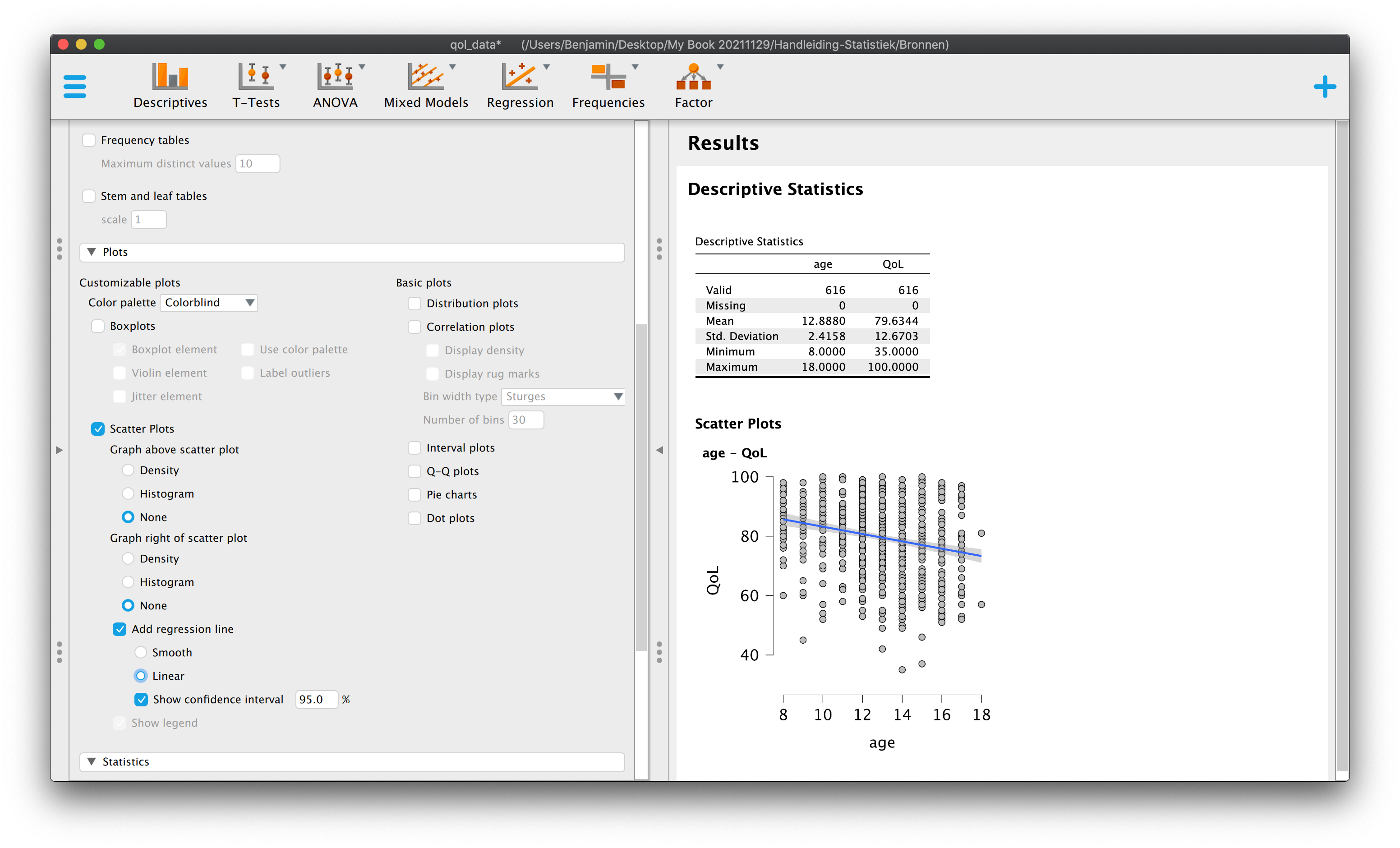

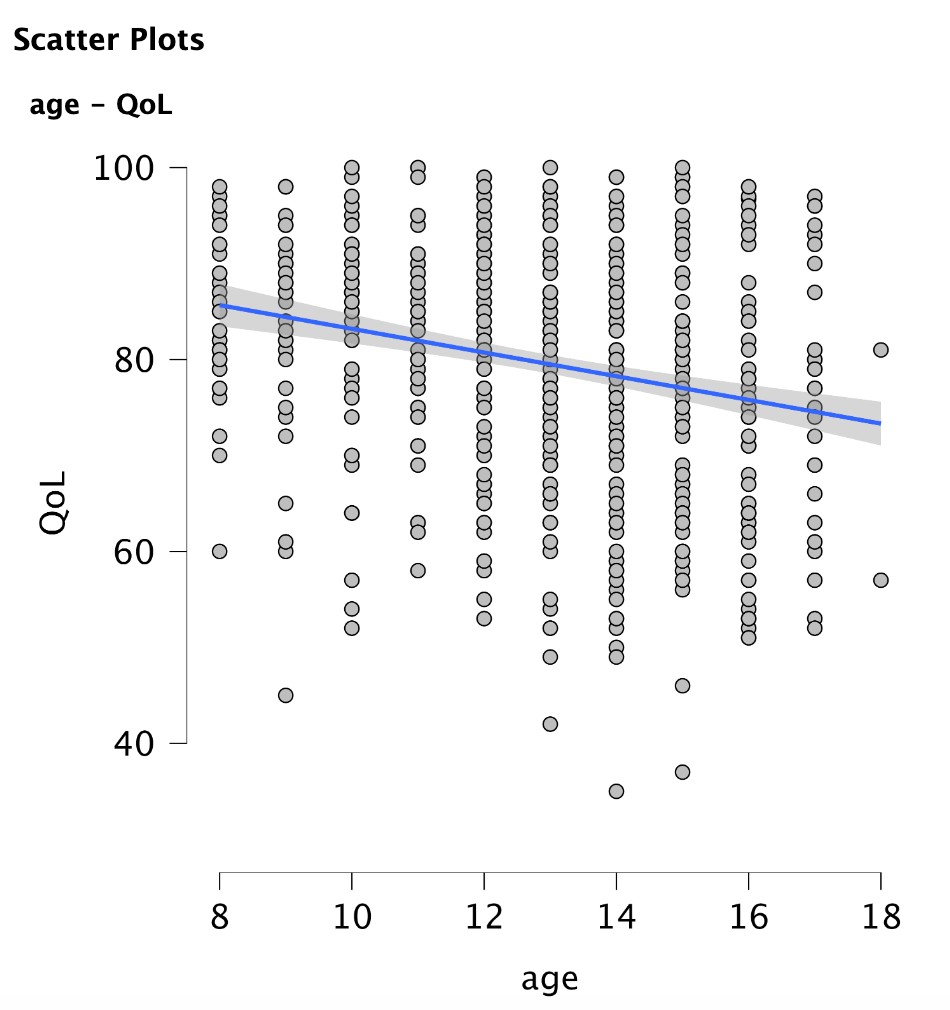

5 Hoofdstuk 5 - Enkelvoudige Lineaire Regressie-Analyse.

5.1 De voorspelling van een belangrijke variabele op basis van één andere (toch óók wel een beetje belangrijke) variabele.

Inmiddels ben je al zo ver gekomen, dat je het volgende ook nog wel aankan (is mijn voorspelling); Door mijn gebrabbel (Error) heen, mag ik hopen (Model), dat je – let op – één ding inmiddels duidelijk is geworden: In de wetenschap draait het uiteindelijk om tast-bare (dus repliceerbare) en zo correct mogelijke voorspellingen (jou theorie werkt en anderen kunnen dat checken) – Maar dit geldt dus ook voor het gewone, en dus ONS leven! Denk alleen al aan je motoriek, toch wel handig als je weet (voorspeld hebt) wanneer je je hand moet dicht doen, als je een balletje aan het overgooien bent en hem probeert te vangen. Of als je inschat hoelang het fietsen is naar school, om op tijd te komen. Misschien is de allerbelangrijkste wel de inschatting qua uren studietijd, die je nodig hebt om het tentamen te halen!

Heb je ooit wel eens van ‘regressie-therapie’ gehoord? Hierin wordt je (onder hypnose) terug gebracht naar je essentie of het begin van je leven in de baarmoeder. Je weet namelijk maar nooit, stel je voor, dat je in die periode de nodige frustraties hebt opgelopen… Die frustraties (of zegeningen) zouden zomaar een verklaring kunnen zijn voor datgeen dat jij vandaag de dag zoal doet. Elke keer, als we, zo goed als het kan, een inschatting maken (voorspelling), is het telkens weer de vraag: ‘Op basis waarvan kunnen we de beste inschatting maken?’. Wij slaan de baarmoeder weliswaar over en zoeken naar voorspellers (\(x\)-en) voor de te verklaren variabele (\(y\)), met een iets tastbaardere voorspel-kracht!

5.2 Beter Voorspellen aan de Hand van een Lineaire Vergelijking (Formule).

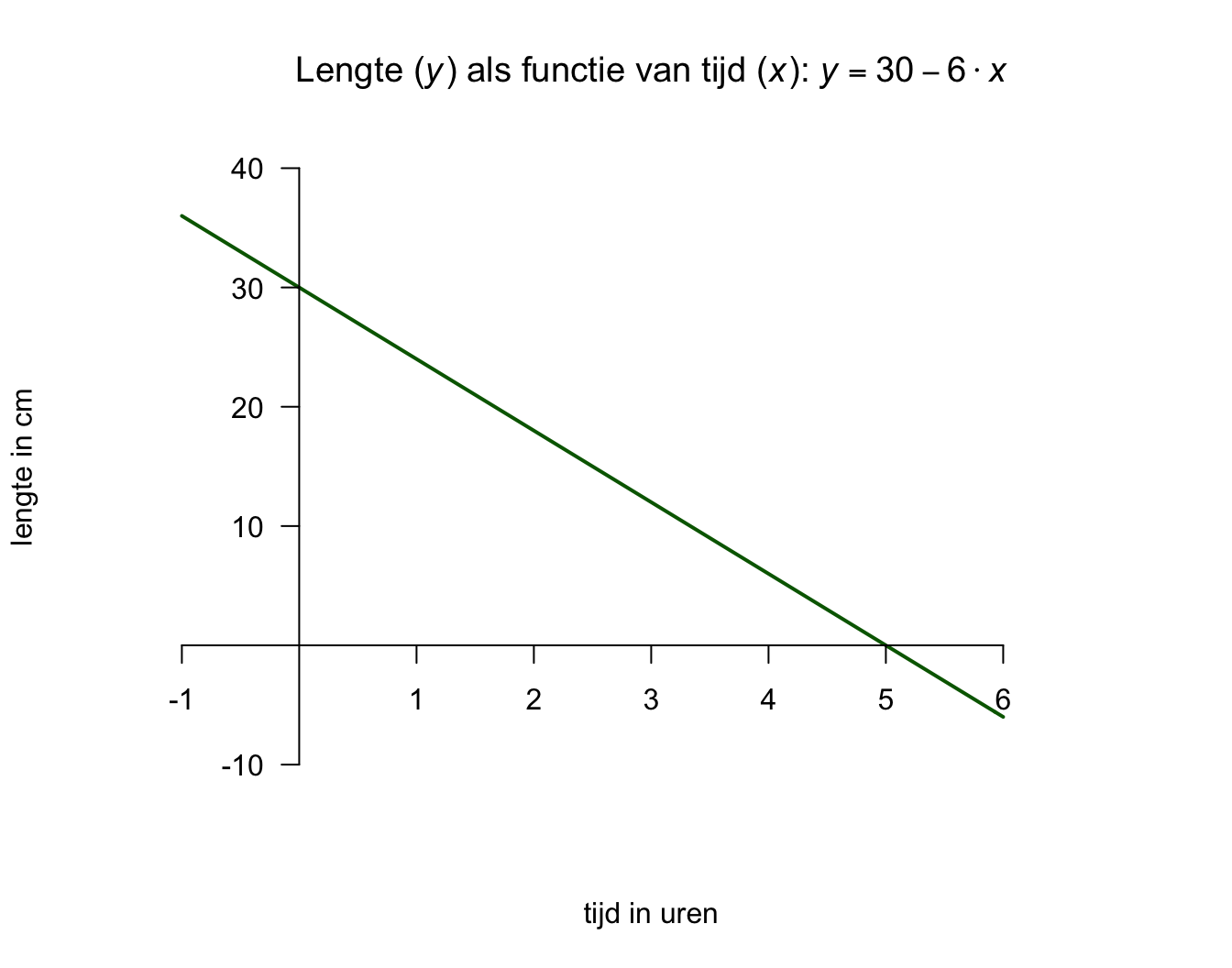

Denk even aan een kaars, zo’n romantische, op tafel tijdens een diner. Hoe lang zou die zijn qua lengte? Het antwoord hangt af van minimaal drie zaken. De eerste van de drie belangrijkste zaken, is hoelang de kaars was op het moment dat hij werd aangestoken. Het tweede aspect, is hoe snel de kaars korter word (hoe snel het kaarsvet smelt en dan verbrand). Hoe snel die kaars brand, hangt weer van een heleboel andere zaken af, zoals temperatuur in de kamer, luchtdruk en bijvoorbeeld tocht. Maar ik wil het alleen even hebben over de begin lengte van die kaars, en de snelheid waarmee hij korter wordt. Het derde aspect is de tijd dat de kaars gebrand heeft, hoe langer hij brand hoe korter die zal zijn. Stel dat deze kaars \(30\) cm was, toen hij net werd aan gestoken (toen je dus net aan tafel ging zitten en besloot om hem aan te steken). En zeg dat deze kaars - per uur – ongeveer 6 cm korter wordt. Met deze informatie kunnen we voor – ieder tijdstip tijdens dat etentje – dus uitrekenen of voorspellen wat (ongeveer) de lengte is van die kaars met de volgende formule (model):

\[\begin{aligned} \text{lengte kaars} = 30 – 6 \cdot \text{aantal uur} \end{aligned}\]

of in termen van \(x\) en \(y\):

\(\:\:\:\:\:\:y = 30 – 6 \cdot x\:\:\) of \(y\) als lineaire functie van \(x\)

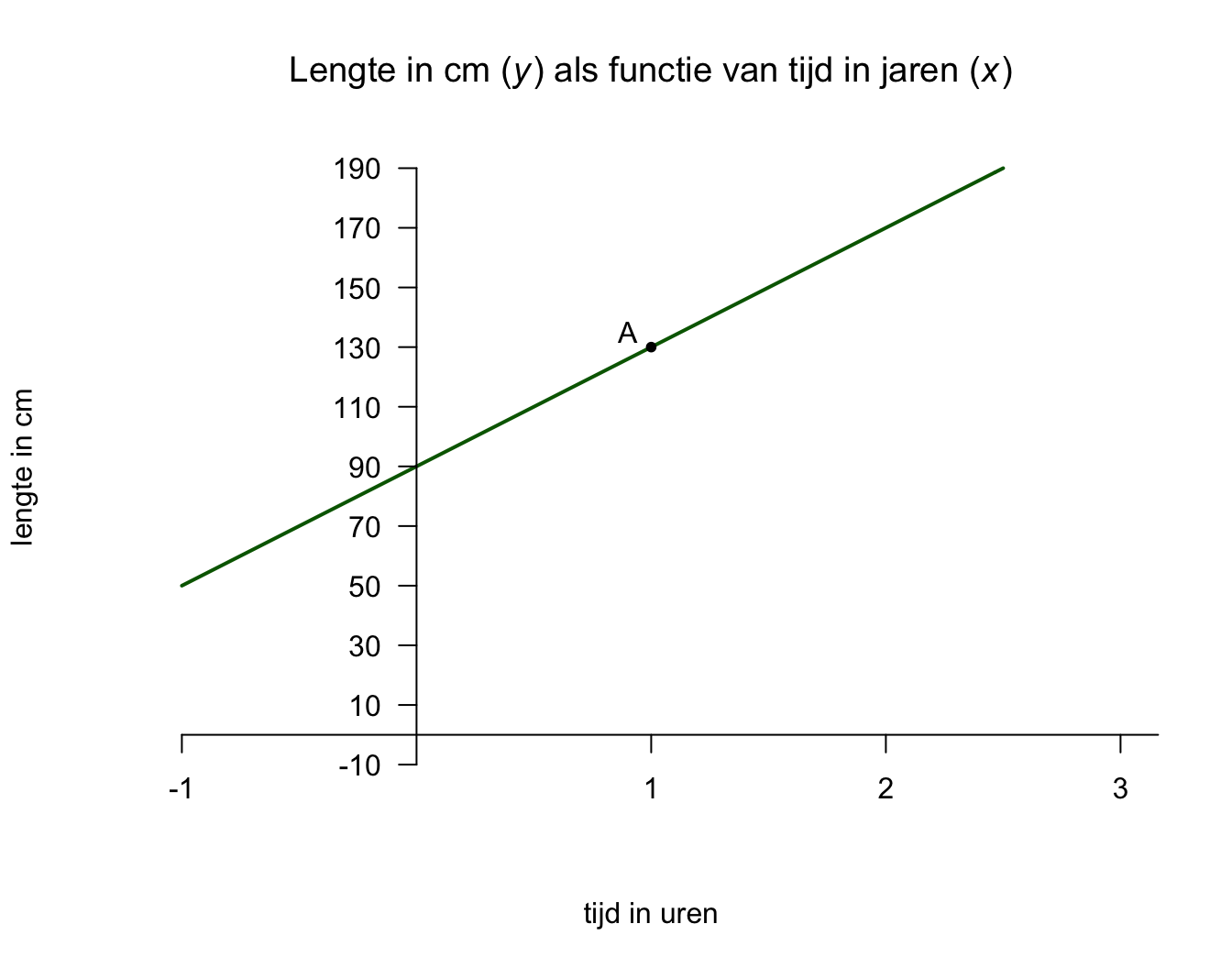

Een formule van de vorm zoals hierboven, noemen we ook wel een ‘lineaire vergelijking’ (eerste graadsvergelijking). Als je de formule als grafiek of lijntje tekent (zie figuur 5.1), wordt duidelijk waarom dit model (de vergelijking), een lineair model wordt genoemd. Een lineaire vergelijking (model), is voor te stellen als een rechte lijn in een grafiek. Als je te maken zou hebben met een quadratische vergelijking (tweedegraadsvergelijking), dan zie je altijd een kwadraatje bij de ‘\(x\)’ in de formule staan (bijvoorbeeld \(y = 30 - 6 \cdot x^2\)) en grafisch heb je dan te maken met een kromme lijn (een parabool in dit geval). Er bestaan tal van soorten vergelijkingen, dus ook verschillende vormen van lijnen, wij houden het voorlopig lekker recht, dus lineair.

Figuur 5.1: De Romantische Kaars

Moeilijk gezegd, kunnen we nu de ‘lengte van de kaars’ uitdrukken in (beschrijven in termen van) het ‘aantal uren’ dat die kaars gebrand heeft. Anders gezegd, je kunt de tijd (\(x\)) gebruiken om de lengte uit te rekenen. Denk dus aan een machientje (formule) die iets maakt (\(y\), het resultaat) door eerst iets anders (\(x\), de input) in dat machientje te gooien. Als ik er \(3\) uur (\(x=3\)) in gooi, doet het machientje dus voor mij: \(30 - 6 \cdot 3 = 12\), en spuugt het machientje er dus de waarde \(12\) (\(y = 12\)) uit. Dus je kan zeggen dat \(y\) het gevolg is van \(x\)

- De lengte van de kaars (\(y\)) is afhankelijk van drie dingen:

- Hoelang de kaars was toen hij werd aangestoken op tijdstip \(x = 0\)

- De brand-snelheid, gemeten in cm per uur

- De tijd dat de kaars gebrand heeft (gemeten in aantal uren, \(x\))

We zeggen ook wel dat dit een linear model twee parameters heeft, namelijk het ‘startgetal’ en het ‘hellingsgetal’ en we hebben voor onze kaars dus twee vaste waarden in de formule staan (respectievelijk \(30\) en \(-6\)), alleen de \(x\)-waarde die je erin stopt kan dus variëren. Het startgetal (bij ons de waarde \(30\)) noemen we vaak het intercept (ook wel de hoogte van het snijpunt van de lijn met de \(y\)-as) en staat dus voor de waarde van \(y\) als \(x\) een waarde van nul heeft. Dus zeg maar de hoogte van \(y\) (of de lijn, want dat is y) precies waar \(x\) ‘start’. Onze kaars heeft een (start-) lengte van \(30\) cm op tijdstip \(x = 0\).

Het hellingsgetal (bij ons de waarde \(-6\) in de formule) noemen we vaak de richtingscoëfficiënt (of de slope) van de de lijn en vertelt ons hoe snel de lijn daalt of stijgt. Onze kaars wordt \(6\) cm per uur korter. Omdat de kaars dus korter wordt, noemen we het verband, tussen \(x\) en \(y\) negatief. We kunnen nu dus zeggen dat voor elk uur dat het diner vordert (\(x\) dus met één eenheid toeneemt), de lengte van de kaars met \(6\) cm afneemt. Stel dat we nog niet zouden weten hoelang de kaars was bij het begin, en ook niet hoe snel die korter wordt en toch een vast een algemene formule willen opstellen, dan ziet die formule er als volgt uit:

\[\begin{aligned} y = \text{intercept} + \text{slope} \cdot x \end{aligned}\] of omdat we graag symbolen gebruiken:

\(\:\:\:\:\:\:y = a + b \cdot x\) of op zijn kortst \(\:\:\:\:\:\:y = a + bx\)

Hierin is \(a\) het intercept en \(b\) de slope, of in een andere vorm:

\(\:\:\:\:\:\:y = a \cdot x + b\) (zo heb je hem vroeger op school gehad)

hierin is \(a\) juist de slope en \(b\) het intercept. Het intercept of startgetal, staat altijd los en de slope zit altijd vast aan de \(x\) en geeft daarmee de weging (of het gewicht) aan \(x\). Wij gebruiken meestal de vorm waarin eerst het intercept wordt vermeld.

De variabele \(x\) noemen we de ‘voorspeller’ of predictor en is daarmee de ‘onafhankelijke variabele’ (of denk ‘input’ of ‘oorzaak’). De \(y\)-variabele is hier de ‘voorspelde’ variabele en is daarmee de ‘afhankelijke variabele’ (het antwoord, de uitkomst, output, de respons of criterium variabele, of denk dus: ‘gevolg’). Voorlopig mag je wel even voelen alsof \(y\) écht het gevolg is van \(x\) (en \(x\) dus de oorzaak van \(y\)), zolang je maar geen causale uitspraken doet. Voelen wel, zeggen dus niet, heel gevaarlijk!

- Dus bij een formule in de vorm van ’\(y = a + bx\)’we zeggen ook wel:

- \(y\) als functie van \(x\),

- \(y\) uitgedrukt in (termen van) \(x\).

- \(y\) als gevolg van \(x\)

- \(y\) als criterium van \(x\)

- \(y\) als bereik van \(x\)

- \(x\) als oorzaak van \(y\)

- \(x\) als voorspeller van \(y\)

- \(x\) als predictor van \(y\)

In het geval van de kaars is de lengte (\(y\)) niet een direct causaal gevolg van de tijd (\(x\)). Het feit dat de kaars korter wordt, komt puur door de verbranding en niet door de tijd. Maar omdat de kaars systematisch (met de zelfde snelheid) korter wordt, kunnen we dus toch tijd (\(x\)) gebruiken om de lengte (\(y\)) uit te drukken of te voorspellen.

Je ziet nu dat we met een model te maken hebben, dat eigenlijk gewoon een recht (lineair) lijntje is, dat schuin naar beneden loopt. De hoogte (\(y\)) van deze lijn staat voor de lengte van de kaars en wordt steeds minder naarmate het aantal uren toeneemt. Op tijdstip \(x = 0\) is de kaars \(30\) cm en zal elk uur, \(6\) cm korter worden. Naar mate de kaars langer brandt, zal hij dus kleiner worden (duh!). Aan de hand van de grafiek (of formule) kunnen we nu aflezen (of uitrekenen) hoe lang de kaars op een bepaald (specifiek) moment ongeveer zal zijn. Dit betekent dus dat we een nieuw voorspel-model hebben. Natuurlijk is dit nieuwe voorspel-model beter dan het meest simpele model of voorspelling, het grote gemiddelde (de gemiddelde lengte berekend over alle verschillende lengtes van de kaars gedurende het hele diner). We weten natuurlijk (nog) niet precies hoe goed ons nieuwe model zal kloppen. In het (onverwachte) geval van – een veel te – romantisch etentje, kan die kaars misschien die hitte niet aan en smelt dan toch echt sneller dan verwacht op basis van ons model (begin hoogte \(30\) cm en \(6\) cm per uur korter). Any way, we hebben nu dus de lengte van de kaars uitgedrukt in tijd en dus een complexer (en vast wel beter) model gebouwd dan het grote gemiddelde van alle mogelijke lengtes van die kaars. Nu maar wel hopen dat het diner niet langer duurt dan vijf uur (\(x = 5\)), want volgens mij is het dan toch echt gedaan met de pret (of je huis staat in vlammen). Laten we ons richten op de aapjes en kijken hoe goed we hun geobserveerde lengtes kunnen voorspellen op basis van hun leeftijden aan de hand van een enkelvoudig lineair regressie-model.

5.3 De Enkelvoudige Lineaire Regressie-vergelijking, de Regressie-lijn

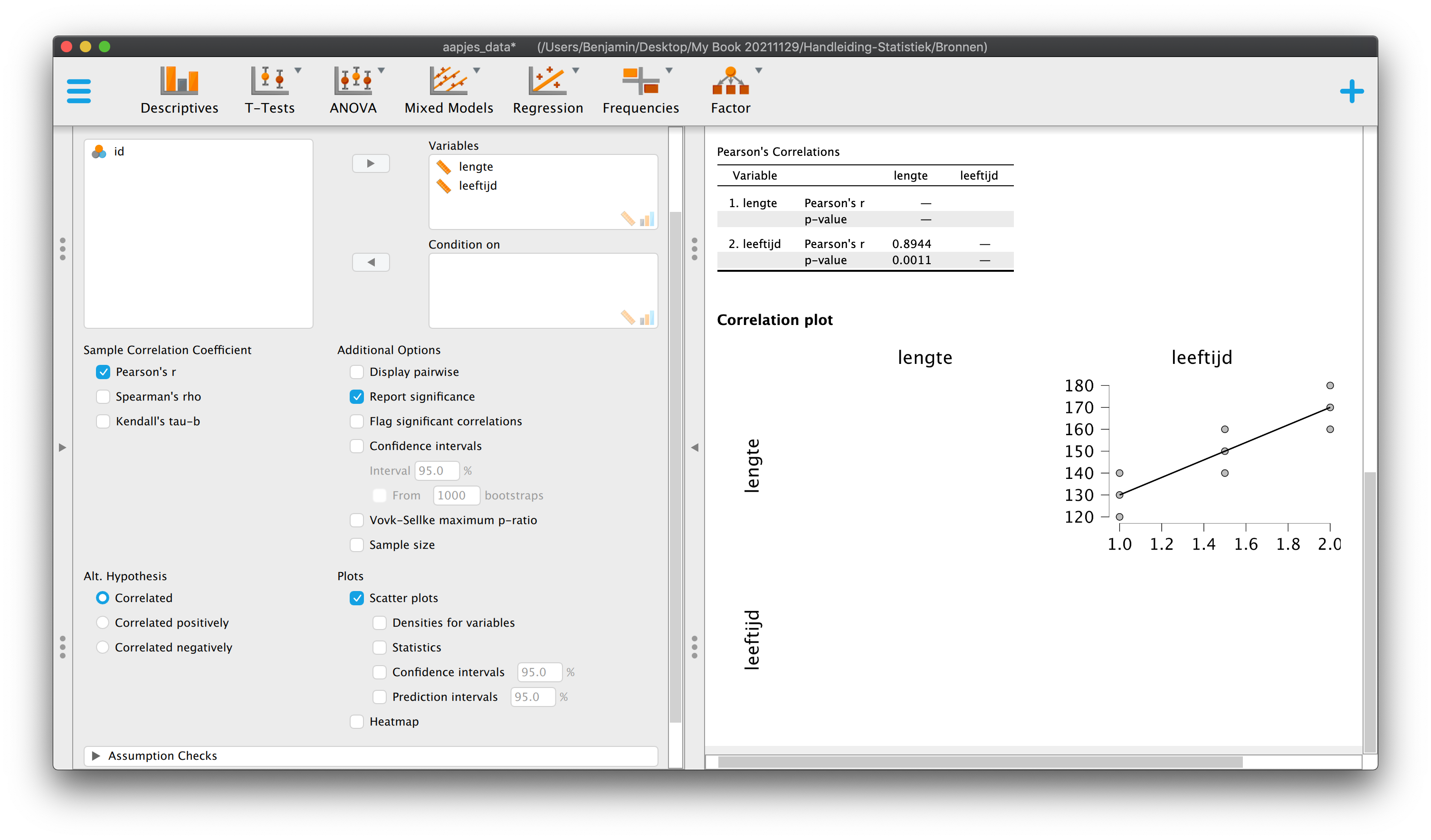

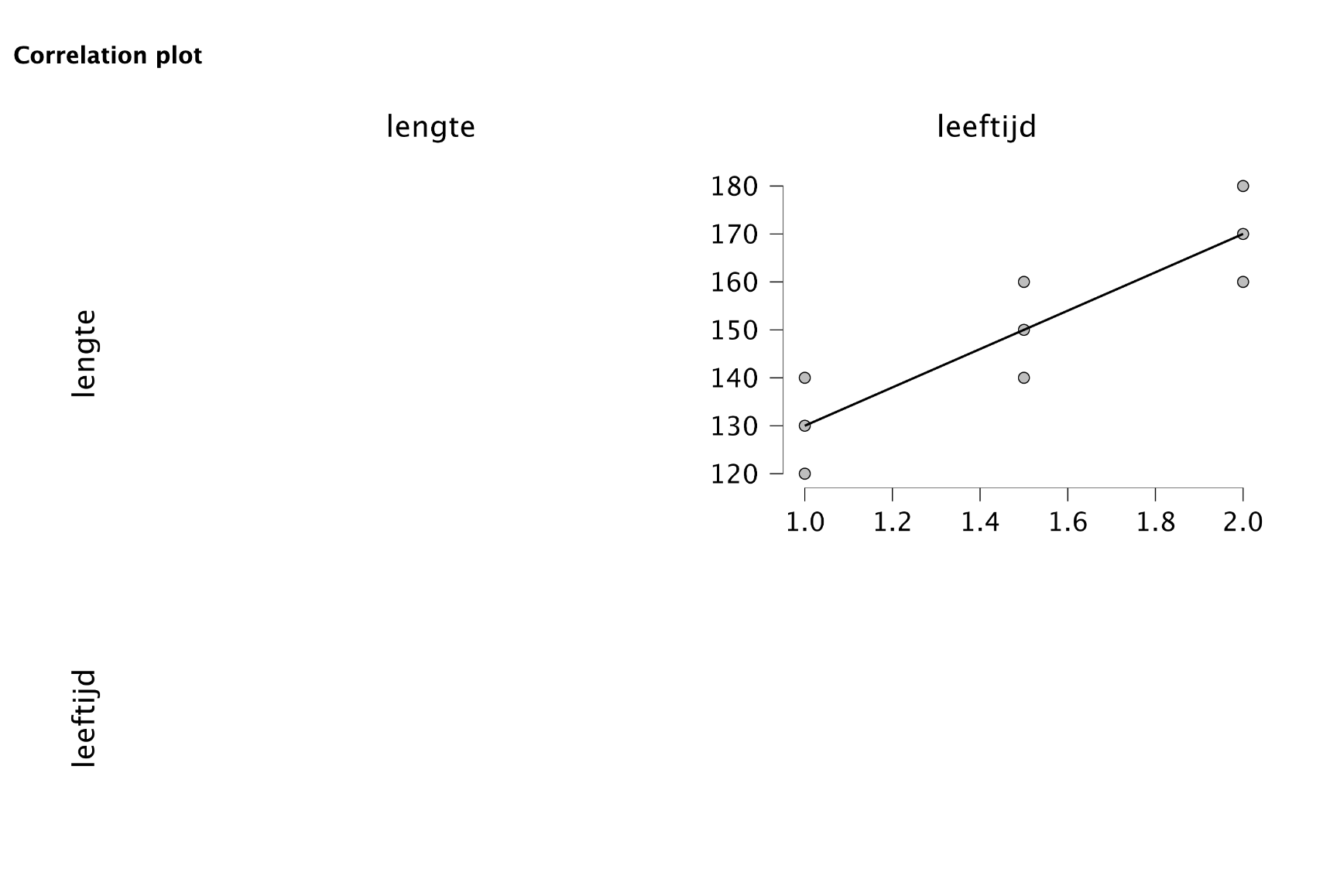

In de statistiek en de wetenschap draait alles om het verklaren en het voorspellen van zaken, in en om ons heen. Als er verband is tussen twee variabelen, kunnen we een beter model maken dan het nul-model (het grote gemiddelde als beste voorspelling). Met een nieuw (en iets ingewikkelder) model, kunnen we – gemiddeld gezien - beter gokken. Door deze nieuwe manier van voorspellen wordt (hopelijk) de gemiddelde gok-fout dus substantieel kleiner. Het meest basale model (verwachting, voorspelling van de werkelijkheid) dat we inmiddels kennen, is het grote gemiddelde. We noemen dit vaak ook wel het intercept-model of het nul-model. Bij de aapjes was het grote gemiddelde \(150\) cm en dus onze beste gok als we nog geen gebruik maken van informatie over hun leeftijd. We hebben gezien (Hoofdstuk 3) dat er tussen leeftijd en lengte bij onze aapjes een positief verband is (\(r_{xy} = .8944\)) en dat de puntenwolk dus van linksonder naar rechtsboven loopt, via een rechtlijnig (lineair) verband. Je zou dus ook wel kunnen zeggen dat de essentie (of hier ook wel samenvattende beschrijving) van de puntenwolk, een rechte lijn, schuin omhoog is. Deze lijn wordt zodanig door de puntenwolk heen getrokken dat alle negen punten er zo dicht mogelijk bij liggen (de verticale afstanden van een punt tot de lijn, zijn gemiddeld gezien, zo klein mogelijk). We gebruiken deze lijn nu als nieuwe (hopelijk betere) voorspelling dan het grote gemiddelde op \(Y\). We zeggen nu dus dat de hoogte van de regressielijn (die bij elke waarde van \(X\) anders is, vanwege het verband tussen x en y) voor de voorspelde waarde van \(Y\) (lengte) staat, met als symbool:

\(\:\:\:\:\:\:\hat{Y}_i\:\:\) De voorspelde waarde van \(Y\) voor subjectnummer \(i\), of predicted value of \(Y\)

We spreken ‘\(\hat{Y}_i\)’ ook wel uit als ‘Y-dakje’ of in het Engels als ‘Y-hat’. \(\hat{Y}_i\) kun je uitrekenen met de volgende algemene formule, de lineaire regressie-vergelijking (net gebruikte ik \(a\) en \(b\) als parameters, zoals op school vroeger, maar nu spreken we het dus anders af):

\(\:\:\:\:\:\:y = \text{intercept} + \text{slope} \cdot x\)

of omdat we graag symbolen gebruiken:

\(\:\:\:\:\:\:\hat{Y}_i = b_0 + b_1 \cdot X_{i}\)

Als regressie-vergelijking voor je steekproef met \(b_0\) als intercept en \(b_1\) als slope. \(b_0\) en \(b_1\) zijn dus statistieken en statistieken zijn de schatters (estimates) van bijbehorende parameters voor de populatie:

\(\:\:\:\:\:\:\hat{Y}_i = \beta_0 + \beta_1 \cdot X_{i}\)

Als regressievergelijking voor de populatie, waarin ‘\(\beta_0\)’ het populatie-intercept voorstelt en ‘\(\beta_1\)’ populatieslope. De echte waarden hiervan kunnen we dus alleen maar over dromen!

Het symbool ‘\(\hat{Y}_i\)’,dus \(Y\) met een dakje, is dus niet hetzelfde als de geobserveerde waarde van \(Y\) (\(Y_i\)). De geobserveerde waarde van \(Y\)is die waarde qua lengte, die we écht gemeten (geobserveerd) hebben. De (hoogte van de) regressielijn (voor of bij, een bepaalde waarde van \(X\)) is dus wél hetzelfde als \(\hat{Y}_i\) en staat voor die waarde die je zou geven als beste voorspelling als je wél informatie over \(X\) (leeftijd) tot je beschikking hebt. Laat alsjeblieft duidelijk zijn dat zowel bij kaarsen als bij aapjes, je nieuwe voorspelling nog steeds niet altijd perfect hoeft te zijn. Ik wil hier mee dus zeggen dat de geobserveerde waarde, heel vaak, toch even iets anders is dan je voorspelde waarde.

5.3.1 Slope en Intercept, Old School

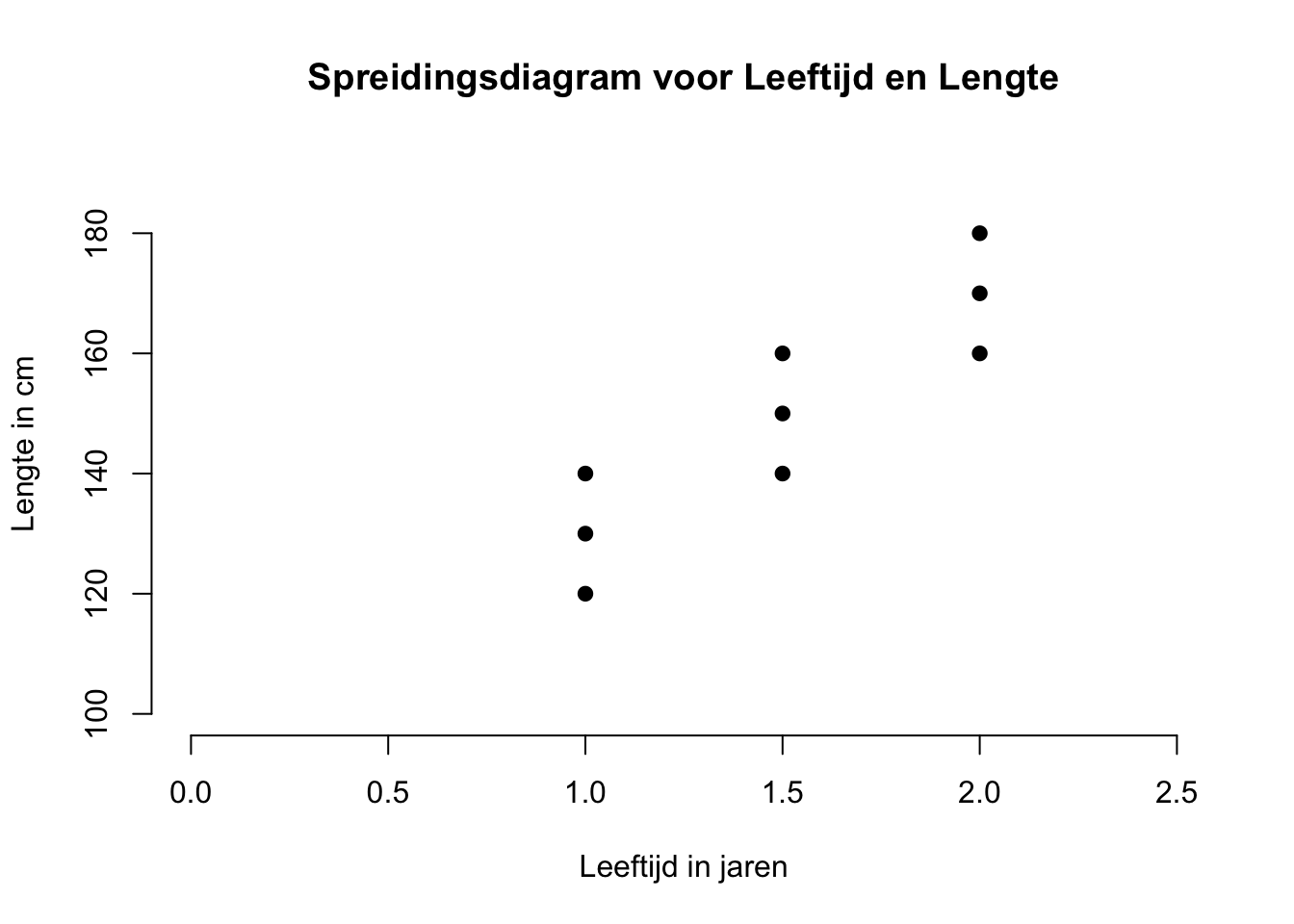

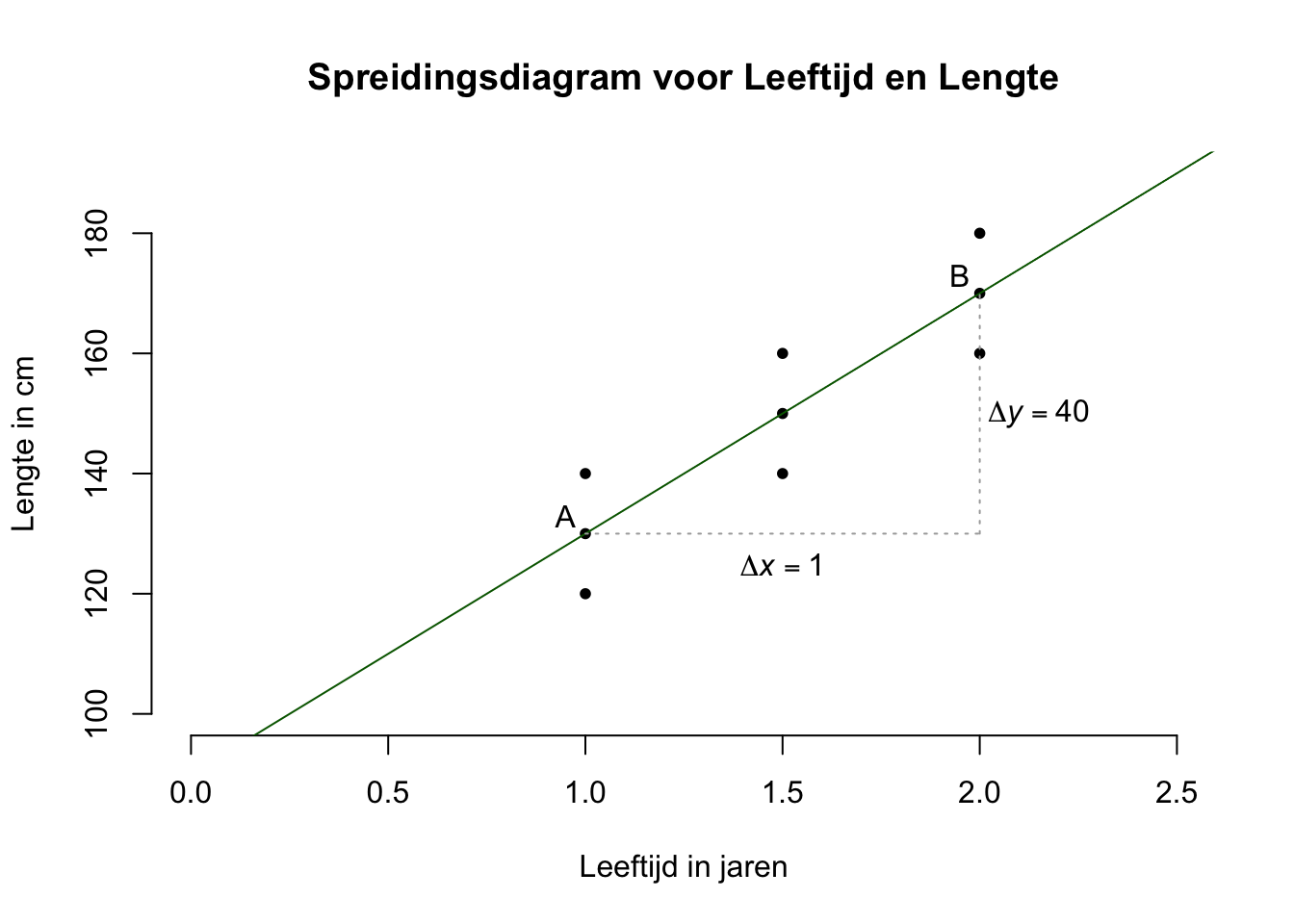

Om het woord ‘regressie’ beter te begrijpen, zou je ook kunnen zeggen dat je de geobserveerde waarden van \(Y\) terug-brengt (re-gressie) naar de \(X\) waarden (uitdrukt in \(X\)-waarden). Je kijkt dan dus of op basis van de \(X\)-waarden, of de \(Y\)-waarden (beter) verklaard kunnen worden (dan het nulmodel). Laten we eerst maar kijken of we de ligging (positie) van de lijn, voor onze aapjes kunnen bepalen aan de hand van de puntenwolk (zie figuur hieronder).

Figuur 5.2: -

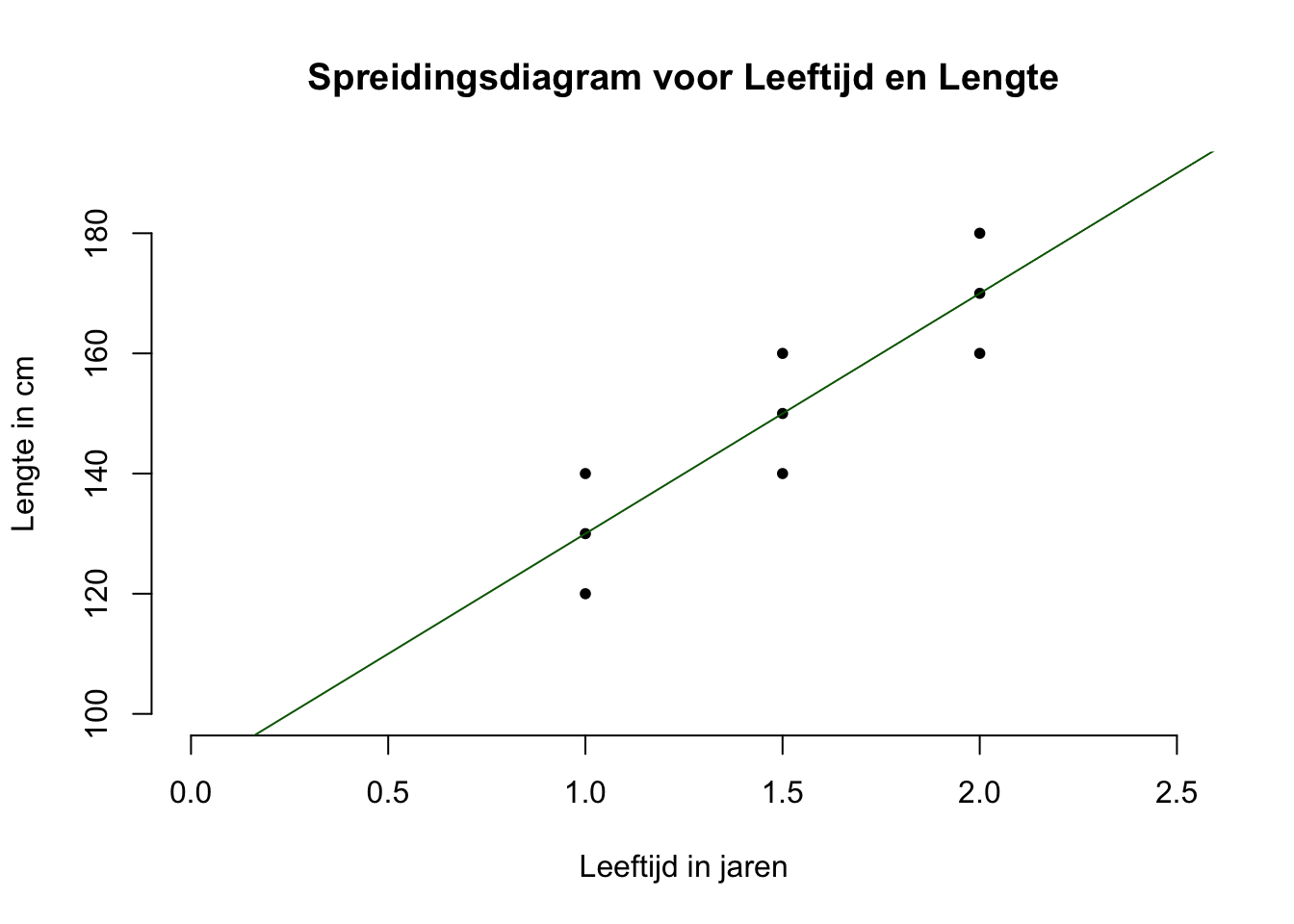

In figuur is het hopelijk over-duidelijk wat de ligging of positie van de lijn moet zijn als je dus, met een mes op je keel, er zodanig een lijntje doorheen moet trekken, dat alle negen puntjes (observaties) er zo dicht mogelijk bij in de buurt moeten liggen. Maar bij ‘echte’ data (waar je veel meer puntjes ziet en de puntenwolk er misschien niet zo strak eruit ziet) is dat natuurlijk moeilijker te zien, maar wel ongeveer te schatten. De ligging van een regressie-lijn kan natuurlijk ook berekend worden door formules voor \(b_0\) en \(b_1\) in te vullen (of een programma als JASP of R te gebruiken). Die komen zo, maar eerst de bepaling van het intercept en de slope, aan de hand van onze grafiek. Als we hier een (zo goed mogelijk passende) lijn door de puntenwolk willen trekken (schetsen), zal die – bij elke waarde van \(X\) – precies door de middelste puntjes moeten worden getrokken (zie figuur hieronder). Voor precies deze positie, liggen de \(9\) punten, gemiddeld gezien, het dichtst bij de regressielijn (verticaal gezien):

Figuur 5.3: -

Een regressie-lijn (of model) heeft twee parameters (of statistieken in geval van steekproef) die ons precies vertellen hoe we de lijn zouden moeten tekenen (mochten we zelf een plaatjevervan maken, dus van statistieken naar plaatje). Maar wij gaan van plaatje terug naar statistieken.

We beginnen met de slope, dus de helling van de regressielijn:

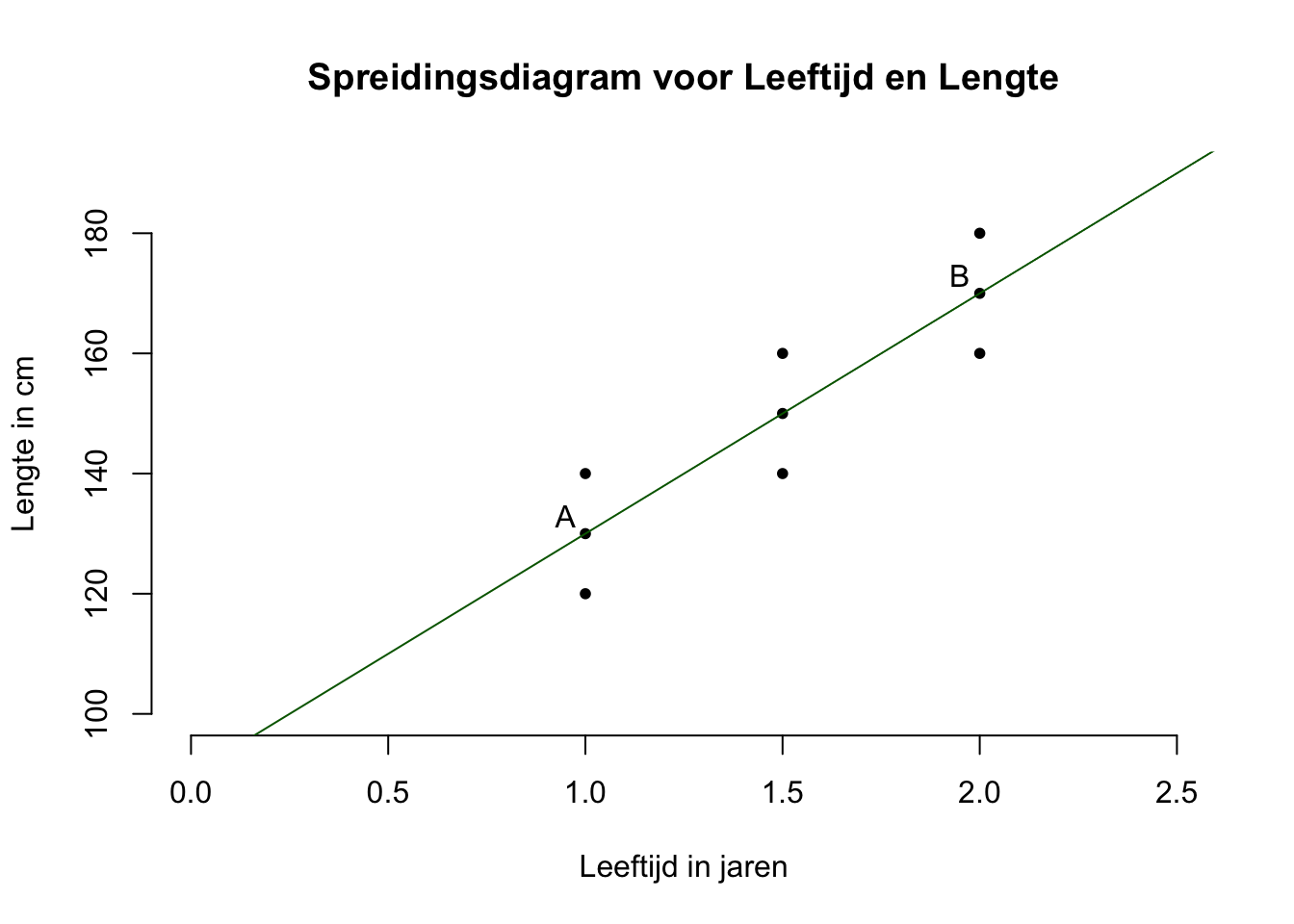

Eerst schatten we de waarde van de slope door twee punten te zoeken die op de lijn liggen. Neem bijvoorbeeld eerst het punt A (maar elk denkbeeldig punt is prima) met bijbehorende coördinaten \(A(x_A = 1.0; y_A = 130)\), of kortweg: \(A(1.0; 130)\), zie hieronder. Dan nog een punt, zeg punt B, ook gewoon ergens op de regressielijn. Ik heb gekozen voor \(B(x_B = 2.0; y_B = 170)\).

Figuur 5.4: -

Hoeveel eenheden (in jaren) moet je naar rechts (horizontaal), en hoeveel eenheden (in cm) moet je vervolgens omhoog (verticaal) wandelen, om van punt A naar punt B te komen?

Figuur 5.5: -

Vanuit punt A, moet je dus \(1\) eenheid (in jaren, \(\Delta x = 1\), staat voor Delta of verschil in \(x\)-waarde is dus \(1\), ook wel: \(\Delta x = x_B - x_A = 2 -1 =1\)) naar rechts wandelen (dan zit je precies onder punt B), en vervolgens wandel je \(40\) eenheden (in cm) omhoog, om op punt B uit te komen. Anders gezegd als \(X\) met precies \(1\) eenheid toeneemt, dan is de lijn precies \(40\) cm hoger. Omdat de lijn recht is en dus overal de zelfde helling heeft, stijgt de lijn met \(40\) cm per jaar. Als we \(2\) eenheden naar rechts waren gewandeld, hadden we dus \(2\) keer \(40\) cm (dus \(80\) cm) omhoog gemoeten. Als je de helling van een lijn wilt weten, kijk je dus hoeveel de \(Y\)-waarde van de lijn toeneemt (afnemen kan ook natuurlijk) per toename van \(1\) eenheid voor \(X\). Misschien weet je nog van vroeger als je de richtingscoëfficiënt (slope) wilt op basis van twee punten op een rechte lijn, kan je dat met de volgende formule (maar je mag het vergeten, want in de statistiek doen we het anders):

\(\:\:\:\:\:\:\text{richtingscoëfficiënt} = \frac{\Delta y}{\Delta x} = \frac{y_A - y_B}{x_A - x_B} = \frac{130-170}{1-2} = \frac{-40}{-1} = 40\)

Bij ons heeft de richtingscoëfficiënt of slope dus een waarde van \(40\) Eigenlijk gewoon de groeisnelheid van aapjes (in cm per jaar) dus. Uiteraard zullen aapjes niet eeuwig (even snel) blijven groeien, maar deze groei-trend (\(40\) cm per jaar) geldt in ieder geval voor onze aapjes, voor hun waarden van \(X\).

Nu het intercept, dus de hoogte van de regressielijn waar die de \(Y\)-as snijdt:

Helaas laat ons plaatje niet de ‘echte’ \(x\)-en \(y\)-as zien (waar je ook de oorsprong, dus het punt met \(x = 0\) en \(y = 0\) ziet), Dus ik teken hem even voor je:

Figuur 5.6: -

Om nu (de hoogte van) de start-positie of het intercept te bepalen van het lijntje te bepalen, kijk je bij welke hoogte de lijn de \(y\)-as snijdt. Dus bij \(y = 90\). Soms zie je de echte y-as dus niet en dan zou je het ook kunnen beredeneren: Zo zou je bijvoorbeeld vanuit punt A (met \(x_A = 1\)) horizontaal naar de \(y\)-as kunnen wandelen, je zult dus één jaar naar links moeten wandelen, maar hoeveel moet je nu omlaag om weer op ons lijntje terecht te komen? Juist omdat de lijn recht is kunnen we dus ook terug redeneren. Eén eenheid naar links wandelen vanuit punt A, betekent dus nu \(40\) eenheden omlaag. Omdat punt A een hoogte had van \(y_A = 130\), komen we dus uit op de \(y\)-as op een hoogte van \(90\) cm, het snijpunt van de lijn met de \(y\)-as.

In formule vorm wordt onze regressievergelijking dus:

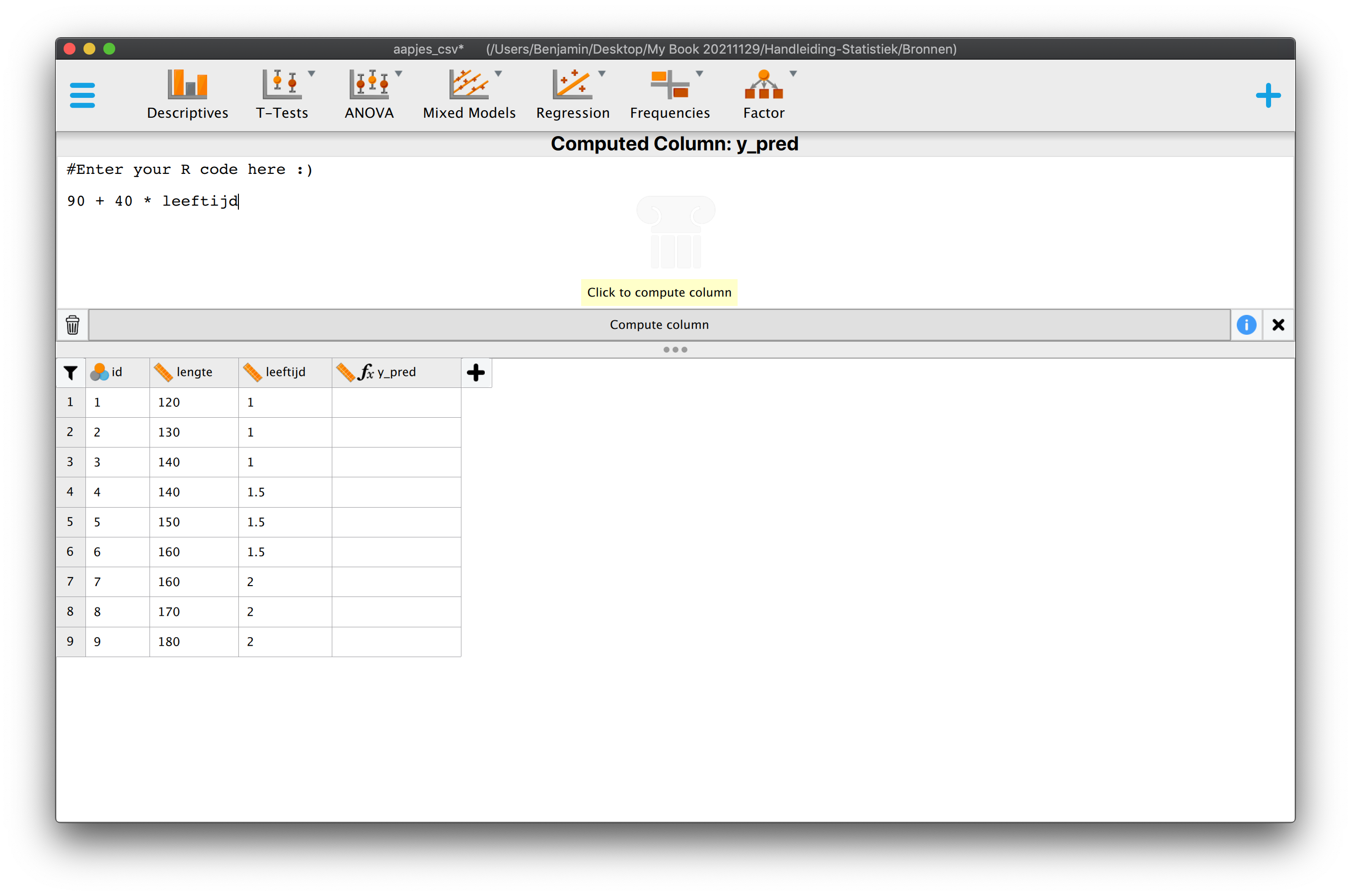

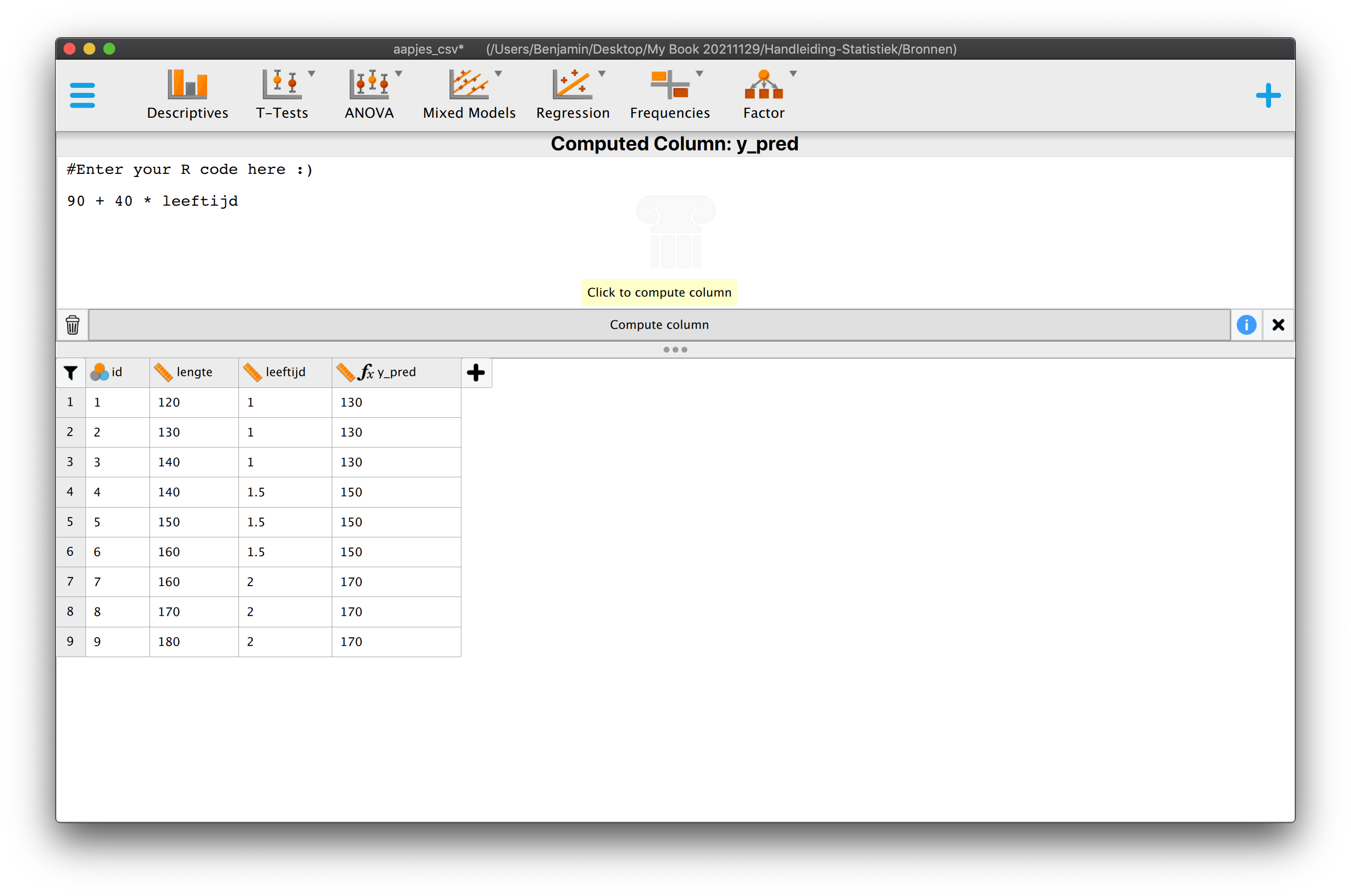

\(\:\:\:\:\:\:\hat{\text{lengte}}_i = 90 + 40 \cdot \text{leeftijd}_i\)

of in termen van \(Y\)-dakje en X;

\(\:\:\:\:\:\:\hat{Y}_i = 90 + 40 \cdot X_{i}\:\:\:\)

Je hebt dus nu een heuse regressie-vergelijking, onze voorspelformule! Het intercept dus de waarde \(90\) (\(b_0 = 90\)) en de slope heeft een waarde van \(40\) (\(b_1 = 40\)).

5.3.2 Slope en Intercept, For Real

Om je weer even te laten wennen aan grafieken hebben we hierboven even ouwerwets gedaan. Een schetst (kon bij ons heel precies) van de lijn en vervolgens gekeken wat de waarden van de slope en het intercept ongeveer zijn (kon bij ons dus ook heel precies). Normaal gezien is het helemaal niet zo duidelijk hoe de lijn precies moet lopen en kunnen we hem dus ook niet precies tekenen. Dus dan (of altijd dus) berekenen hem gewoon aan de hand van statistieken voor onze steekproef, die je zo langzamerhand al vast wel kan dromen (of inmiddels je keel uitkomen). Eerst maar de formules voor de slope en het intercept:

- Voor de slope, ofwel \(b_1\):

- \(b_1 = \frac{S_{xy}}{S_x^2}\:\:\:\) Hier heb je dus alleen de covariantie van \(X\) en \(Y\) nodig en de variantie van \(X\) nodig om de slope uit te rekenen. Of:

- \(b_1 = \frac{r_{xy}}{S_x \cdot S_y}\:\:\:\) Hier dus de correlatie en de twee standaardafwijkingen.

- Voor het intercept, ofwel \(b_0\):

- \(b_0 = \overline{Y} - b_1 \cdot \overline{X}\:\:\:\) Om het intercept uit te rekenen, heb je dus de slope en de twee gemiddelden nodig.

En nu gaan we dus de boel invullen onze gegevens (van de enige echte steekproef nog steeds):

- Onze statistieken:

- \(n=9\),

- \(\overline{Y} = 150\), \(S_y^2 = 375\),

- \(\overline{X} = 1.50\), \(S_x^2 = 0.1875\),

- \(S_{xy} = 7.5\), \(r_{xy} = .8944\) (afgerond op \(4\) decimalen)

- Invullen geeft, we beginnen met de slope en dan pas het intercept:

- \(b_1 = \frac{S_{xy}}{S_x^2} = 7.5/0.1875 = 40\:\:\:\) of;

- \(b_1 = \frac{.8944}{\sqrt{0.1875} \cdot \sqrt{375}} = .8944/(\sqrt{0.1875} \cdot \sqrt{375}) = 40\:\:\:\) Vergeet niet de wortel te trekken, ik had jullie immers de twee varianties gegeven,, terwijl we de standaardafwijkingen nodig hadden!

- \(b_0 = \overline{Y} - b_1 \cdot \overline{X} = 150 - 40 \cdot 1.5 = 90\)

- klopt wéér, fijn!

- \(b_0 = \overline{Y} - b_1 \cdot \overline{X} = 150 - 40 \cdot 1.5 = 90\)

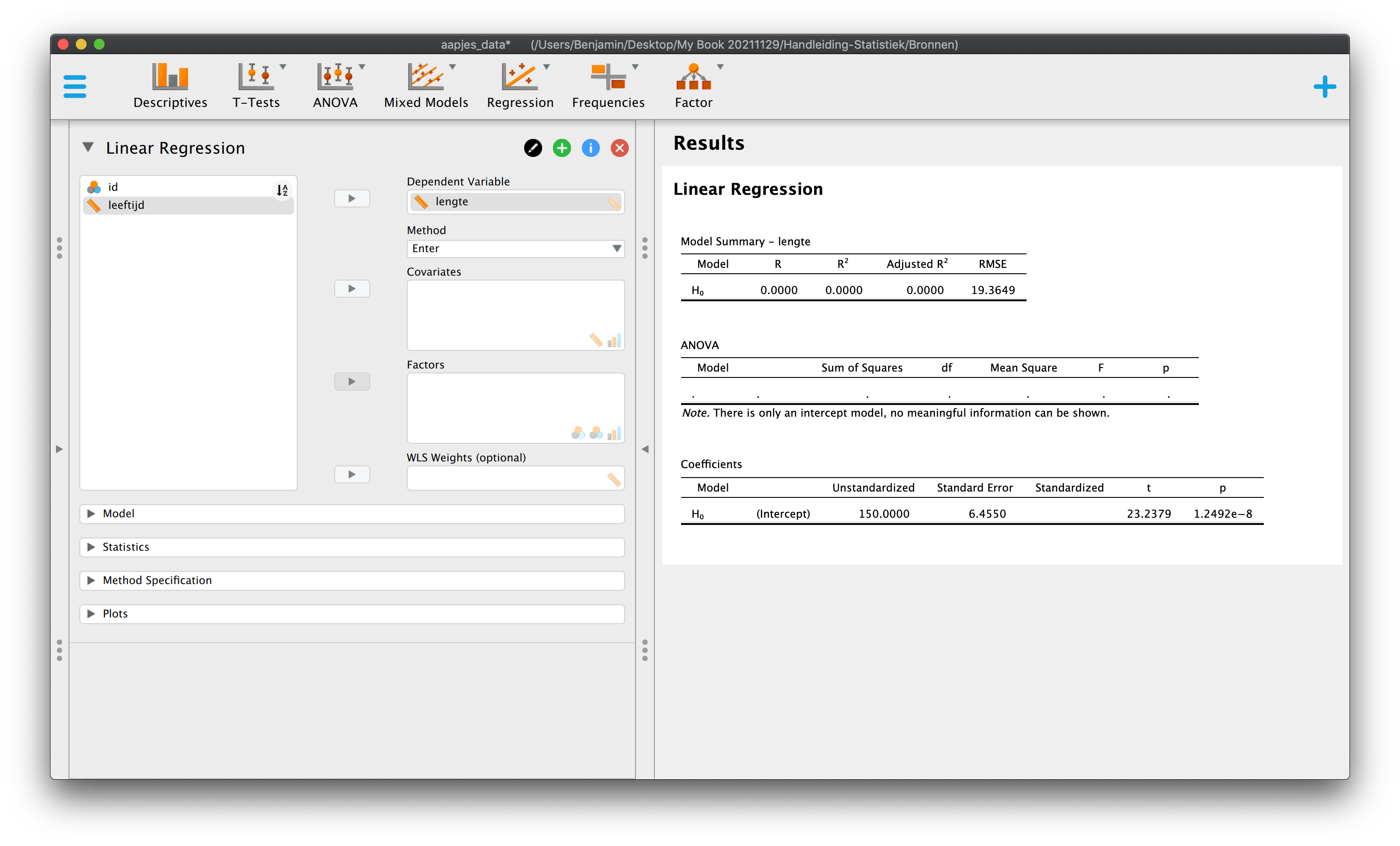

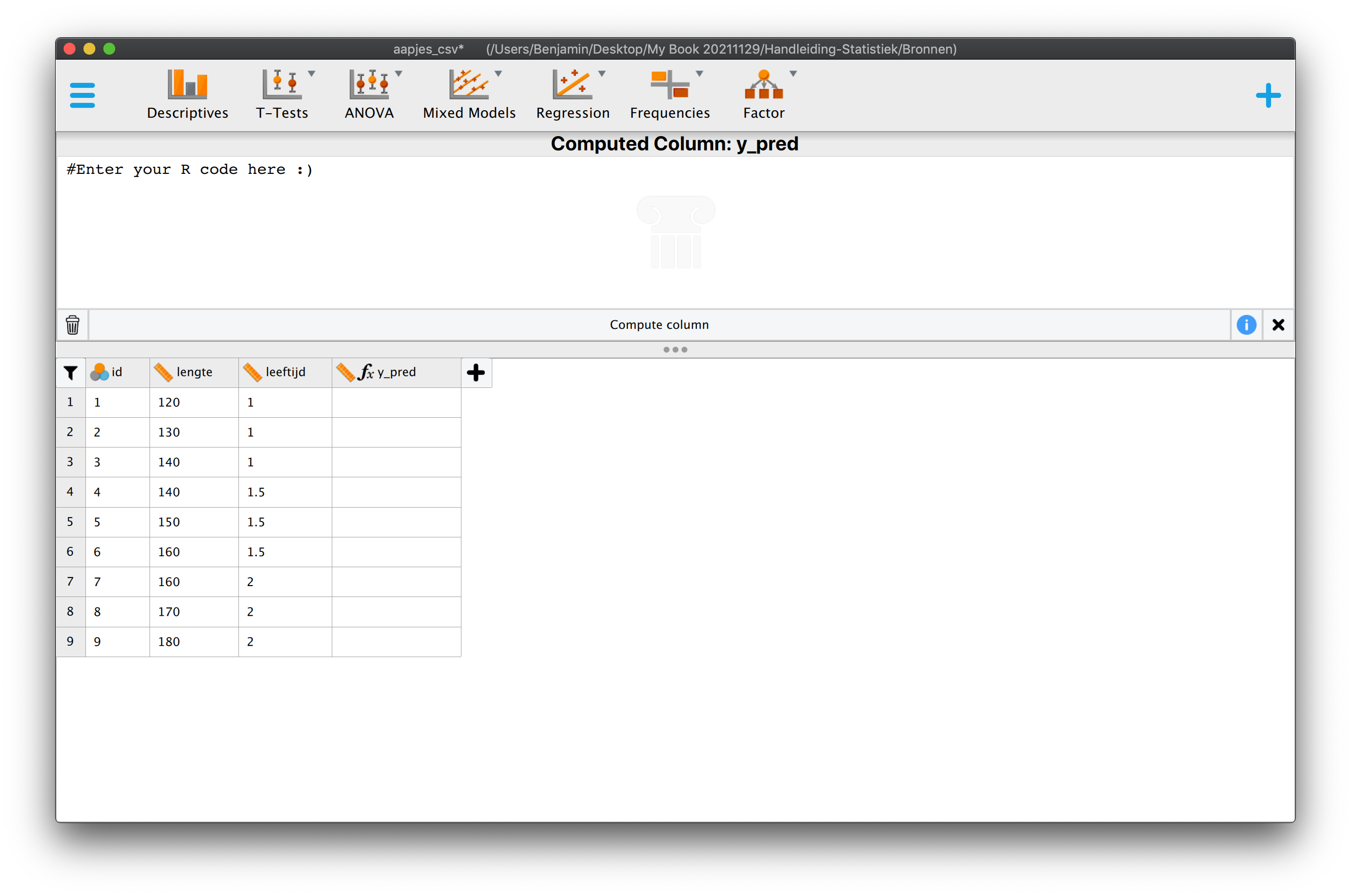

We kunnen nu dus eindelijk zeggen dat wat de regressie vergelijking, dus de voorspelformule is om op basis van leeftijd, de lengte te voorspellen:

\[\hat{Y}_i = 90 + 40 \cdot X_{i}\]

Zodat we voor ieder aapje (nummer \(i\)), op basis van zijn leeftijd, de waarde van zijn lengte kunnen voorspellen.

5.4 Voorspelkracht

Nu we weten hoe wat de ligging (positie) is van de regressie-lijn voor onze aapjes, willen we natuurlijk ook weten, hoe goed ons nieuw voorspel-modelletje (de regressie-vergelijking) werkt. Hoe krachtig is die nieuwe manier van voorspellen? Hoe groot zou de gemiddelde gok-fout zijn als (gegeven dat) we dit nieuwe model gebruiken? We willen dus weten hoe krachtig een model is qua voorspelling. Het mooie (in ieder geval voor mij) van dit hoofdstuk is dat de kern (of praktische essentie) van statistiek, eindelijk duidelijk gaat worden. Nieuwe begrippen die je hier leert, zijn toepasbaar (generaliseerbaar) op elk model. Of je nu spreekt over een gedachte (idee) als model (een verwachting), een trein-modelletje van je pappa, een foto-model van TV laatst, een regressie-model, een confirmatief factor model, of werkelijk wat dan ook, het maakt mij niet uit, want elk idee of model, komt in meer of mindere mate overeen, met datgeen wat we willen bereiken (representeren) of waar we naar op zoek zijn (of waar we echt van dromen). En waar zijn we naar op zoek? Een prettig leven voor jezelf en anderen, mag ik hopen, maar in de wetenschap, naar een zo goed mogelijke beschrijving van wat er (in en) om ons heen gebeurt. Al die aspecten van de werkelijkheid (datgeen wat we zien of observeren) kunnen voor een gedeelte verklaard worden, maar ook, voor een gedeelte niet. In dit hoofdstuk wordt duidelijk in hoeverre we de werkelijkheid (met een beter model dan het nul-model) kunnen verklaren, maar ook in hoeverre, of voor welke gedeelte, we de werkelijkheid niet kunnen verklaren. We keren snel terug naar ons voorspel-spelletje, maar nu aan de hand van ons nieuwe model, onze regressie-vergelijking.

5.4.1 Het Spel bij Regressie

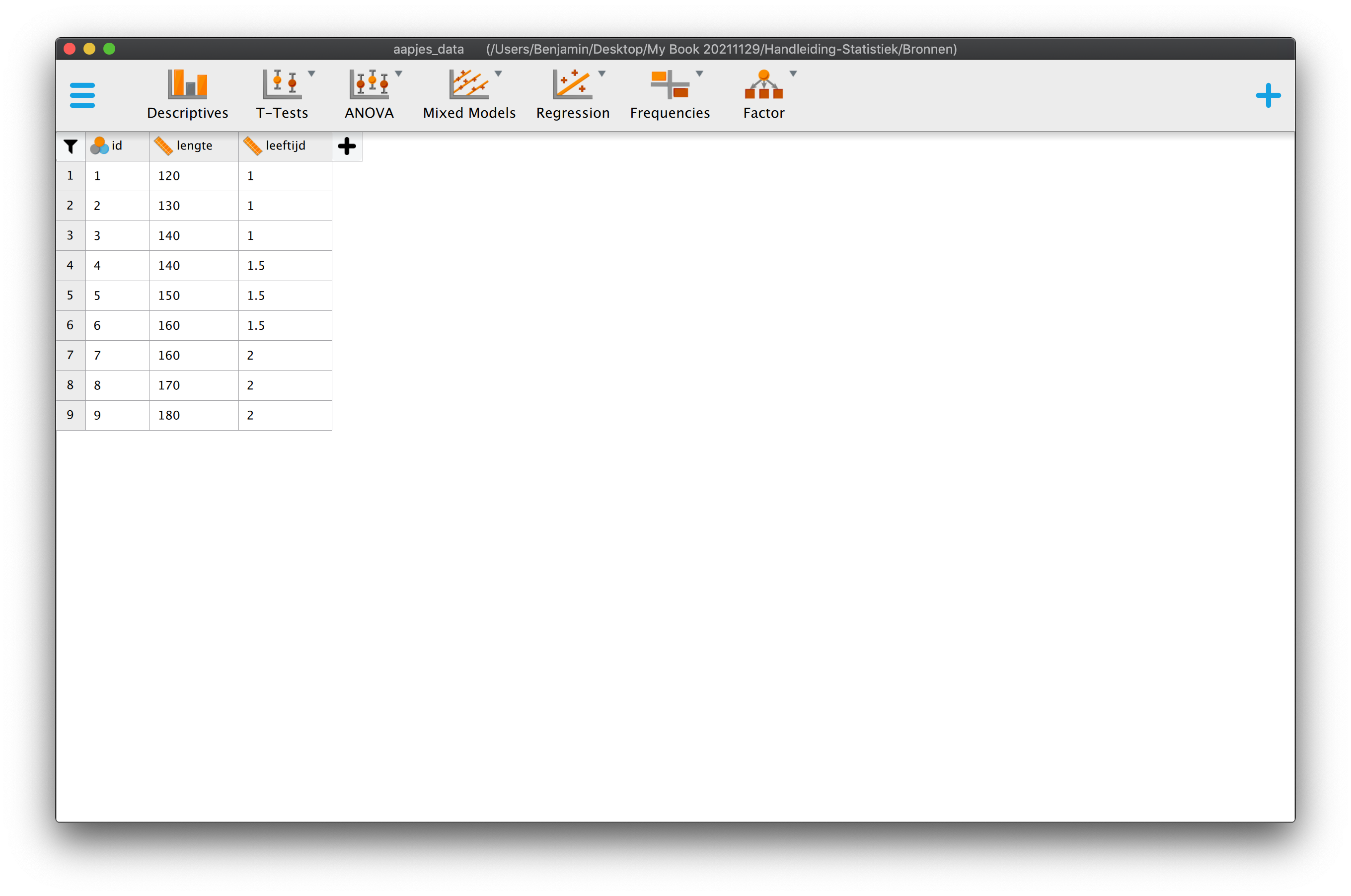

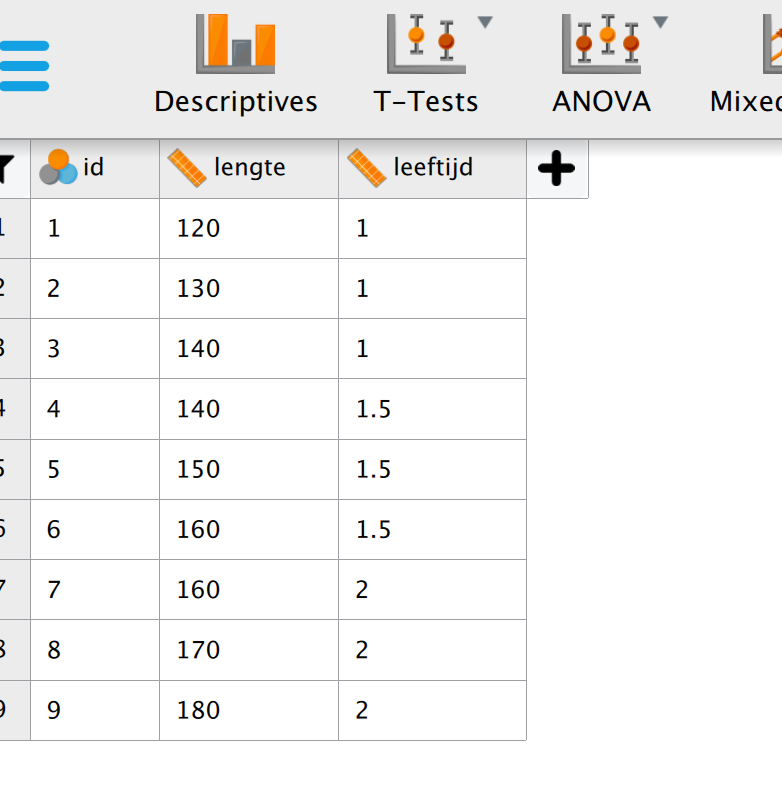

We beginnen vanaf het begin. Kijk naar de twee tabellen hieronder, je mag alle informatie (data-punten en statistieken) gebruiken die je ziet.

| \(i\) | \(Y_i\) | \(X_i\) |

|---|---|---|

| 1 | 120 | 1.0 |

| 2 | 130 | 1.0 |

| 3 | 140 | 1.0 |

| 4 | 140 | 1.5 |

| 5 | 150 | 1.5 |

| 6 | 160 | 1.5 |

| 7 | 160 | 2.0 |

| 8 | 170 | 2.0 |

| 9 | 180 | 2.0 |

| \(\overline{Y} = 150\) | \(\overline{X} = 1.50\) |

| \(S_y^2 = 375\) | \(S_x^2 = .1875\) |

| \(S_y = 19.365\) | \(S_x = 0.433\) |

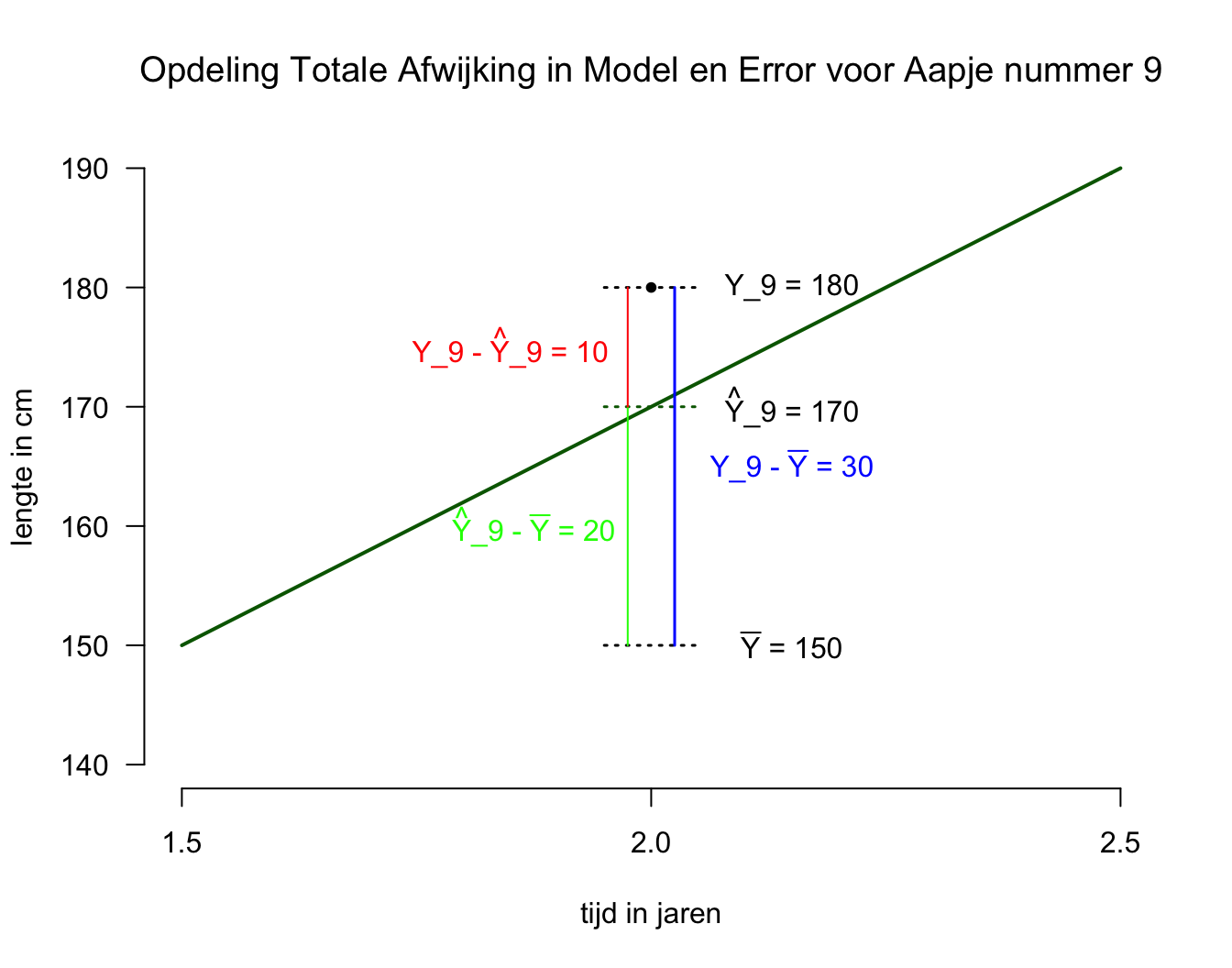

5.4.2 Opdeling van Totale Afwijking in Model en Error per Individu

Alle negen aapjes staan op de gang en er komt er slechts één binnen wandelen, natuurlijk vertel ik je niet welke (ik weet het stiekem wel).

Vraag 1 – Wat is je beste gok qua lengte als er een aapje binnen komt wandelen?

Je roept nu natuurlijk heel hard: ‘\(150\) cm, want dat is het grote gemiddelde (\(\overline{Y}=150\))’, ook wel het nul-model. Als je iets anders had geroepen (\(140\) cm of zo) dan zou de gemiddelde gok-fout groter worden en dat wil je natuurlijk niet! (\(150\) was het goede antwoord, heel goed!)

Even later… Heel toevallig komt aapje nummer \(9\) binnen wandelen (\(Y_9 = 180\)). Oeh, je hebt in dit geval een verkeerde voorspelling gemaakt. Hoe groot is de gok-fout of individuele afwijking voor case \(9\)?

\(\:\:\:\:\:\:Y_i - \overline{Y}\:\:\:\:\:\:\:\:\:\:\:\:\:\:\) Individuele afwijking (naar het grote gemiddelde) voor casenummer \(i\)

\(\:\:\:\:\:\:Y_9 – \overline{Y} = 180 – 150 = 30\:\:\:\:\:\:\:\:\:\:\:\:\:\:\) Individuele afwijking voor case 9.

Vraag 2 – Alle aapjes staan weer op de gang en ik vraag je nog een keer te gokken, maar nu krijg je extra informatie: Ik vertel je dat het aapje dat binnenkomt, een leeftijd heeft van twee jaar (\(X = 2\)). Ik heb je dus (diagnostische) informatie gegeven over een tweede variabele (leeftijd) waarvan we eerder al hadden gezien dat deze een positieve samenhang vertoont met lengte (\(r_xy= .89\)), wat betekent dat jongere aapjes over het algemeen wat kleiner zijn dan oudere aapjes. Sterker nog, we hebben zelfs een regressie-vergelijking gebouwd, die ons helpt bij het – beter – voorspellen:

\[\hat{Y}_i = 90 + 40 \cdot X_{i}\:\:\:\]

Omdat je dus de waarde qua leeftijd van mij hebt gekregen, kan je die (diagnostische) informatie (\(X = 2\)) gebruiken en invullen als \(X\)-waarde in de regressie-vergelijking;

\(\:\:\:\:\:\:\hat{Y}_{x=2} = 90 + 40 \cdot 2.0 = 170\)

Nu je weet wat de voorspelde waarde is voor alle aapjes, die precies \(2\) jaar oud zijn, roep je dus nu als antwoord (weer heel hard): ‘\(170\) cm, want het aapje is een half jaar ouder dan gemiddeld en zal dus ook wel wat langer zijn. Sterker nog, ik voorspel dat hij \(20\) cm boven het grote gemiddelde zit.’

Ik heel blij, want je hebt het antwoord alweer goed! Doordat je nu gebruik hebt gemaakt van het nieuwe model (dat rekening houdt met leeftijd, middels onze regressie-vergelijking), heb je je meest basale voorspelling (150) met \(20\) cm bijgesteld. Door of vanwege regressie zeggen we nu \(170\) in plaats van \(150\) en dat is \(20\) punten meer. En besef dus dat je deze verschuiving in voorspelling (\(20\) cm) altijd (systematisch) zou doen als een aapje een half jaar ouder is dan het gemiddelde (\(\overline{X} = 1.50\)).

Even later… Heel toevallig komt aapje nummer \(9\) weer binnen wandelen (hij is immers één van de twee-jarigen). Laten we snel kijken hoeveel jouw laatste voorspelling (gebaseerd op de leeftijd) nu nog afwijkt van de werkelijkheid. Of beter, hoe de werkelijkheid afwijkt van jou nieuwe verwachting (dus gebaseerd op ons regressiemodel). Aapje nummer \(9\) heeft een geobserveerde waarde van \(Y_9 = 180\) terwijl jouw voorspelling, \(\hat{Y}_{9} = \hat{Y}_{x=2} = 170\) was. Nu ligt de geobserveerde waarde nog maar \(10\) cm boven onze nieuwe (en hopelijk betere) verwachting!

Conclusie:

Ten opzichte van het nul-model, wijkt aapje nummer \(9\), dus \(30\) cm af, omdat:

\(\:\:\:\:\:\:Y_9 – \overline{Y} = 180 – 150 = 30\)

Door het regressie-model hebben we de voorspelling met \(20\) cm aangepast, omdat de nieuwe voorspelling, \(170\) is:

\(\:\:\:\:\:\:\hat{Y}_{9} – \overline{Y} = 170 – 150 = 20\)

Omdat we het regressie-model hebben gebruikt, maken we nu een kleinere gok-fout van nog maar \(10\) cm:

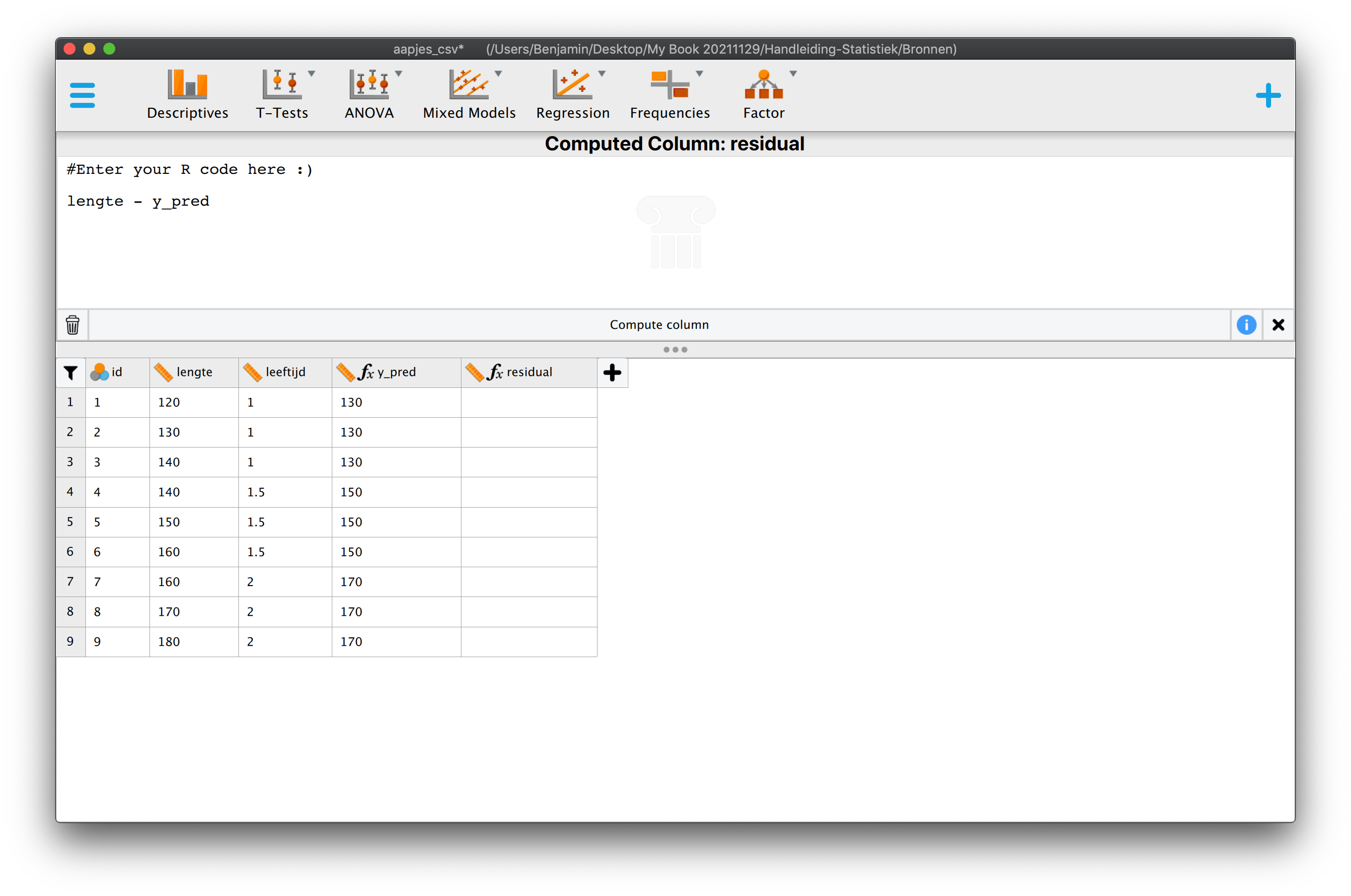

\(\:\:\:\:\:\:Y_i – \hat{Y}_{i}\)

\(\:\:\:\:\:\:Y_9 – \hat{Y}_{9} = 180 – 170 = 10\)

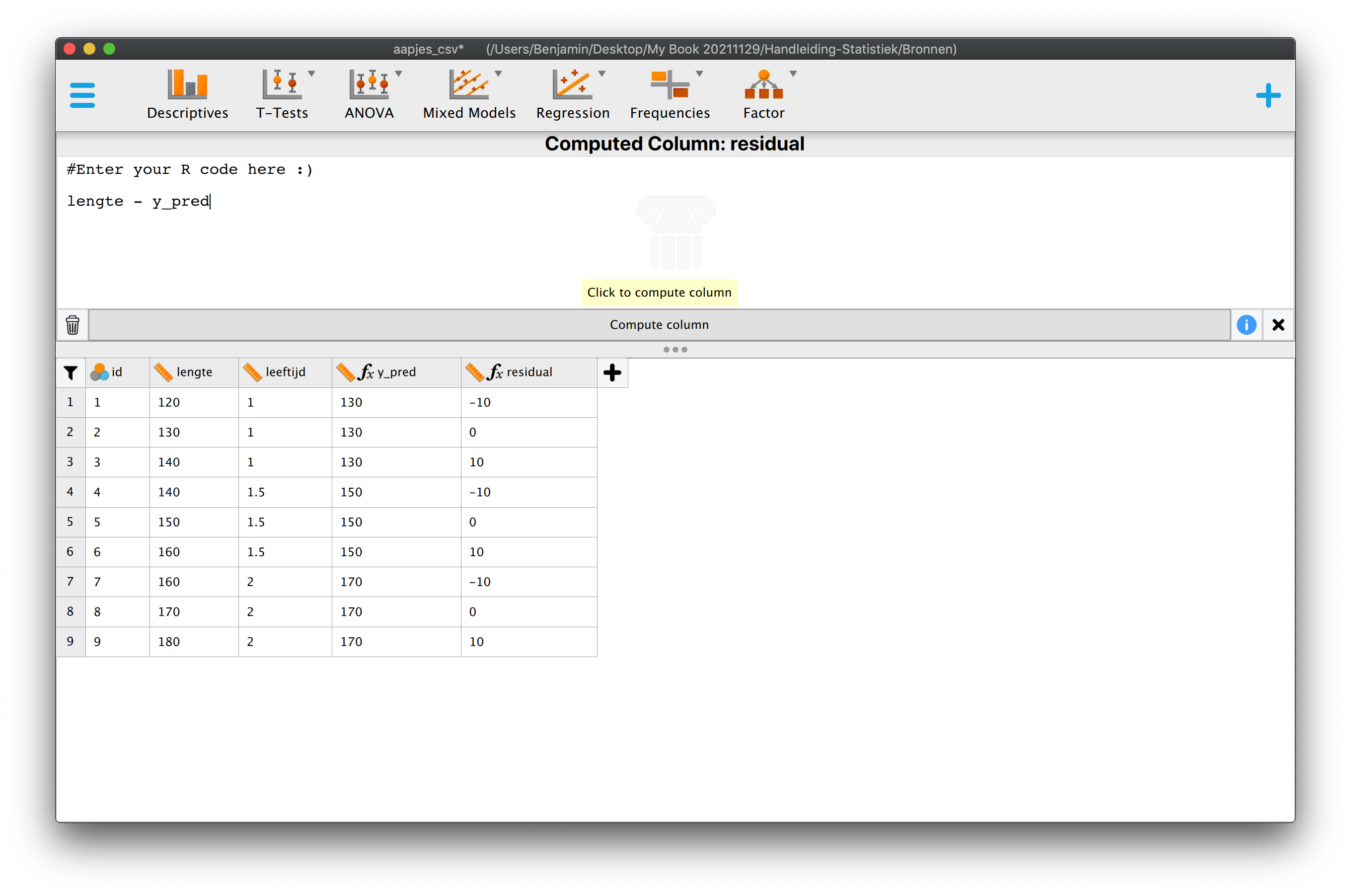

Conclusie nog een keer, maar dan in andere woorden en figuur 5.2: We hebben de totale afwijking van aapje nummer \(i = 9\) (\(30\) cm, de lengte van het blauwe verticale lijntje geeft de afwijking tussen de geobserveerde waarde en het grote gemiddelde) gesplit (of opgedeeld) in twee stukjes. Het eerste stukje (\(20\) cm, groen) is het gedeelte van de totale afwijking dat door ons regressie-model verklaard is. Het tweede stukje is het gedeelte dat we niet konden verklaren, het laatste restje dus (Jeetje… waar zou het woord ‘rest’ vandaan komen, ‘residu’ misschien?, ik teken residuen altijd rood). We hebben nu alleen naar deze opdeling gekeken voor aapje nummer \(9\). Het moge inmiddels duidelijk zijn dat voor dit aapje het regressie-model een betere voorspelling gaf dan het nul-model. Ik laat dit verschil, qua betere voorspelling met het regressiemodel in vergelijking tot het nul-model, in het algemeen en specifiek voor aapje nummer \(9\), even statistisch, technisch of wiskundig zien:

Heel algemeen:

\(\:\:\:\:\:\:DATA = FIT + RESIDU\)

Je komt deze uitspraak in vele vormen tegen, bijvoorbeeld:

\(\:\:\:\:\:\:DATA = Model + Residual\:\:\:\) of;

\(\:\:\:\:\:\:Observed = Expected + Error\:\:\:\) of;

\(\:\:\:\:\:\:\text{Werkelijkheid} = \text{Theorie} + \text{Wat niet klopt}\:\:\:\) en soms;

\(\:\:\:\:\:\:\text{Skinny Jeans} = \text{Vorm van benen enzo} + \text{niks}\)

Maar we bedoelen dus echt hetzelfde, wordt zo duidelijk… Aan de hand van het nul-model (\(M_0\)) en voor aapje nummer \(9\):

\(\:\:\:\:\:\:Data = M_0 + Error\)

\(\:\:\:\:\:\:Data = \overline{Y} + Error\:\:\:\:\:\) Dus in het geval van aapje voor \(i = 9\);

Aapje nummer \(9\) heeft een lengte van \(180\), terwijl het nul-model \(150\) voorspelde, waar hij dus nog \(30\) cm naast zat én is dus de gokfout (of error) die je maakt in het geval van het nul-model;

\(\:\:\:\:\:\:Y_i = \overline{Y} + e_i\)

\(\:\:\:\:\:\:Y_9 = \overline{Y} + e_9\)

\(\:\:\:\:\:\:180 = 150 + 30\)

Zijn score (\(Y_9 = 180\)) is dus opgebouwd uit twee termen, het grote gemiddelde en de error (gokfout, of ook wel ‘blauw streepje’ de gewone afwijking van een observatie naar het grote gemiddelde) die je in zijn geval maakt.

Als je dus nog niet weet over welk aapje uit je steekproef je het hebt, dan hou je het lekker algemeen (dus voor je steekproef):

\(\:\:\:\:\:\:Y_i = \overline{Y} + e_i\)

Maar als je over de populatie spreekt moet het natuurlijk aan de hand van parameters:

\(\:\:\:\:\:\:Y_i = \mu_y + \epsilon_i\)

Nu aan de hand van het regressie-model (\(M_1\)) en voor aapje nummer \(9\):

\(\:\:\:\:\:\:Data = M_1 + Error\)

\(\:\:\:\:\:\:180 = 170 + 10\)

Op basis van het regressie-model (\(M_1\)), zou je zeggen dat aapje nummer \(9\), die twee jaar is, dat hij \(170\) cm zou moeten zijn, en dan hou je nog maar een error over van \(10\) cm;

\(\:\:\:\:\:\:Y_9 = \hat{Y}_{9} + e_9\)

Zijn score (\(Y_9 = 180\)) is dus opgebouwd uit twee termen, de voorspelde waarde (\(\hat{Y}_{9} = 170\)) door of vanwege \(M_1\) en de error (\(e_9 = 10\)) die je in zijn geval maakt. Waar kwam \(Y\)-dakje (\(\hat{Y}_{9}\)) ook al weer vandaan? Die hadden we met de regressievergelijking berekend;

\(\:\:\:\:\:\:Y_9 = (90 + 40 \cdot X_9) + e_9\)

of zonder haakjes:

\(\:\:\:\:\:\:Y_9 = 90 + 40 \cdot X_9 + e_9\)

Als je dus nog niet weet over welk aapje je praat, hou je het lekker algemeen:

\(\:\:\:\:\:\:Y_i = \hat{Y}_{i} + e_i\)

of:

\(\:\:\:\:\:\:Y_i = (90 + 40 \cdot X_i) + e_i\)

Aangezien de haakjes hier dus voor ‘Jan Doedel’ staan:

\(\:\:\:\:\:\:Y_i = 90 + 40 \cdot X_i + e_i\)

Als je zelfs nog niet weet wat de waarden van het intercept (\(b_0\)) en de slope (\(b_1\)) zijn in je steekproef:

\(\:\:\:\:\:\:Y_i = b_0 + b_1 \cdot X_i + e_i\)

En natuurlijk willen zouden we uiteindelijk willen weten hoe het zit met het intercept en de slope voor de hele populatie aapjes, dus aan de hand van parameters:

\[\:\:\:\:\:\:Y_i = \beta_0 + \beta_1 \cdot X_i + \epsilon_i\]

Dit noem je het algemene regressie-model voor de populatie, waarmee we dus precies laten zien, met welke symbolen (parameters), hoe wij een geobserveerde score opdelen in een stuk verklaard door het model en een stuk onverklaard wat we vaak error (of ruis) noemen.

5.4.3 Opdeling van Totale Variatie in Model Variatie en Error Variatie

Hoe zou de opdeling qua voorspelling (fit) en error (residu) bij de andere aapjes zitten? Dus welke gedeeltes van alle afwijkingen tezamen (totale variatie) worden verklaard door het model en welk gedeelte is ruis? Wat ik net voor aapje nummer \(9\) heb gedaan doen we nu voor elk aapje, maar dan aan de hand van de de formules. We gaan het bekijken aan de hand van een tabel met ‘kwadratensommen’. Er zijn maar drie soorten kwadratensommen (Voor Totaal, Model en Error natuurlijk). Om zo’n tabel als hieronder aan te maken, zul je dus het spelletje moeten spelen voor ieder aapje uit onze steekproef (of heel goed je formules moeten kennen). Ik loop de berekeningen natuurlijk met jullie door.

| \(i\) | \(Y_i\) | \(X_i\) | \(\hat{Y}_i\) | \(Y_i - \overline{Y}\) | \((Y_i - \overline{Y})^2\) | \(\hat{Y}_i - \overline{Y}\) | \((\hat{Y}_i - \overline{Y})^2\) | \(Y_i - \hat{Y} = e_i\) | \((Y_i - \hat{Y})^2 = e_i^2\) |

|---|---|---|---|---|---|---|---|---|---|

| 1 | 120 | 1 | 130 | -30 | 900 | -20 | 400 | -10 | 100 |

| 2 | 130 | 1 | 130 | -20 | 400 | -20 | 400 | 0 | 0 |

| 3 | 140 | 1 | 130 | -10 | 100 | -20 | 400 | 10 | 100 |

| 4 | 140 | 1.5 | 150 | -10 | 100 | 0 | 0 | -10 | 100 |

| 5 | 150 | 1.5 | 150 | 0 | 0 | 0 | 0 | 0 | 0 |

| 6 | 160 | 1.5 | 150 | 10 | 100 | 0 | 0 | 10 | 100 |

| 7 | 160 | 2 | 170 | 10 | 100 | 20 | 400 | -10 | 100 |

| 8 | 170 | 2 | 170 | 20 | 400 | 20 | 400 | 0 | 0 |

| 9 | 180 | 2 | 170 | 30 | 900 | 20 | 400 | 10 | 100 |

| \(\sum\limits^{i=9}_{i=1}{(Y_i-\overline{Y})^2} = 3000\) | \(\sum\limits^{i=9}_{i=1}{(\hat{Y}_i-\overline{Y})^2} = 2400\) | \(\sum\limits^{i=9}_{i=1}{(Y_i-\hat{Y}_i)^2} = 600\) |

Mijn gedachte nu:

Oh wat een frustratie, natuurlijk ook voor jou, maar vooral voor mij, want ik wil zo graag naar de essentie en we zijn er bijna. Maar uit ervaring weet ik dat het zo moeilijk is om je aandacht bij suffe dingen te houden. Natuurlijk ben ik inmiddels dus bang dat ik je kwijt ben, juist omdat we in een snelle wereld leven waar aandacht alleen breed is… Hou vol, nog eventjes, want de kern komt écht bijna! Ik weet, we leven immers in een wereld waar je bijna niet meer hoeft na te denken, want alles wordt voor je gedaan. Laten we wel wezen, weet jij nog hoe kaas gemaakt wordt of hoe je een band moet plakken? Of weet jij écht hoe jouw computer werkt? Meestal niet van belang, omdat het gewoon werkt of voor jou wordt gedaan, dus waarom zou je nadenken en moeite doen? Waarom ben je iets wetenschappelijks gaan studeren?

Inzicht Kicks Ass!

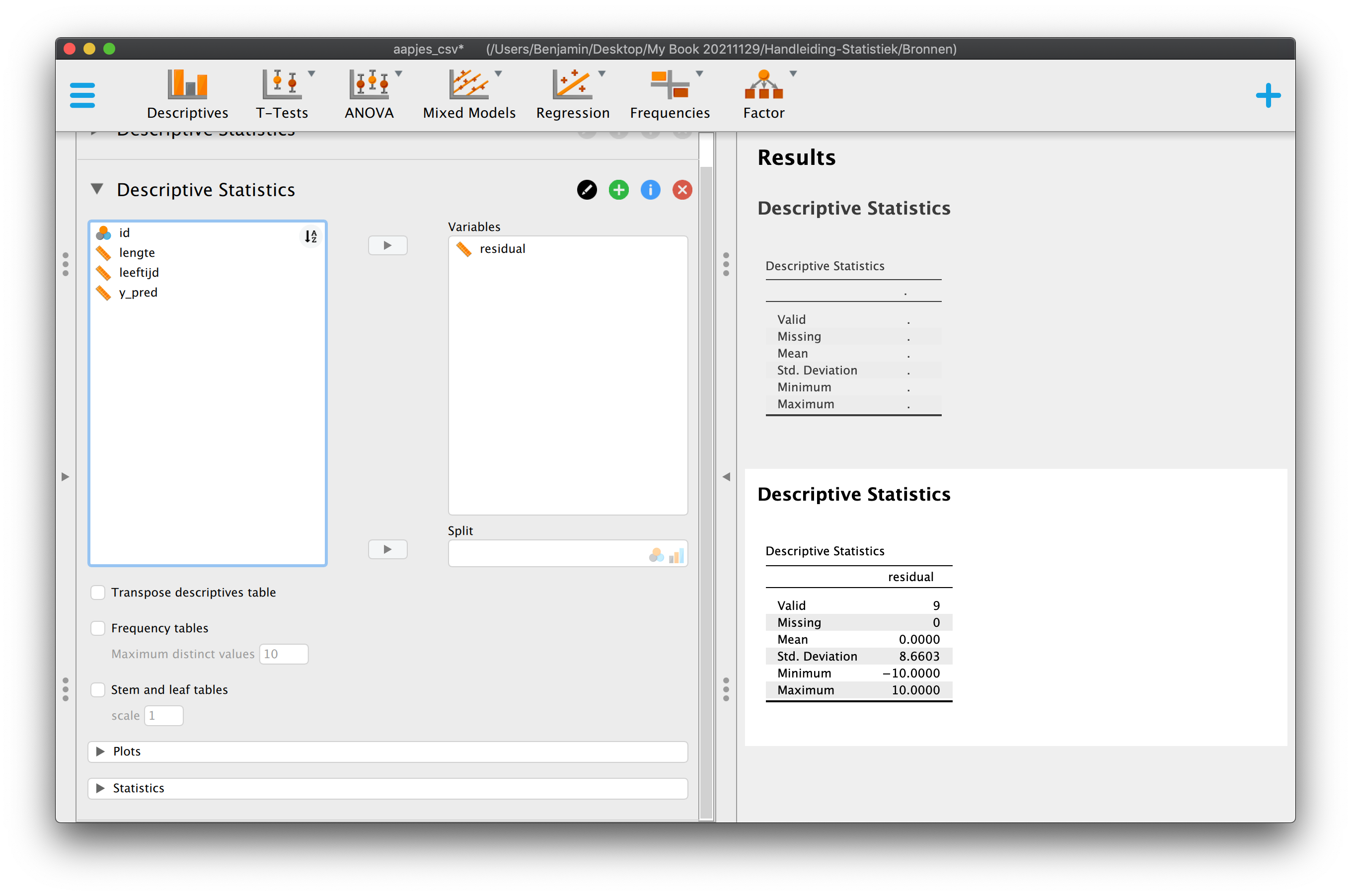

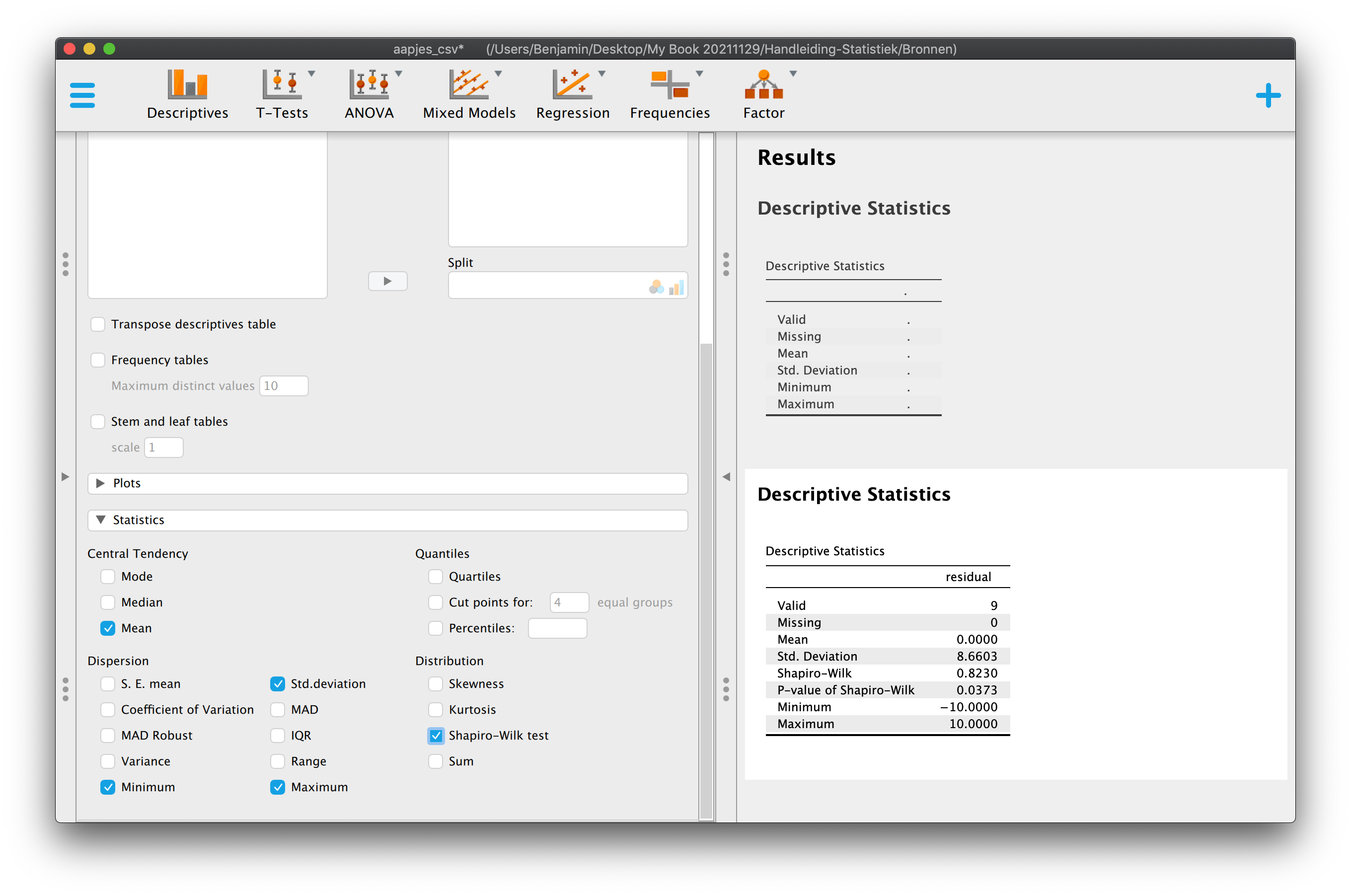

Anyway, tabel 5.2 is de keiharde werkelijkheid, waar we eerst doorheen moeten. In de tabel heb ik, naast de bekende data, een aantal extra kolommen aangemaakt. Een aantal kolommen zou je al moeten herkennen. Kolom 5 en 6 (‘Total’ en ‘Squared Total’) geven respectievelijk de individuele afwijkingen ten opzichte van het grote gemiddelde (blauwe streepjes) en de gekwadrateerde afwijkingen (blauwe vierkantjes), die we ook nodig hadden om de variantie (\(S_y^2\)) en de standaardafwijking (\(S_y\)) voor lengte uit te rekenen. De gekwadrateerde afwijkingen (tot het grote gemiddelde) tellen samen op tot \(3000\). In kolom \(4\) vind je de voorspellingen (predicted values voor lengte, ‘\(Y\)-dakje’ dus) op basis van onze regressievergelijking (\(\hat{Y}_i = 90 + 40 \cdot X_{i}\)). Dus op basis van de leeftijd van die aapjes, die je invult in de regressie-vergelijking om hun voorspelde waarde (\(\hat{Y}_i\)) uit te rekenen. In kolom \(7\) vind je de ‘systematische verschuiving in voorspelling door het regressie-model’ (t.o.v. het nul-model, ik noem dat de groene streepjes, zie ook figuur), de optelling is natuurlijk 0. Daarom kolom \(8\), maar daar vind je de gekwadrateerde ‘nodel verschuivingen’, die tellen samen op tot \(2400\). In de ener laatste kolom vind je de error (\(e_i\)), wat de gok-foutjes zijn als je dus regressie gebruikt als voorspelling, die tellen (natuurlijk) ook op tot nul. Daarom de aller laatste kolom met gekwadrateerde errors, die samen optellen tot \(600\).

5.4.3.1 Sum of Squares voor Total, Model en Error

5.4.3.1.1 Sum of Squares voor Total

Beetje flauwe vraag maar verschillen (of varieren) onze aapjes? Ja, want ze hebben niet allemaal dezelfde lengte. Maar hoeveel variatie is er dan? We hebben verschillende maten voor variatie. Zo zijn de variantie (\(S_y^2 = 375\) voor onze aapjes) of de standaardafwijking (\(S_Y = 19.365\)) natuurlijk veel gebruikte variatie- of spreidingsmaten. Kwadratensommen (optelling van vierkantjes) zijn ook heel handige en veel gebruikte maten voor spreiding. Er zijn drie soorten kwadratensommen (Sum of Squares of kortweg \(SS\)) voor de afhankelijke variabele, we beginnen met Sum of Squares Total (\(SST\)), deze wordt gebruikt als maat voor de Totale variatie van de afhankelijke variabele (dus voor \(Y\) en is dus de optelling van alle gekwadrateerde blauwe streepjes). We zijn ‘hem’ al tegengekomen in Hoofdstuk 0, omdat het een tussenantwoord is als je de varaiantie berekend, maar hij is dus zo belangrijk dat ie een eigen naam heeft gekregen (\(SST\), \(SSTotal\), soms zie je ook: \(SSY\) of \(SS\)lengte in geval van de variabele ‘lengte’)

\(\:\:\:\:\:\:SST = \sum\limits^{i=n}_{i=1}{(Y_i-\overline{Y})^2}\)

En als we het zouden invullen voor onze aapjes, wederom in stapjes:

\(\:\:\:\:\:\:SST = \sum\limits^{i=9}_{i=1}{(Y_i-\overline{Y})^2} = (Y_1-\overline{Y})^2 + (Y_2-\overline{Y})^2\;+\; \dots \; +\;(Y_8-\overline{Y})^2 + (Y_9-\overline{Y})^2\)

\(\:\:\:\:\:\:SST = \sum\limits^{i=9}_{i=1}{(Y_i-\overline{Y})^2} = (120-150)^2+(130-150)^2\;+\; \dots \;+\;(170-150)^2+(180-150)^2\)

\(\:\:\:\:\:\:SST = \sum\limits^{i=9}_{i=1}{(Y_i-\overline{Y})^2} = (\text{-}30)^2+(\text{-}20)^2\;+\; \dots \;+\;20^2+30^2\)

\(\:\:\:\:\:\:SST = \sum\limits^{i=9}_{i=1}{(Y_i-\overline{Y})^2} = 900+400\;+\; \dots \;+\;400+900 = 3000\)

De sommatie van de totale gekwadrateerde individuele afwijkingen naar het grote gemiddelde, dus Sum of Squares (due to) Total (\(SST\)) heeft een waarde van \(3000\). Denk maar even aan een gezellig tuintje vol van variatie (mooie bloemetjes en onkruid) met een oppervlakte van \(3000\) \(text{cm}^2\). Tuurlijk willen we straks weten welk gedeelte van de tuin bezaaid is met bloemen en welk deel met onkruid.

5.4.3.1.2 Sum of Squares voor Model

De sommatie van de gekwadrateerde ‘systematische verschuivingen’ door het regessie-model (groene streepjes), noemen we ook wel Sum of Squares (due to) Regression of kortweg \(SSReg\), \(SSM\) of \(SS\hat{Y}\):

\(\:\:\:\:\:\:SSM = \sum\limits^{i=n}_{i=1}{(\hat{Y}_i-\overline{Y})^2}\)

\(\:\:\:\:\:\:SSM = \sum\limits^{i=9}_{i=1}{(\hat{Y}_i-\overline{Y})^2} = (\hat{Y}_1-\overline{Y})^2 + (\hat{Y}_2-\overline{Y})^2\;+\; ...\; +\;(\hat{Y}_8-\overline{Y})^2 + (\hat{Y}_9-\overline{Y})^2\)

\(\:\:\:\:\:\:SSM = \sum\limits^{i=9}_{i=1}{(\hat{Y}_i-\overline{Y})^2} = (130-150)^2+(130-150)^2\;+\; \dots \;+\;(170-150)^2+(170-150)^2\)

\(\:\:\:\:\:\:SSM = \sum\limits^{i=9}_{i=1}{(\hat{Y}_i-\overline{Y})^2} = 20^2+ 20^2+20^2+0^2+0^2+0^2+20^2+20^2+20^2\)

\(\:\:\:\:\:\:SSM = \sum\limits^{i=9}_{i=1}{(\hat{Y}_i-\overline{Y})^2} = 400 + 400+ 400 +0+0+0+400+400+400 = 2400\)

We kunnen dus nu zeggen dat de waarde van de kwadratensom voor het model dus een waarde heeft van \(2400\) Denk dus maar eventjes dat dit de oppervlakte is (\(2400\) \(\text{cm}^2\)) die de netjes en systematisch geplante bloemetjes beslaan in de tuin van gezelligheid (met een totale oppervlakte van \(3000\) \(\text{cm}^2\)).

5.4.3.1.3 Sum of Squares voor Error

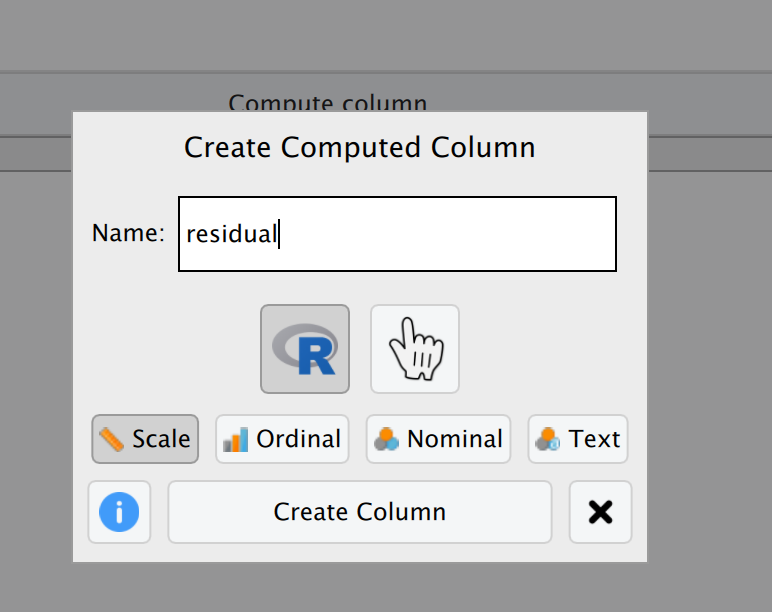

Het enige dat ons nog rest is de troep die we overhouden (de prut die in een filter bijft zitten, ook wel het ‘residu’). We kijken dus nu naar de onverklaarbare variatie (waarom zijn alle aapjes van \(2\) jaar oud, niet precies \(170\)?). Bij mij dus de rode streepjes (rood van de liefde, die wat mij betreft ook onverklaarbaar is). Dus ook hier weer, eerst alle rode streepjes (\(e_i\)) voor elke waarde van \(i\) kwadrateren en dan pas optellen:

\(\:\:\:\:\:\:SSE = \sum\limits^{i=n}_{i=1}{(Y_i-\hat{Y}_i)^2} = \sum\limits^{i=n}_{i=1}{e_i^2}\)

\(\:\:\:\:\:\:SSE = \sum\limits^{i=9}_{i=1}{(Y_i-\hat{Y}_i)^2} = (Y_1 -\hat{Y}_1)^2 + (Y_2 -\hat{Y}_2)^2\;+\; ...\; +\;(Y_8 -\hat{Y}_8)^2 + (Y_9 -\hat{Y}_9)^2\)

\(\:\:\:\:\:\:SSE = \sum\limits^{i=9}_{i=1}{(Y_i-\hat{Y}_i)^2} = (120 - 130)^2 + (130 -130)^2\;+\; \dots \; +\;(170 -170)^2 + (180 -170)^2\)

\(\:\:\:\:\:\:SSE = \sum\limits^{i=9}_{i=1}{(Y_i-\hat{Y}_i)^2} = \text{-}10)^2 + 0^2 + 10^2 + \text{-}10)^2 0^2 + (10)^2 + \text{-}10)^2 0^2 + (10)^2\)

\(\:\:\:\:\:\:SSE = \sum\limits^{i=9}_{i=1}{(Y_i-\hat{Y}_i)^2} = 100 + 0 + 100 + 100 + 0 + 100 + 100 + 0 + 100 = 600\)

De sommatie van de gekwadrateerde afwijkingen van een observatie naar de (eigen) voorspelling door het regressie-model, of de gekwadrateerde errors, noemen we ook wel Sum of Squares (due to) Error, of kortweg \(SSE\), \(SSRes\), \(SSResidual\).

Nu hebben we dus drie soorten sommaties van kwadraten uitgerekend. \(SST\), \(SSM\) en \(SSE\). Laten we die stelling van daarnet er nog eens bijpakken:

\(\:\:\:\:\:\:DATA = FIT + RESIDU\)

Kan die al omvattende stelling niet toevallig ook worden uitgedrukt in termen van de drie verschillende vormen van de sum of squares? Ja!

\(\:\:\:\:\:\:SSTotal = SSModel + SSError\)

Of nog schoner (zonder woorden):

\(\:\:\:\:\:\:\sum\limits^{i=n}_{i=1}{(Y_i-\overline{Y})^2}= \sum\limits^{i=9}_{i=1}{(\hat{Y}_i-\overline{Y})^2}+ \sum\limits^{i=n}_{i=1}{(Y_i-\hat{Y}_i)^2}\)

Wel zo fijn voor het marsmannetje. Maar in het bijzondere geval van onze aapjes bedoelen we natuurlijk gewoon:

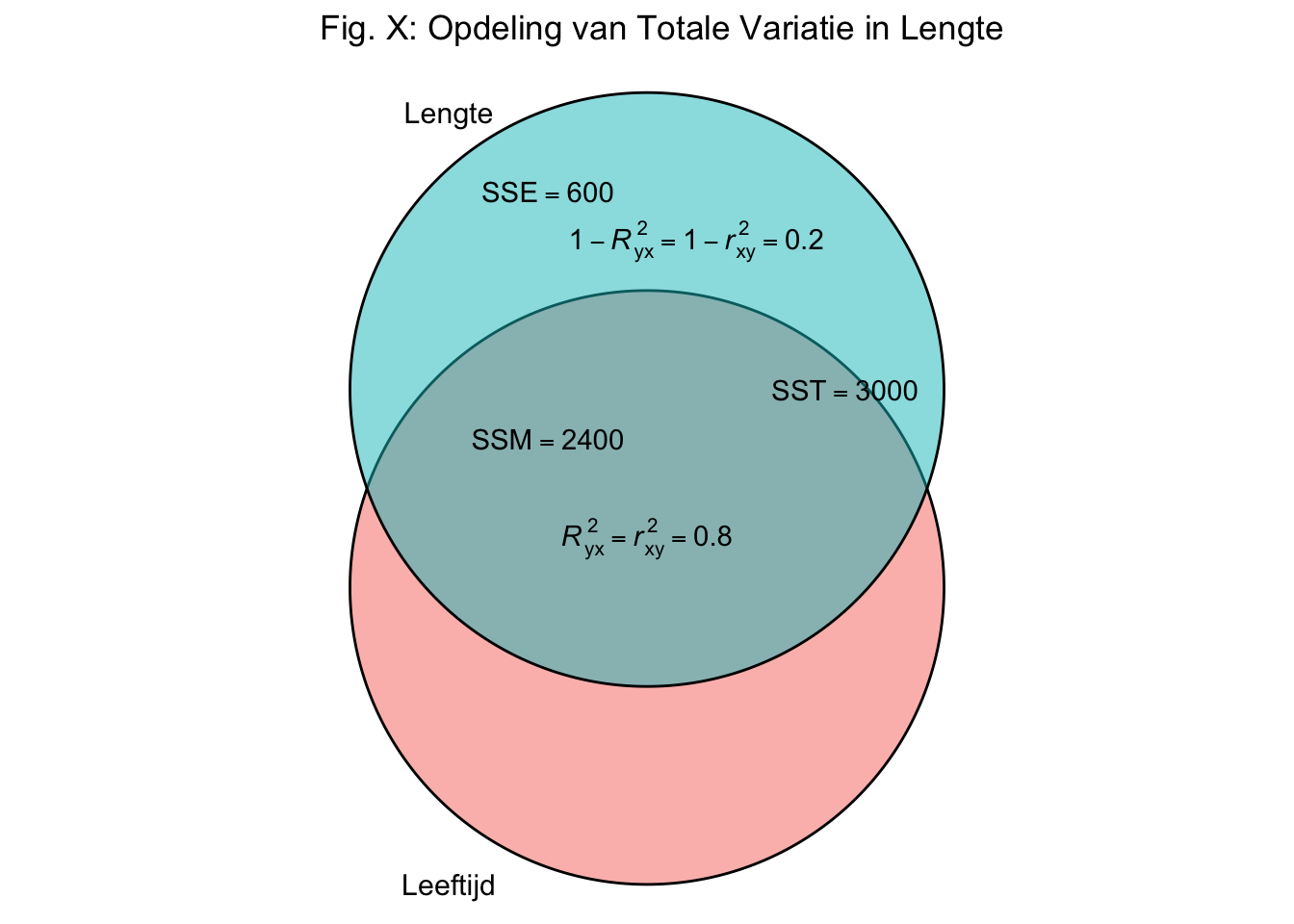

\(\:\:\:\:\:\:3000 = 2400 + 600\)

Wat je nu ziet is een opdeling van de totale variatie voor lengte (\(SST\)), in een gedeelte verklaard (\(SSM\)) en een gedeelte onverklaard (\(SSE\)). \(SST\) is ook een maat voor (totale) variatie, net zoals de variantie en de standaard afwijking. Het is alleen niet de gemiddelde oppervlakte van een vierkantje (zoals de variantie dat wel is), maar puur de optelling van al die blauwe vierkantjes, dus hun totale oppervlakte, Bij ons dus een oppervlakte van \(3000\) \(\text{cm}^2\). Denk dus maar aan een tuintje vol van (totale) variatie (verschillende netjes geplante bloemen en onkruid) met een oppervlakte van \(3000\) vierkante centimeter. In dat tuintje is een gedeelte strak georganiseerd (rijtjes met prachtige bloementjes, \(SSM\)) en een gedeelte is wildgroei (random onkruid, \(SSE\)). Welk gedeelte van dit tuintje (totale variatie) is strak georganiseerd? Aangezien het strakke gedeelte bij elkaar een oppervlakte heeft van \(2400\) cm2, beslaat dat dus vier-vijfde deel van het hele tuintje, want met de breuk:

\(\:\:\:\:\:\: \frac{SSM}{SST} = \frac{2400}{3000} = \frac{4}{5} = .8\)

bereken je het gedeelte systematische variatie ten opzichte van de totale variatie, bij ons dus: Proportioneel gezien, neemt het systematische of het verklaarde gedeelte dus een proportie van \(.80\) (of \(80\) procent) in beslag.

Ik kwam op een eiland waar ik een werkelijkheid tegen kwam, die mijn pet, in eerste instantie te boven ging. Ik zag een boel aan (totale) variatie qua lengtes, bij die schattige aapjes op dat eiland. In eerste instantie kon ik die variatie niet thuis brengen en moest ik accepteren dat de gemiddelde gok-fout niet lager kon dan \(19.365\) cm. Eigenlijk onacceptabel. Het vermoeden rees, dat die variatie, echt niet zomaar, of puur random was. Sterker nog, ik kreeg zelfs het idee, dat deze variatie in lengte wel eens kon samenhangen met variatie in een andere variabele, namelijk leeftijd. Ook voor leeftijd was er namelijk spreiding en het bleek dat jonge aapjes over het algemeen wat kleiner zijn dan oudere aapjes (\(r_{xy} = .89\)). Vanwege deze samenhang, heb ik besloten om hun lengtes aan de hand van een regressie-vergelijking te voorspellen (\(\hat{Y}_i = 90 + 40 \cdot X_i\)). Dit lukte zo goed, dat ik zelfs in staat was om maar liefst \(80\) procent van de totale variatie in lengte te verklaren, enkel en alleen op basis van de variatie in leeftijd!

5.4.4 Grand Final

(Proportion of) Variance Accounted For (VAF), proportie verklaarde variantie

We hebben nu de belangrijkste maat binnen de statistiek (wetenschap) gevonden. Wanneer je een model bouwt, dus een idee over de werkelijkheid hebt en dat toepast om te voorspellen, zijn we vooral geïnteresseerd in de mate waarin dat model overeenkomt met die werkelijkheid, de geobserveerde wereld. De maat die we hebben gevonden, noemen we de proportie verklaarde variantie of ook wel de (Proportion of) Variance Accounted For (VAF). Het lullige (hehe) is dat je deze waarde ook vindt, door – simpelweg – de correlatie (\(r_{xy}\)) te kwadrateren. Maar waar het mij om ging is dat je nu gezien hebt, hoe we naar de wereld kijken en hoe we verklaarde en onverklaarde zaken van elkaar scheiden en daar maten aan toe kennen. Resumé, met de juiste symbolen:

\(\:\:\:\:\:\: VAF = R_{yx}^2 = \frac{SSM}{SST}\)

‘R-kwadraat’ noemen we dus ook wel de proportie verklaarde variantie (de \(VAF\)). Ik gebruik hier een hoofdletter omdat ik het over ‘een model’ heb. Maar dit is hetzelfde als:

\(\:\:\:\:\:\: VAF = R_{yx}^2 = r_{yx}^2 = r_{xy}^2 = \frac{SSM}{SST}\)

\(\:\:\:\:\:\: VAF = R_{yx}^2 = \frac{2400}{3000} = .80\)

Dus \(80\) procent van de totale variatie in lengte scores (in onze steekproef) kan verklaard worden op basis van (variatie in) leeftijd, we houden dus \(20\) procent _on_verklaarde variatie over:

\(\:\:\:\:\:\:1 – R_{yx}^2 = 1 – \frac{SSM}{SST} = \frac{SSE}{SST}\)

Dit is de proportie _on_verklaarde variantie, het gedeelte van de totale variatie in lengte scores, dat we niet konden verklaren, voor onze aapjes:

\(\:\:\:\:\:\:1 – .80 = .20\)

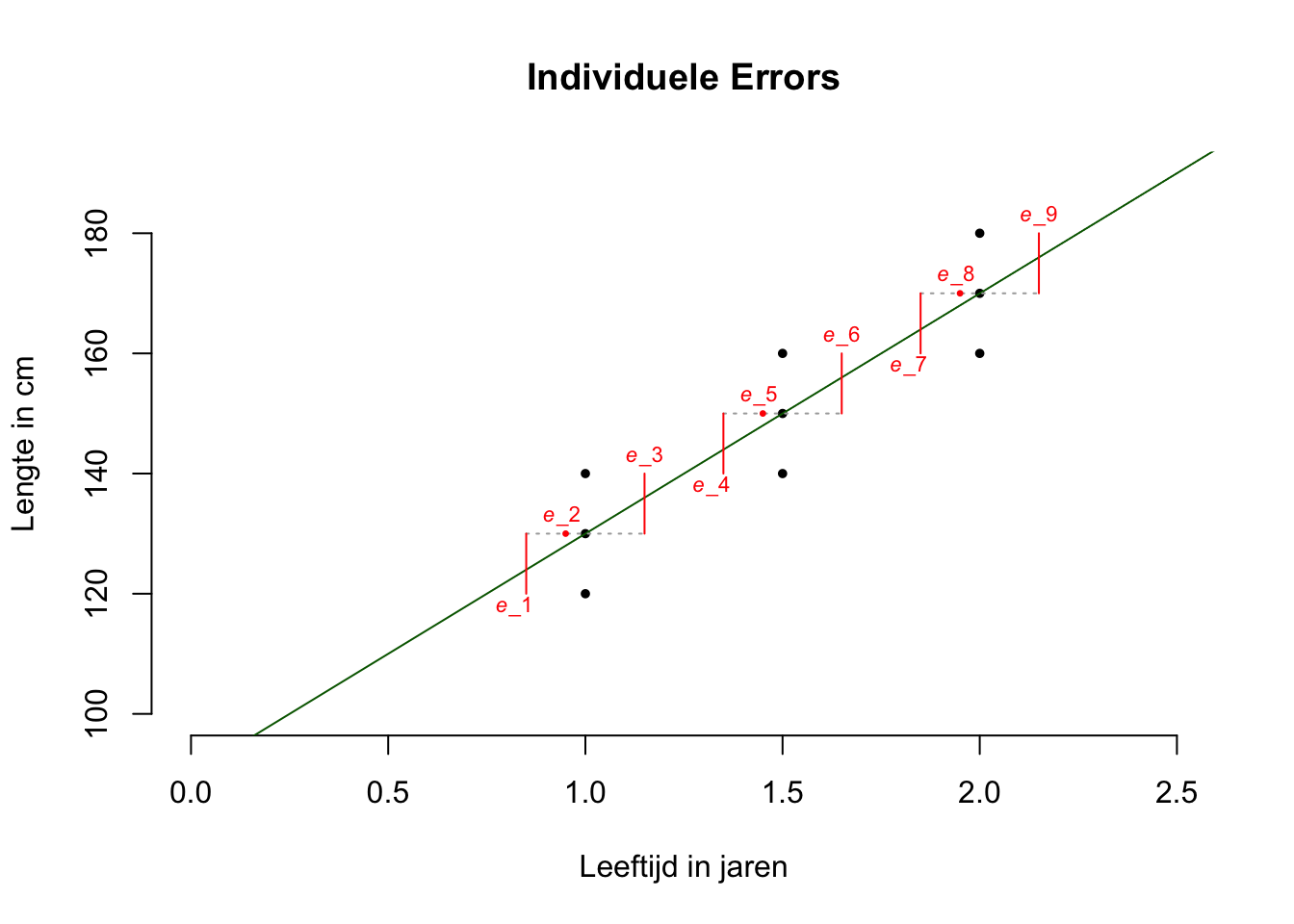

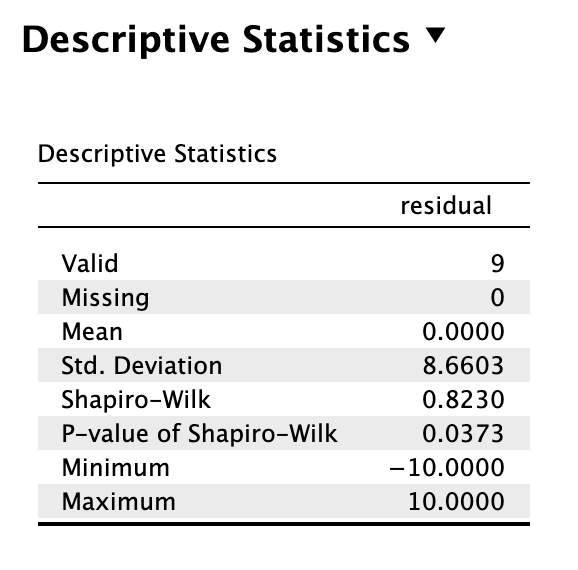

5.4.4.1 Standaardafwijking van de error

Op basis van het nul-model hebben we voor lengte, te maken met een gemiddelde gok-fout van \(19.365\) cm, de standaardafwijking (\(S_y\)). Maar hoe zit het met de gemiddelde gok-fout die we overhouden als we het regressie-model gebruiken? \(SSE\) is een maat voor de hoeveelheid error en we hebben de individuele errors gebruikt om \(SSE\) te berekenen (gewadrateerd en daarna opgeteld). Een individuele error (\(e_i\)) is ook wel de verticale afstand van een observatie naar de regressie-lijn, ik teken ze altijd rood. Dit zijn dus de gokfoutjes die je overhoudt als je de regressie-lijn gebruikt om een voorspelling te doen.

Figuur 5.7: -

De regressie-lijn hebben we zodanig getrokken dat al die individuele errors (\(e_i\), error-termen), gemiddeld gezien, zo klein mogelijk zijn. Dat was ook het doel, een model bouwen, zodanig dat we beter kunnen voorspellen. Wat is de gemiddelde waarde van al die negen error-termen, dus de gemiddelde lengte van een rood streepje? Ik vraag hier dus naar de standaardafwijking voor de errors. Natuurlijk gaat (berekenen we) dat via de variantie voor de error (\(S_e^2\)):

\(\:\:\:\:\:\:S_e^2 = \frac{SSE}{n-p-1}\) of:

\(\:\:\:\:\:\:S_e^2 = \frac{\sum\limits^{i=n}_{i=1}{(Y_i-\hat{Y}_i)^2}}{n-p-1}\)

De formule voor variantie van de error. Hierbij staat ‘\(p\)’ voor het aantal predictoren in onze regressievergelijking. Wij hebben maar 1 predictor (onafhankelijke variabele), namelijk leeftijd. Als je een meervoudige regressieanalyse zou doen, dan heb je dus ook meer predictoren en dan wordt de waarde van \(p\) dus pas groter. Bij ons kunnen we dus zeggen: \(p=1\). Onder de breukstreep, dus in de noemer, zie je het aantal vrijheidsgraden voor de Error staan (\(dfE = n - p -1\)). We kunnen de formule dus ook anders opschrijven:

\(\:\:\:\:\:\:S_e^2 = \frac{SSE}{dfE}\)

Heel vervelend, maar de variantie voor de error (\(S_e^2\)) noemen we ook ‘Mean Square Error (MSE)’, Een variantie is immers de gemiddelde oppervlakte van alle (voor nu rode) vierkantjes dus:

\(\:\:\:\:\:\:MSE = S_e^2 = \frac{SSE}{dfE}\)

Hoe zit het bij ons aapjes? Invullen geeft:

\(\:\:\:\:\:\:MSE = S_e^2 = \frac{600}{9-1-1} = \frac{600}{7} = 85.71429\)

Dus de error variantie heeft een waarde van \(S_e^2 = 85.71\). Wij willen natuurlijk de standaardafwijking voor de error:

\(\:\:\:\:\:\:S_e = \sqrt{S_e^2} = \sqrt{85.71429} = 9.258201\)

De standaardafwijking van de error (\(S_e\)) heeft dus afgerond een waarde van \(9.26\) (cm). Nu weten we dus eindelijk hoe goed (of hoe slecht) we kunnen voorspellen aan de hand van het regressiemodel in termen van de gemiddelde gokfout. We hebben dus nu nog maar te maken met een gemiddelde gokfout van \(9.26\). Dit is dus ook meteen de gemiddelde afstand van een observatie naar de regressie lijn, de gemiddelde error waarde. We hebben dus de gemiddelde gokfout van \(19.365\) teruggebracht naar een waarde van \(9.26\), ruim \(10\) punten kleiner dus. En dit allemaal aan de hand van een predictor, de variabele leeftijd. Dus twintig procent van de variatie in lengtes kan niet verklaard worden. Misschien als we een nog complexer model bouwen dat we dan nog minder error (\(SSE\)) overhouden. Misschien zou een verklarend model op basis van leeftijd én vitamientjes wel meer dan tachtig procent kunnen verklaren! Multipele Regressie-Analyse is het onderwerp van het volgende hoofdstuk. Maar eerst nog de generalisatie van ons (gevonden) enkelvoudig regressie-model naar de populatie. We mogen dan een leuk effect hebben ontdekt, maar zijn onze resultaten ook significant?

5.5 Betrouwbaarheidsintervallen en Significantietoetsen voor Regressie-Parameters.

We hebben nu het belangrijkste begrip, de proportie verklaarde variantie (\(VAF\)) van een model behandteld. Bij ons geeft de \(VAF\) dus aan welk deel van de totale variatie in lengtescores, verklaard kan worden op basis van variatie in leeftijd-scores. Aan de hand van leeftijd, kunnen we 80 procent van de variatie in lengte verklaren. Deze waarde geldt in ieder geval voor onze steekproef, maar we gaan nu na in hoeverre we onze regressie-vergelijking, dus ons model, kunnen generaliseren naar de populatie. In hoofdstuk 4 hebben we gekeken naar de generalisatie van steekproef-gegevens (statistieken) naar populatie-gegevens (parameters) aan de hand van betrouwbaarheidsintervallen en significantie-toetsen. Gaan we nu weer doen, maar dan dus voor onze regressie-vergelijking. Alhoewel een enkelvoudige regressie-vergelijking twee parameters heeft (het intercept en de slope) is het alleen de slope die iets zegt over het verband tussen \(X\) en \(Y\). Het intercept vertelt je alleen wat de waarde van de hoogte van het snijpunt met de \(y\)-as is, en zegt dus niets over de helling van de lijn. De nadruk ligt dus altijd op de slopes bij regressie.

5.5.1 Betrouwbaarheidsinterval (BI) voor de populatie-slope \(\beta_1\)

Om een betrouwbaarheidsinterval voor een regressiegewicht (\(\beta_i\)) te bouwen (berekenen), heb je nooit een \(H_0\) verwachting nodig. Voor een betrouwbaarheidsinterval in het algemeen heb je nooit een \(H_0\) nodig. Inmiddels komt dit bekend voor hoop ik. Verder is het ‘gevoel’ gewoon hetzelfde, alleen in hoofdstuk \(4\) keken we naar gebeurtenissen zoals het steekproefgemiddelde, nu kijken we naar de steekproefuitkomst de slope! Eerst even onze gevevens over onze enige echte op een rijtje en dan kunnen we knallen en de meest basale ondezoeksvraag (“Wat is de waarde van een ding?”) voor de slope beantwoorden:

Wat is met 95 procent zekerheid de waarde van de populatieslope?

- Onze Steekproefgegevens:

- \(n=9\), \(\overline{Y} = 150\), \(S_y^2 = 375\),

- \(\overline{X} = 1.50\), \(S_x^2 = 0.1875\),

- \(r_{xy} = .8944\),

- \(\hat{Y}_i = 90 + 40 \cdot X_{i}\), (\(b_0 = 90\), \(b_1 = 40\)),

- \(R_{yx}^2 = .80\)

- \(SST = 3000\), \(SSM = 2400\), \(SSE = 600\),

- \(S_e = 9.2582\)

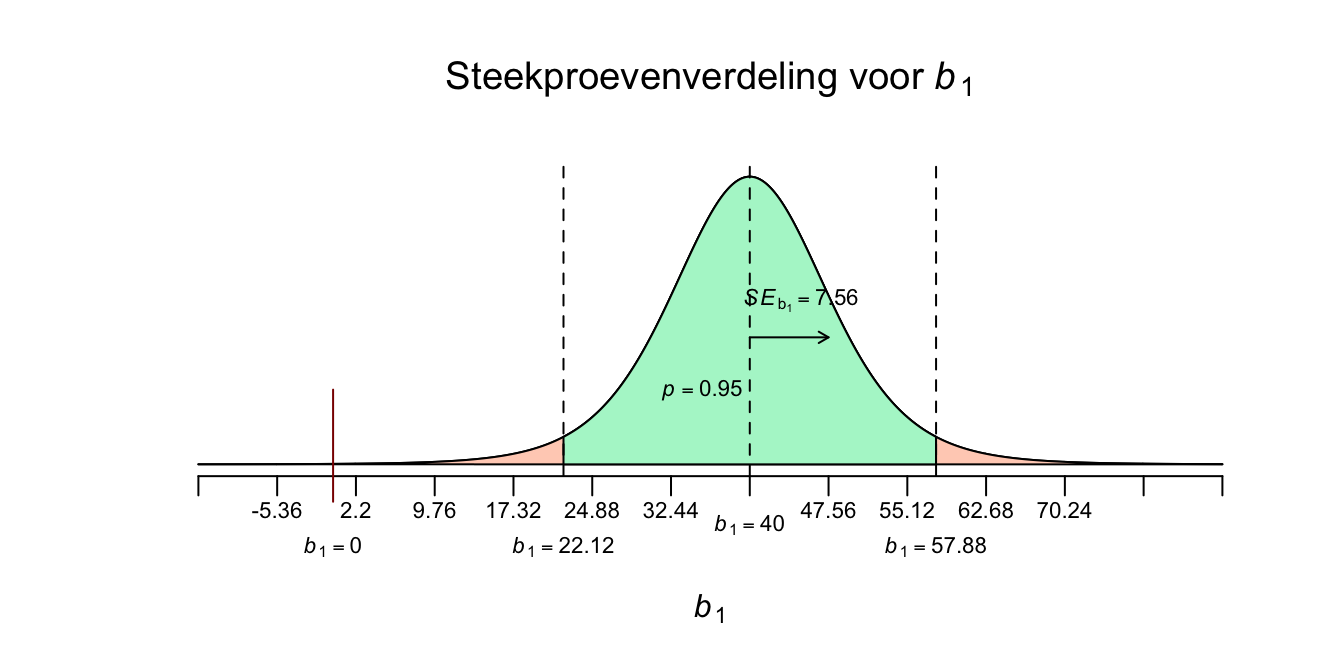

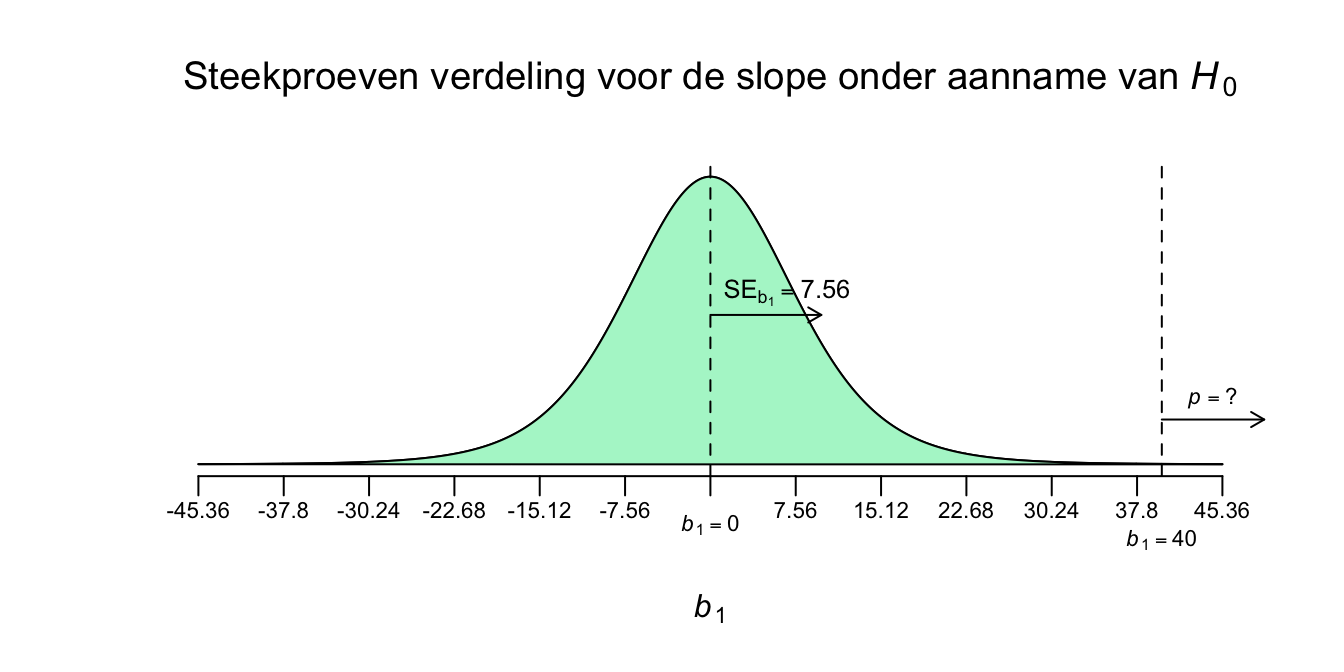

In onze enige echte steekproef hebben we een slope gevonden met een waarde van \(b_1 = 40\) gebaseerd op een steekproef van \(n = 9\). Als je nu al de onderzoeksvraag moest beantwoorden, maar met slechts één enkel getal, een puntschatting dus, wat zou jij dan zeggen qua waarde voor de populatieslope (\(\beta_1\))? Stel dat je nu nog veel meer steekproeven zou nemen. Denk dus weer aan een grabbelton waarvan je alleen weet hoe de eerste en enige echte steekproef die je daaruit hebt genomen, eruit ziet, voor de rest weet je niets. Wat zou jij zeggen als je nu een nieuwe steekproef neemt en opnieuw de slope zou uitrekenen, welke waarde zou je dan verwachten? Ik hoop hetzelfde als wat je in je eerste steekproef hebt gevonden (\(b_1 = 40\)). Stel dat je dit spel eindeloos herhaalt en je rekent je voor al die steekproeven de waarde van hun (individuale steekproef-) slope uit, zeg duizend keer (liefst nog vaker natuurlijk). Als je dit werkenlijkzou doen, heb je weer een steekproevenverdeling, maar dan dus eentje voor de slope! Elke keer als je een steekproef neemt, is de verwachting dus dat je een waarde rond de \(40\) zal vinden (want dat vond je ook in je enige echte steekproef). Dus al die duizenden slopes liggen qua waarde rond de \(40\), de één wat dichter bij dan de andere. Door steekproef-fluctuatie zal de waarde dus rond \(40\) variëren. Om te weten met hoeveel variatie de slope zal variëren, kun je de standaard error (voor de slope) uitrekenen:

\(\:\:\:\:\:\:SE_{b_1} = \frac{S_e}{\sqrt{(n-1)\cdot S_x^2}}\) invullen geeft:

\(\:\:\:\:\:\:SE_{b_1} = \frac{9.2582}{\sqrt{(9-1)\cdot 0.1875}}=\frac{9.2582}{\sqrt{8\cdot 0.1875}} = \frac{9.2582}{\sqrt{1.5}} = 7.5593\)

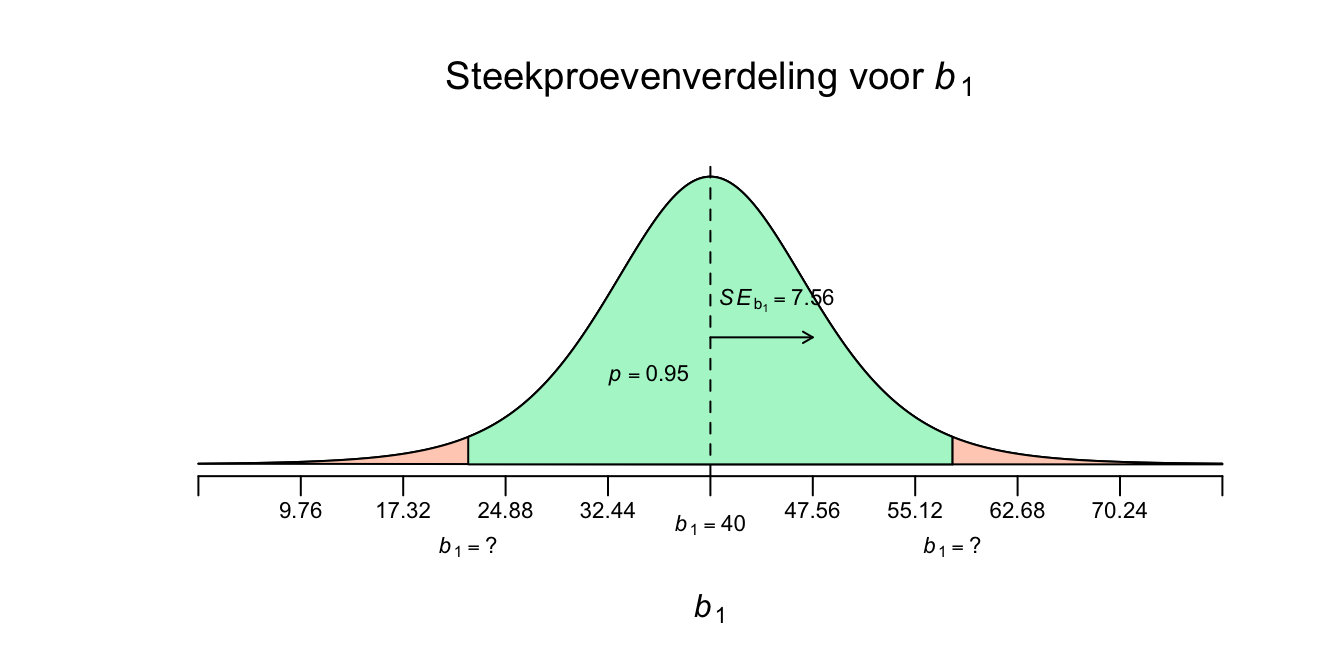

Afgerond heeft de standaard error voor \(b_1\) dus een waarde van \(7.56\). Nu weten we hoe sterk de gebeurtenis \(b_1\) zal varieëren in de steekproevenverdeling (bij herhaalde steekproeftrekking) en kunnen we dus een schets maken van de steekproevenverdeling. De standaard error voor de slope (\(SE_{b_1}\)) kun je als volgt interpreteren: Het is de gemiddelde gokfout die je maakt als je verwacht dat de slope \(40\) zal zijn en dat dus telkens als beste gok of verwachting neemt. Alle steekproefuitkomsten zullen daar dan, gemiddeld gezien, \(7.56\) punten (of centimeters in ons geval) naast zitten. Hoe kleiner de \(SE\), hoe minder variatie, en hoe stabieler je uitkomst dus zal zijn bij herhaling van steekproeftrekking. Hoe groter je steekproef (de enige echte) hoe kleiner je \(SE\) zal zijn, net zoals bij \(SE\)’s voor gemiddelden \(SE_{\bar{y}}\) zoals in hoofdstuk 4. Hieronder dus de steekproevenverdeling voor de slope.

Figuur 5.8: -

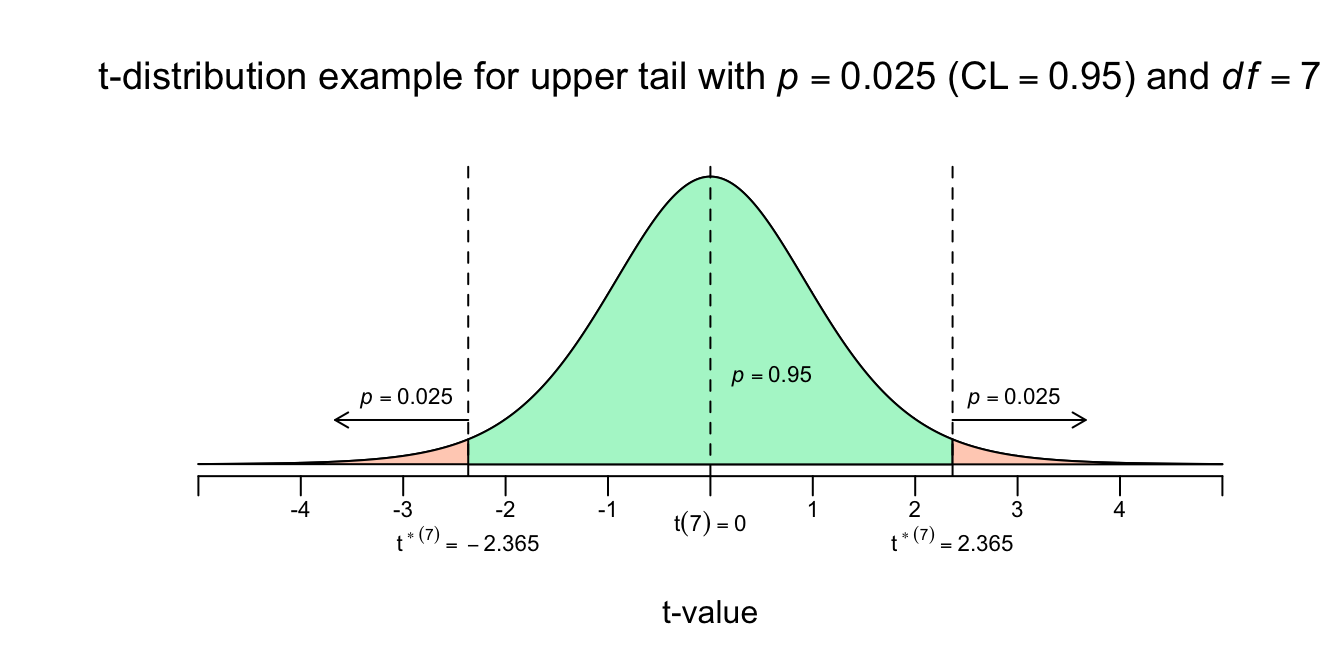

Om de onderzoeksvraag volledig te beantwoorden moeten we eerst nog de onder en bovengrens voor het betrouwbaarheidsinterval voor de ware slope vinden en dan wel met een confidence level van \(95\) procent. Of natuurlijk de margin of error, \(m\), zodat we weten hoeveel de ware slope, met \(95\) procent zekerheid naast je puntschatting kan zitten. Ook slopes gedragen zich volgens de \(t\)-verdeling, dus we kunnen de \(t\)-tabel gebruiken om op te zoeken hoeveel standaard errors we naar links en naar rechts moeten wandelen om de onder en bovengrens te bereiken. Bij het opzoeken gebruiken we het aantal vrijheidsgraden die bij de ERROR hoort: \(dfE = n-p-1 = 9-1-1 = 7\). Bedenk nog even dat bij een betrouwbaarheidsinterval altijd een symmetrische driedeling hoort met, in ons geval, een middenstuk van 95 procent en twee staartjes van 2.5 procent. Dus je kan zoeken bij een rechterstaart van met \(p = .025\) en \(df = 7\).

Figuur 5.9: -

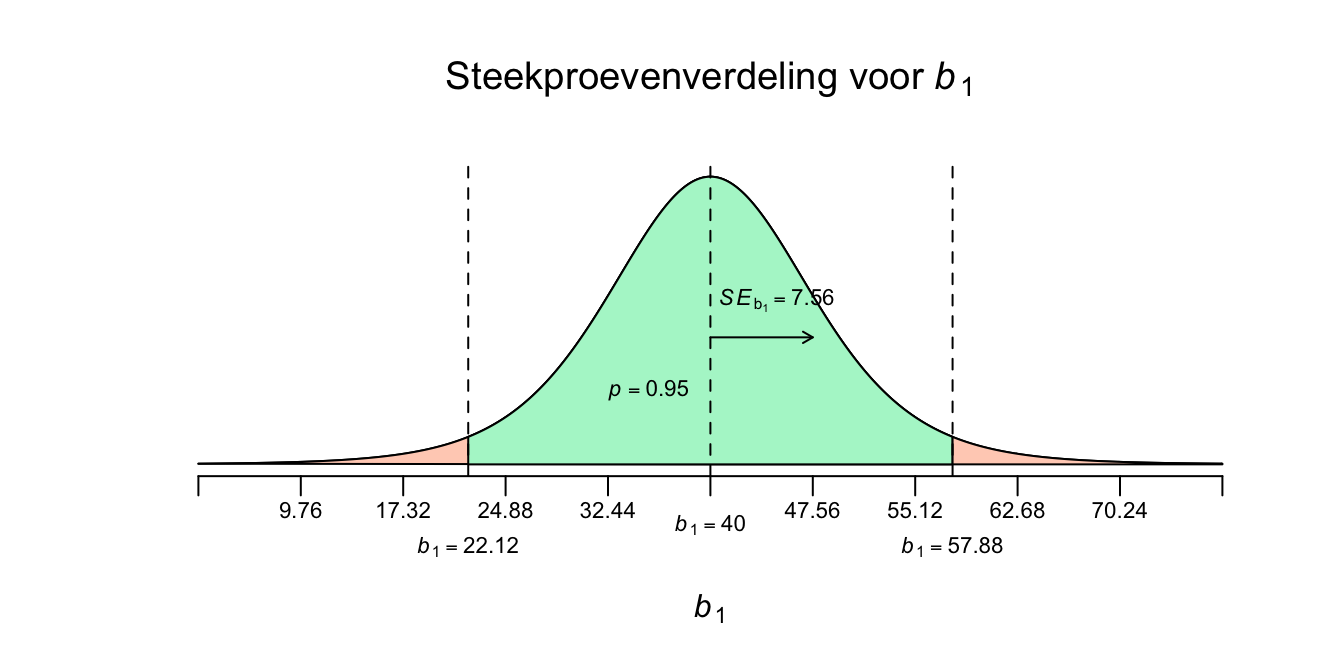

We zijn er bijna. Nu weten we het aantal standaard errors dat we moeten wandelen (\(t_7^{*} = 2.365\)). We gaan dus \(2.365\) SE’s naar links en naar rechts vanuit het midden, met de formule erbij geeft dat:

Lower and Upperbound for Confidence Interval (\(CI\)) for population slope (\(\beta_1\)):

\(\:\:\:\:\:\:b_1 \pm t^{*} \cdot SE_{b_{1}}\:\:\:\:\) en \(\:\:\:\:df = n-p-1\)

Voor de ondergrens krijgen we:

\(\:\:\:\:\:\:40 - 2.365 \cdot 7.56\)

\(\:\:\:\:\:\:40 - 17.88 = 22.12\)

Dus voor de bovengrens krijgen we:

\(\:\:\:\:\:\:40 + 2.365 \cdot 7.56\)

\(\:\:\:\:\:\:40 + 17.88 = 57.88\)

Nu kunnen we tot een conclusie overgaan. We hebben één steekproef getrokken en vonden een waarde van \(b_1 = 40\) en we kunnen dus nu stellen dat bij steekproef-herhaling, we met 95 procent zekerheid, een nieuwe steekproefslope zullen vinden tussen de waarden \(b_1 = 22.12\) en de \(b_1 = 57.88\). We generaliseren deze uitspraak dus ook naar de populatieslope: Met \(95\) procent zekerheid ligt de waarde van \(\beta_1\) dus ergens tussen de waarden \(22.12\) en de \(57.88\). Of voor in je artikel:

\(\:\:\:\:\:\:95\%\:\:CI_{\beta_1} = [22.12;\:57.88]\)

We kunnen dus nu zeggen dat die ware slope dus ergens tussen de \(22.12\) en de \(57.88\) zit qua waarde. Officieel is de interpretatie van een betrouwbaarheidsinterval iets ingewikkelder, net zoals bij gemiddelden, maar in het gebruik kom je het gewoon tegen zoals hierboven beschreven. Dus laten we niet moeilijker doen dan nodig. Onze uitkomst wil dus zeggen dat in het ‘slechtste’ geval de lijn een helling heeft van \(22.12\) en dat twee aapjes dus naar verwachting dus \(22.12\) cm in lengte verschillen als ze in leeftijd precies één jaar verschillen. Terwijl als de slope juist een waarde van \(57.88\) had gehad zouden twee aapjes, die één jaar in leeftijd van elkaar verschillen dus maar liefst \(57.88\) cm qua lengte verschillen, een stuk meer dus. Of anders gezegd de ware regressielijn zou in het slechtste geval een helling hebben van \(22.12\) en in het geval met het meeste verband dus een helling van \(57.88\), een stuk steiler dus. Hadden we een een stelsel van hypotheses nodig om een betrouwbaarheidsinterval te maken? Nee, maar we kunnen wel een uitspraak doen over een \(H_0\) op basis van het gevonden interval, laten we dat meteen maar doen, kijk eerst maar even naar het plaatje met het \(95 \%\) betrouwbaarheidsinterval:

Figuur 5.10: -

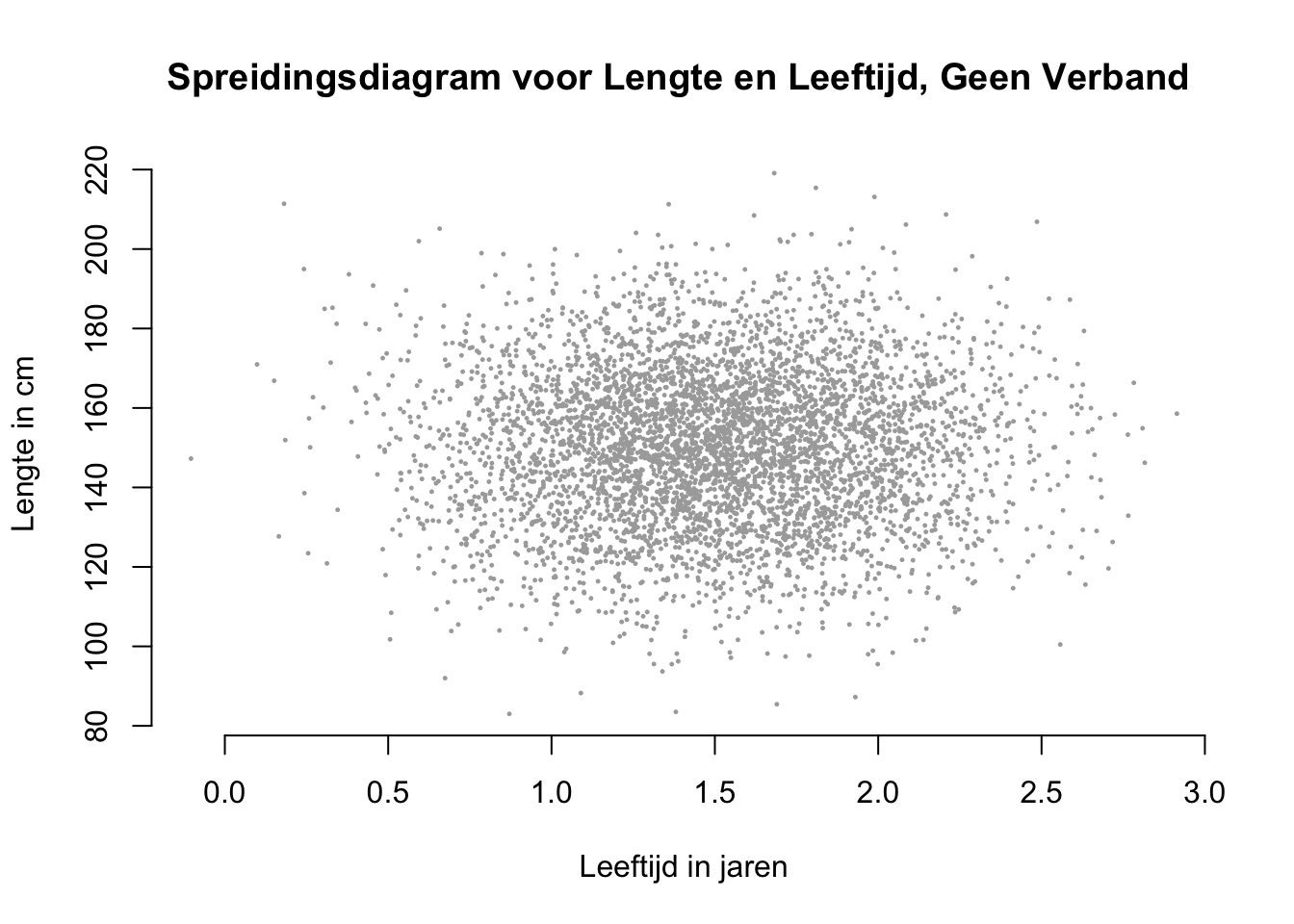

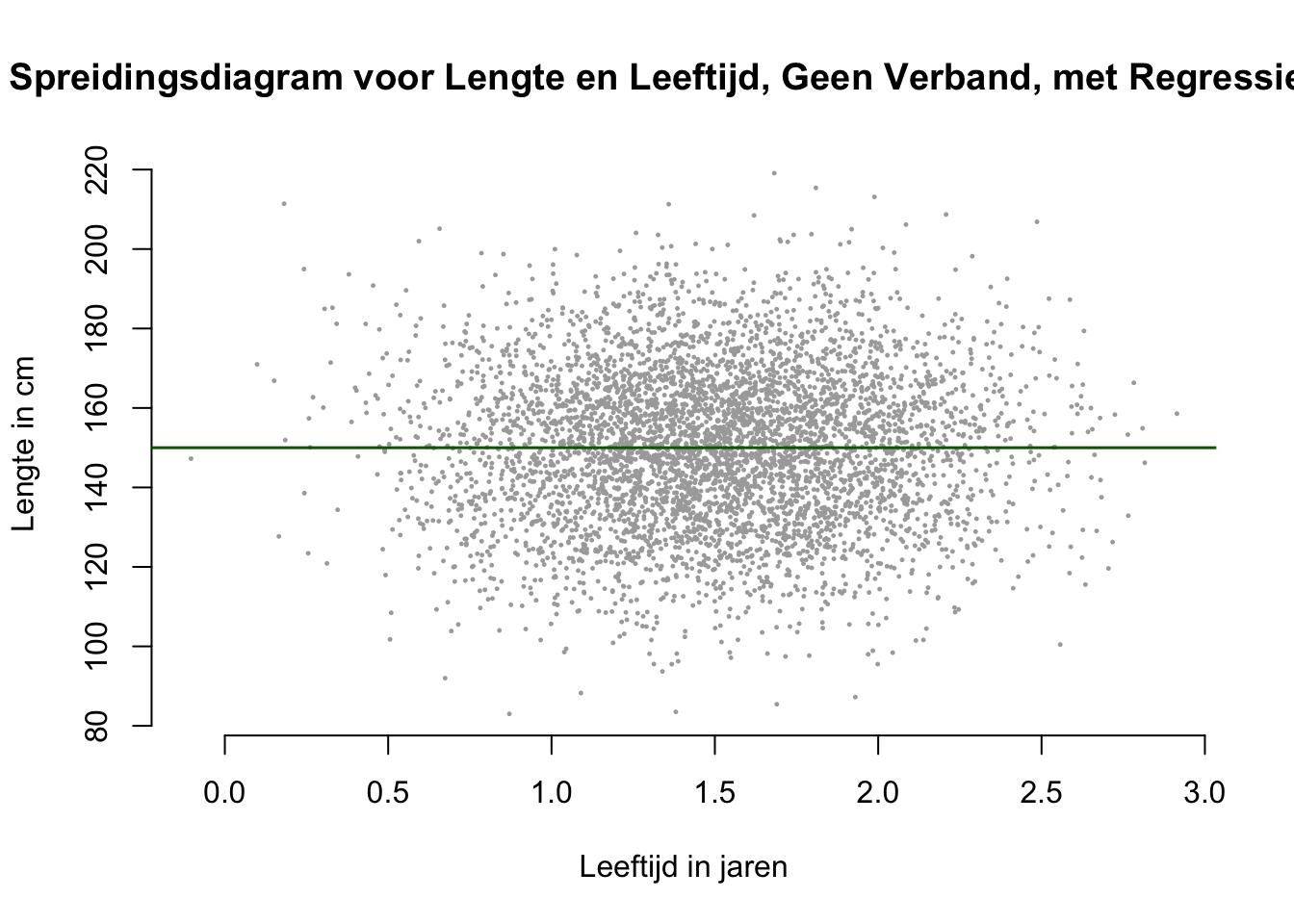

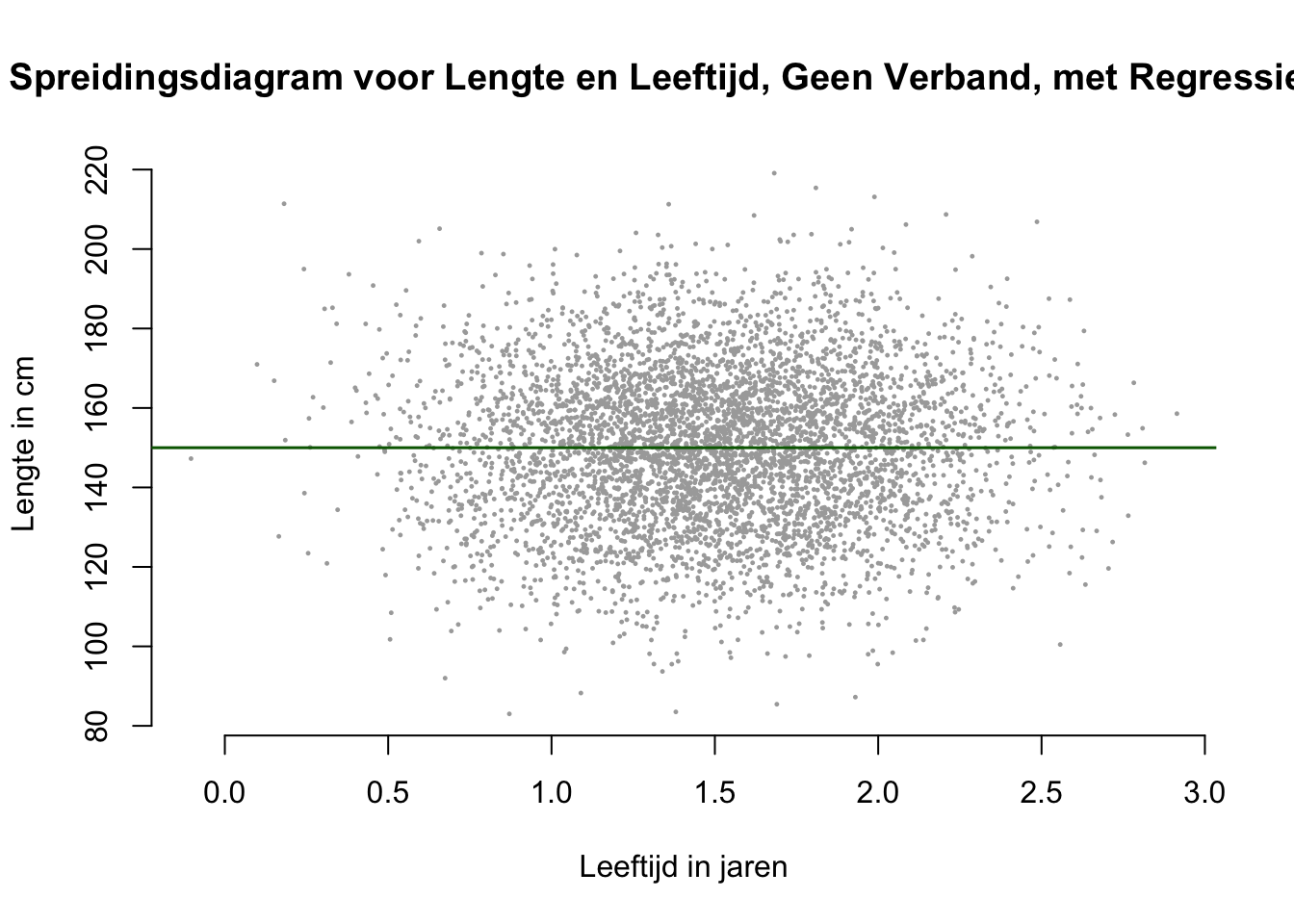

De \(H_0\) die zegt natuurlijk dat er geen verband of geen voorspelling mogelijk is voor lengte, op basis van leeftijd. Hoe ziet dan een popluatiepuntenwolk eruit als geen verband is? De puntenwolk ligt dan horizontaal (ovaal of gewoon rond), omdat dan, voor iedere waarde van \(X\) de gemiddelde waarde van \(Y\) hetzelfe is. Dus als je bijvoorbeeld de waarde \(X = 1.75\) neemt, zie je dat de \(Y\)-waarden daarboven variëren en dat het gemiddelde rond ter hoogte van \(Y=150\) ligt. Zo ook voor de andere waarden van \(X\). Het maakt dus niet uit wat de \(X\)-waarde is, de voorspelling voor \(Y\) blijft altijd hetzelfde, dus geen verband.

Als een puntenwolk horizontaal gepositioneerd is dan ligt de best passende lijn dus óók horizontaal. Zie plaatje hieronder met een horizontale regressielijn. Dus als je ergens op die lijn staat en je wandelt één eenheid (qua \(X\)) naar rechts, hoef je dus niet omhoog of omlaag want de slope is daar dus gelijk aan \(0\).

De \(H_0\) die stelt dus dan ook: \(\beta_1=0\). Een helling of slope van \(0\) betekent dus dat er geen verband is. Kijk nu nog een keer naar ons \(95\%\) Betrouwbaarheidsinterval hieronder nog een keer.

Figuur 5.11: -

En kom je die waarde tegen als je van je linker grens naar je rechter grens wandelt? Nee, de \(H_0\)-verwachting (\(b_1 = 0\)) kom je niet tegen en is die nul-waarheid dus ook onwaarschijnlijk, en daarmee te verwerpen! Omdat we de \(H_0\)-verwachting (\(b_1 = 0\)) niet tegenkomen, lijkt de alternatieve hypothese dus waarschijnlijk (\(H_1:\) \(\beta_1 \ne 0\)). We kunnen dus aannemen (op basis van het \(95\%\) \(CI\)) dat er een verband is (oudere aapjes zijn over het algemeen langer, jongere aapjes over het algemeen kleiner) en dat je dus wel degelijk leeftijd kan gebruiken om lengte te voorspellen!

5.5.2 Significantietoets voor de Populatie Slope

Beetje flauw dus als je al weet, vanwege de vorige paragraaf, welke hypothese het meest waarschijnlijk is gegeven onze enige echte steekproef. We doen maar even of ons neusje bloedt en toetsen de boel (het stelsel van hypothese) nu netjes via een significantietoets.

Onderzoeksvraag:

Is er een verband tussen leeftijd en lengte in de populatie aapjes? Of;

Kunnen we op basis van leeftijd, lengte voorspellen?

Is er een effect leeftijd op lengte?

Weer allemaal hetzelfde natuurlijk en gesteld in termen van \(H_1\), maar dan wel met een vraagteken. Besef ook dat ik de onderzoeksvraag tweezijdig heb geformuleerd, omdat ik in het midden laat of het verband positief of negatief is. Lang leve Pipi Langkaus dus;

Stelsel van hypotheses in woorden:

\(\:\:\:\:\:\:H_0\) : Geen verband tussen leeftijd en lengte

\(\:\:\:\:\:\:H_1\) : Wel verband tussen leeftijd en lengte

Stelsel van hypotheses formeel:

\(\:\:\:\:\:\:H_0\) : \(\beta_1 = 0\)

\(\:\:\:\:\:\:H_1\) : \(\beta_1 \ne 0\)

of;

\(\:\:\:\:\:\:H_0\) : \(\rho_1 = 0\)

\(\:\:\:\:\:\:H_1\) : \(\rho_1 \ne 0\)

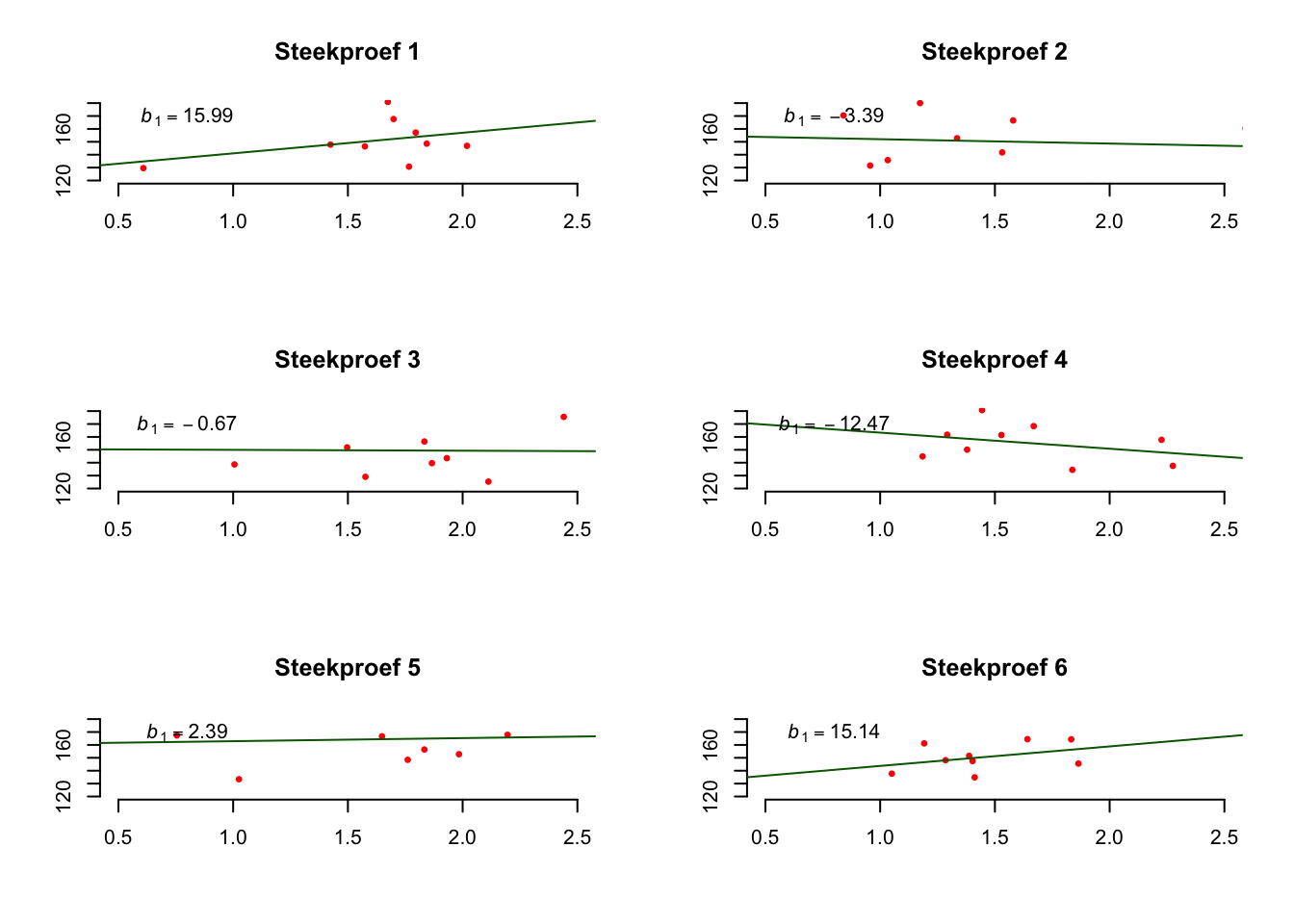

Bij dit laatste stelsel denk je meer in termen van correlatie, maar als er een correlatie is, dan is er ook regressie mogelijk, wat mij betreft nog steeds allemaal één pot nat! Goed, daar gaan we. We toetsen de \(H_0\), altijd en altijd, dus laat die ook even waar zijn, en vergeet nog eventjes de enige echte steekproef. Denk dus maar aan een grabbelton met aapjes waarvoor geldt dat er _geen_verband is tussen leeftijd en lengte. Een ton waarvoor dus een populatie-puntenwolk geldt die horizontaal ligt. Zie plaatje:

Figuur 5.12: -

Als de \(H_0\) waar zou zijn, en je zou dan een steekproef (\(n=9\)) nemen uit deze ton en de slope uitrekenen, welke waarde zou je dan verwachten voor je steekproef resultaat voor \(b_1\), de slope? Als er geen verband is, zou je natuurlijk (idealiter of ongeveer) \(b_1 = 0\) moeten vinden. Ik heb voor de grap maar es \(6\) steekproefjes genomen uit die nul-ton en dus zes keer de slope berekend (zie hieronder), al zijn ze niet precies nul, maar ze liggen wel dichtbij de waarde nul. Je ziet dus dat de slope zal variëren rond nul.

Figuur 5.13: -

Wat denk jij? zou de uitkomst \(b_1 = 40\) een fiets zijn? Ik denk het wel! Laten we maar gaan toetsen.

5.5.2.1 De t-toets voor een regressieslope

Voor de onderzoeksvraag of er een verband is tussen leeftijd en lengte in de populatie aapjes, gebruik ik nu even het volgende stelsel van hypothese (zodat we vooral in termen van slope kunnen denken, maar het maakt dus niet zoveel uit):

\(\:\:\:\:\:\:H_0\) : \(\beta_1 = 0\)

\(\:\:\:\:\:\:H_1\) : \(\beta_1 \ne 0\)

- Met onze enige echte steekproefgegevens:

- \(n=9\), \(\overline{Y} = 150\), \(S_y^2 = 375\),

- \(\overline{X} = 1.50\), \(S_x^2 = 0.1875\),

- \(r_{xy} = .8944\),

- \(\hat{Y}_i = 90 + 40 \cdot X_{i}\), (\(b_0 = 90\), \(b_1 = 40\)),

- \(R_{yx}^2 = .80\)

- \(SST = 3000\), \(SSM = 2400\), \(SSE = 600\),

- \(S_e = 9.2582\)

- Stap 1: Schets de steekproevenverdeling onder aanname dat de \(H_0\) waar is, we toetsen immers de ‘houdbaarheid’ van de \(H_0\):

- Zet je \(H_0\) verwachting (\(b_1 = 0\)) in het midden

- Bereken de standaard error voor de slope \(SE_{b_1} = \frac{S_e}{\sqrt{(n-1) \cdot S_x^2}}\)

- \(SE_{b_1} = \frac{9.2582}{\sqrt{8 \cdot 0.1875}} = 7.56\)

- Zet je enige echte steekproef-slope erin (\(b_1 = 40\)) en beoordeel zelf vast grofjes of je (voldoende) bewijs (verschil) ziet om de \(H_0\) te verwerpen:

In geval van een links of rechtszijdige toetsing (hier dus niet), kijk je of de slope ook echt daadwerklijk links of rechts zit van \(b_1 = 0\) zoals verwacht onder de alternatieve hypothese, zo niet, zit hij aan de verkeerde kant, kan je dus al meteen stoppen, omdat je dan al weet dat het niet in die richting zit zoals jij gesteld had in de alternatieve hypothese (en daardoor kun je sowieso de \(H_0\) niet verwerpen).

Kijk vast hoeveel standaard errors de enige echte slope van het midden verwijderd zit.

Maak een schatting van je éénzijdige \(p\)-waarde (dus weg van het midden), bij ons dus de rechter staart, zie hieronder, hij is wel erg klein vind je niet?

Figuur 5.14: -

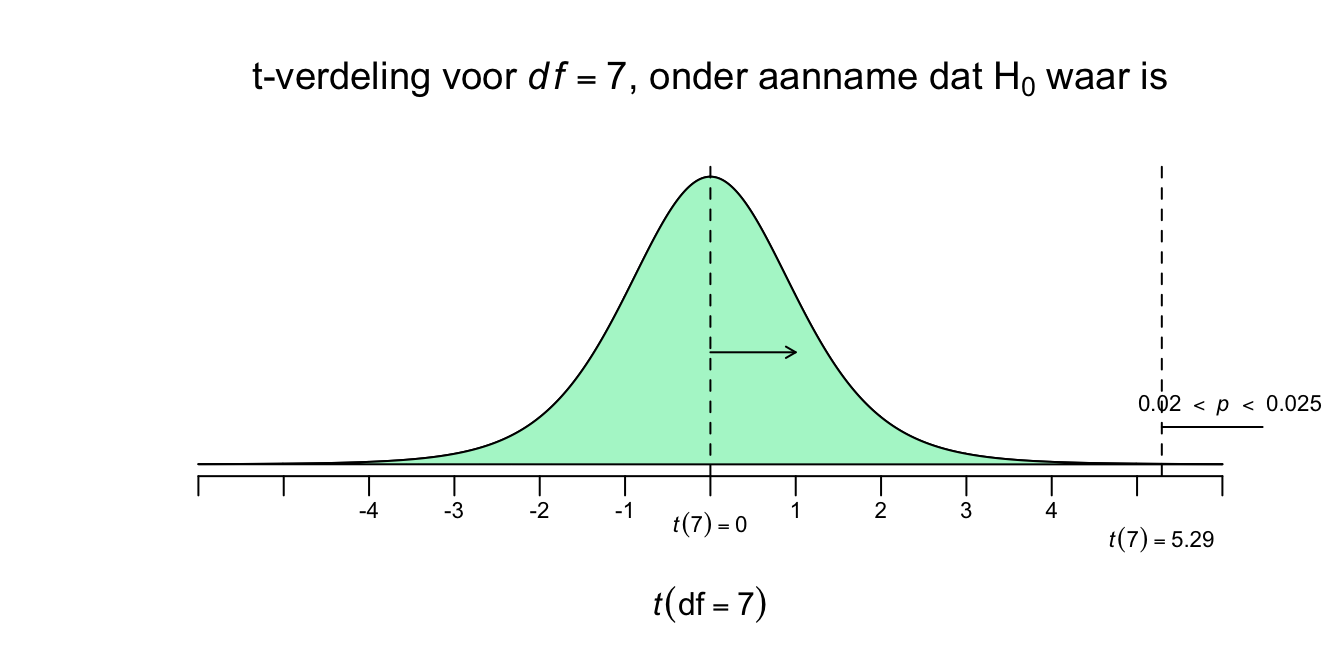

- Stap 2: We gaan over tot standaardizatie (om uiteindelijk de \(p\)-waarde te kunnen opzoeken. Een slope gedraagt zich volgens de \(t\) verdeling met het aantal vrijheidsgraden voor de Error (\(dfE = n - p -1\), met \(p\) voor het aantal predictoren dus, hier alleen leeftijd). Schets nu de t-verdeling en

- Bereken je bijbehorende toetsstatistiek, jouw \(t\)-waarde dus. Ook hier betekent ‘\(t\)’ gewoon het aantal standaard errors dat onze slope weg van het midden (de \(H_0\)-verwachting) zit.

- \(t(df) = \frac{b_1}{SE_{b_1}}\) met \(dfE = n-p-1\)

- \(t(df) = (40)/7.56 = 5.291\) met \(df = 9-1-1= 7\) dus;

- \(t(7) = 5.29\)

- \(t(df) = \frac{b_1}{SE_{b_1}}\) met \(dfE = n-p-1\)

- Zet je \(t\)-waarde in de schets en zoek de juiste éénzijdige \(p\)-waarde op (bij het juiste aantal vrijheidsgraden) en zet de gevonden \(p\)-waarde bij de rechter staart in je schets.

- Onze toetstatiek (\(t^(7) = 5.29\)) zit tussen de \(t^{*}(7) = 4.785\) en de \(t^{*}(7) = 5.408\) en natuurlijk zoek je eerst de rij met het juiste aantal vrijheidsgraden op, voor \(df = 7\). Omdat die kleinere \(t\)-waarde, een grotere rechterstaart (\(p=.0010\)) heeft dan die van ons (\(p=??\)), en de grotere \(t\)-waarde juist een kleinere staart (\(p=.0005\)) heeft dan die van ons (nog steeds \(p=??\)), ligt onze \(p\) natuurlijk daartussen (“Ja ja, best lastig.” zei Flip). Dus;

- \(t^(7) = 5.29\), \(.0005 < p < .0010\) (éénzijdig)

- Is je alternatieve hypothese éénzijdig, dan ben je klaar en kun je overgaan tot een beslissing, op basis van je éénzijdige \(p\)-waarde.

- Is je alternatieve hypothese twéézijdig, dan vermenigvuldig je jouw gevonden \(p\)-waarde nog met \(2\) voordat je kunt overgaan tot een beslissing. Wij moeten dus nog even met \(2\) vermenigvuldigen, dus bij ons:

- \(t^(7) = 5.29\), \(.0010 < p < .0020\) (twéézijdig).

- Weet jij nog wat de toetswaarden waren bij de toetsing van de correlatie (\(r_{xy}\)) in hoofdstuk 4? Ik bedoel maar, regressie of correlatie, allemaal één pot nat!

- \(t^(7) = 5.29\), \(.0010 < p < .0020\) (twéézijdig).

- Bereken je bijbehorende toetsstatistiek, jouw \(t\)-waarde dus. Ook hier betekent ‘\(t\)’ gewoon het aantal standaard errors dat onze slope weg van het midden (de \(H_0\)-verwachting) zit.

Figuur 5.15: -

Conclusie:

We hebben nu dus de juiste twéézijdige \(p\)-waarde te pakken. Die is behoorlijk klein, namelijk zelfs iets kleiner dan twee tiende procent (\(.0010 < p < .0020\)). Dit betekent, als er in het écht geen verband is, er een heel kleine kans bestaat, dat wanneer je een steekproef trekt, dat je een slope extremer dan een waarde van \(b_1 = 40\) (of extremer dan \(b_1 = \text{-}40\), maar dan wel links daarvan) vindt. En tóch hebben wíj hem gevonden. Hoe raar en onverwachts. Dus gegeven dat de \(H_0\) waar is, is onze steekproefuitkomst (\(b_1 = 40\)) behoorlijk onverwachts en we schrikken er dus een beetje van.

When \(p\) is low \(H\)-O must go!

ALs je met een significantieniveau van \(\alpha = .05\) hanteert bij toetsing, kunnen we dus de \(H_0\) verwerpen en stellen dat onze slope (\(b_1 = 40\)) significant afwijkt van de waarde \(b_1=0\) (zoals onder \(H_0\) verwacht). We nemen de gevonde afwijking dus serieus en kunnen dus het effect generaliseren en zeggen dat de slope dus in de populatie ook van \(0\) zal afwijken (en positief is, al stelde de \(H_1\) dit strikt genomen niet, maar we zeggen het vaak wel!). Ook als we strenger waren geweest bij toetsing en een kleinere \(\alpha\) hadden gekozen (zolang die maar niet onder de \(\alpha =.002\) komt), zou het resultaat nog steeds significant zijn.

5.5.3 Betrouwbaarheidsinterval en Toetsing van het Intercept

Het intercept (\(\beta_0\) of \(b_0\)) in een regressievergelijking heeft niks met het verband te maken tussen onafhankelijke en de afhankelijke variabele. In die zin dus niet relevant. Het intercept is normaal gezien te interpreteren als de voorspelde waarde van \(Y\) (dus \(\hat{Y}\)) voor een case (aapje) die op de predictor variabele nul scoort. In geval van onze aapjes heeft het intercept een waarde van \(b_0 = 90\) en wiskundig zou je het dus kunnen interpreteren als de gemiddelde of voorspelde lengte bij geboorte (als \(X=0\).

\(\:\:\:\:\:\:\hat{Y}_i = 90 + 40 \cdot X_i\)

\(\:\:\:\:\:\:\hat{Y}_{x=0} = 90 + 40 \cdot 0 = 90\) of algemeen:

\(\:\:\:\:\:\:\hat{Y}_{x=0} = b_0 + b_1 \cdot 0 = b_0\)

Het enige probleem bij ons is dat onze aapjes een leeftijd hebben tussen de \(1\) en \(2\) jaar. De puntenwolk ligt dus boven de \(x=1\) en \(x=2\) en niet boven \(X=0\)! Het intercept ligt dus niet in de puntenwolk. Misschien is onze regressielijn alleen reeel boven onze \(X\)-waarden. We weten het niet want we hebben het niet onderzocht. Een regressielijn doortrekken tot (ver) buiten je wolk en die lekker toch gebruiken als voorspelling van \(Y\) bij \(X\)-waarden, die je nog nooit bent tegengekomen, noem je extrapolatie (‘extra’ van buiten, en ‘polatie’ wan waarde toekennen). Het zou ook raar zijn om te zeggen dat een aapje van \(X=10\) jaar, \(490\) cm zou zijn;

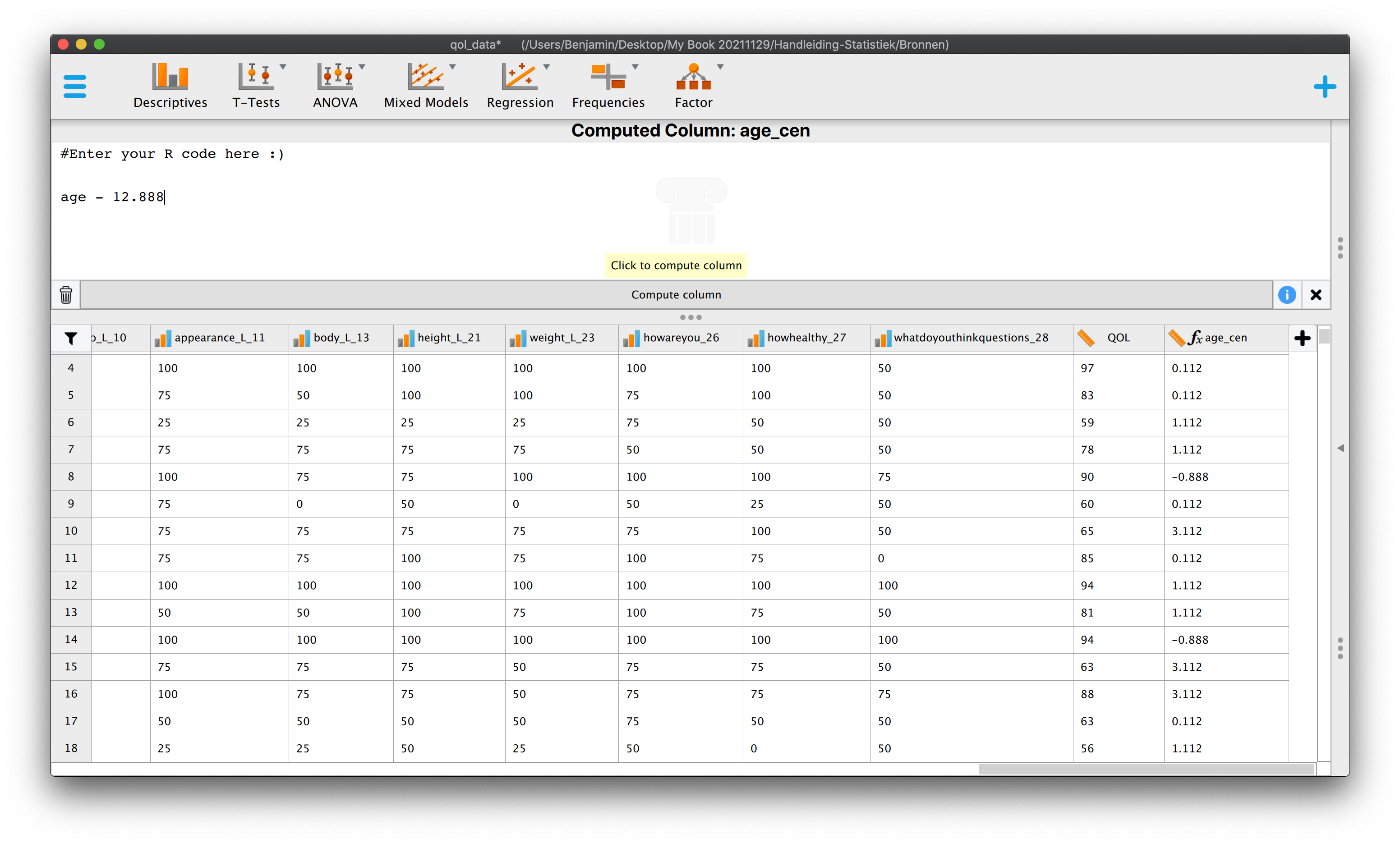

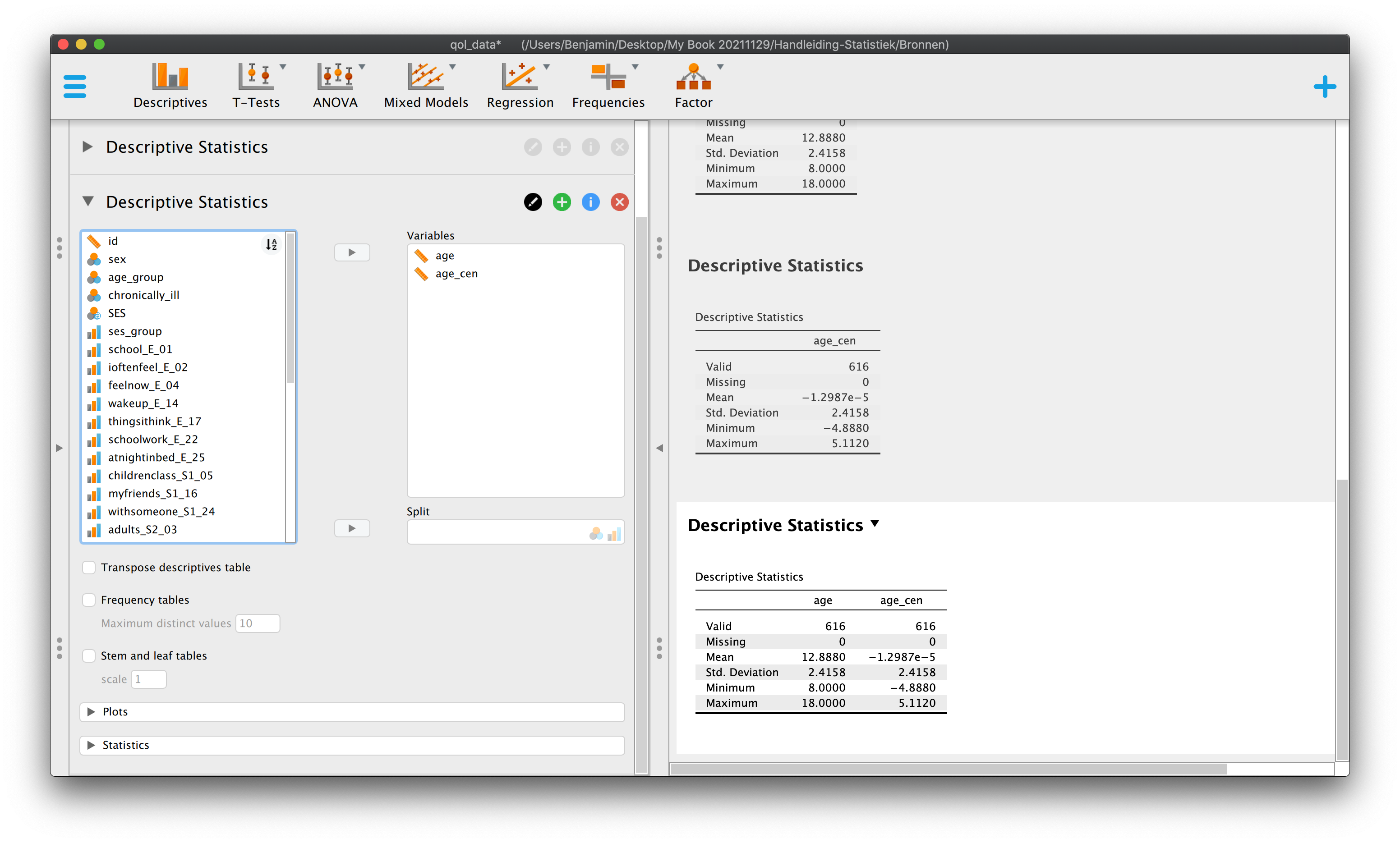

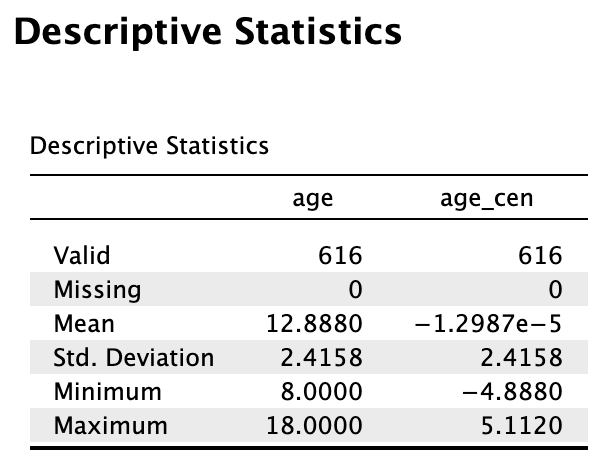

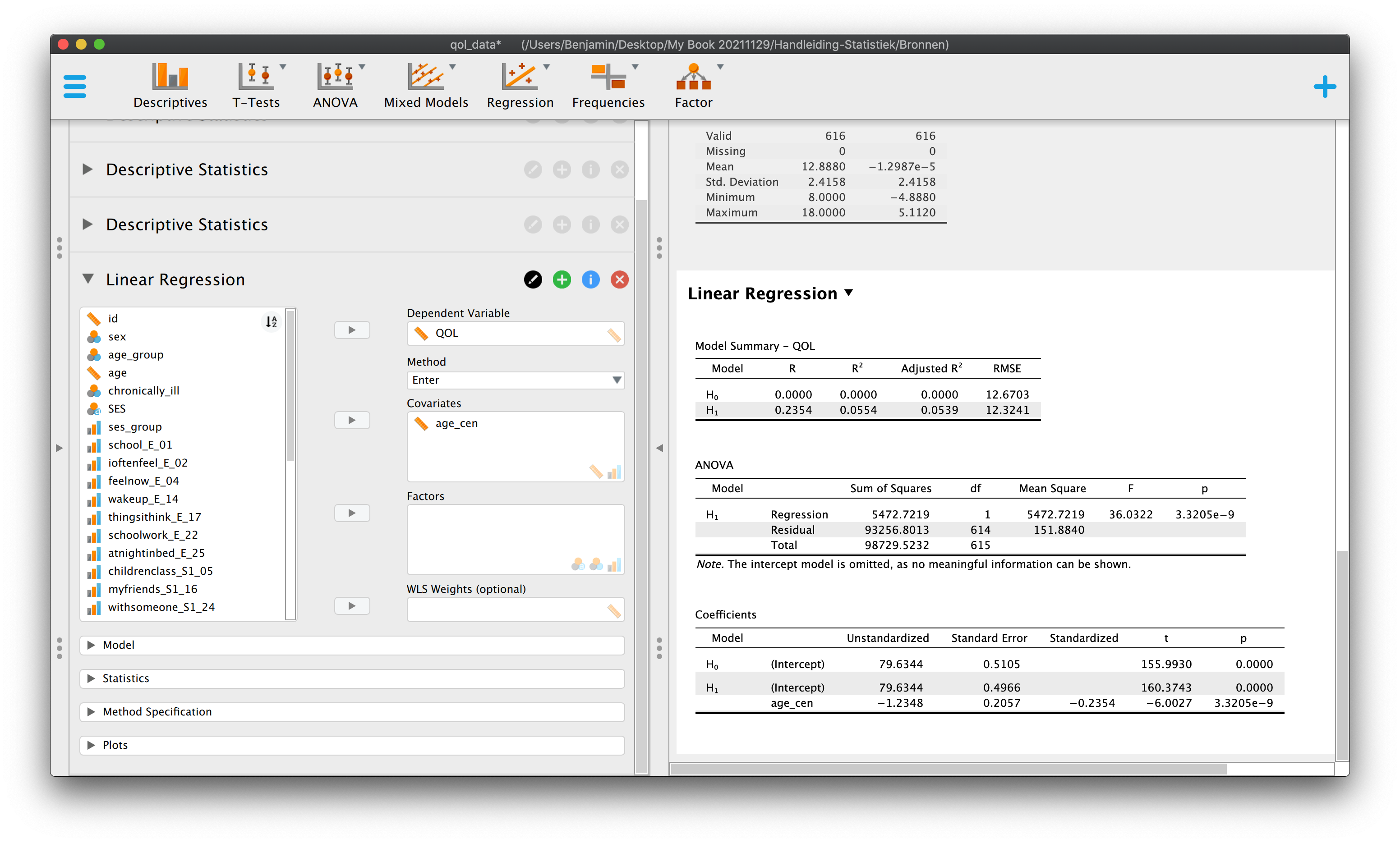

\(\:\:\:\:\:\:\hat{Y}_{x=10} = 90 + 40 \cdot 10 = 490\)

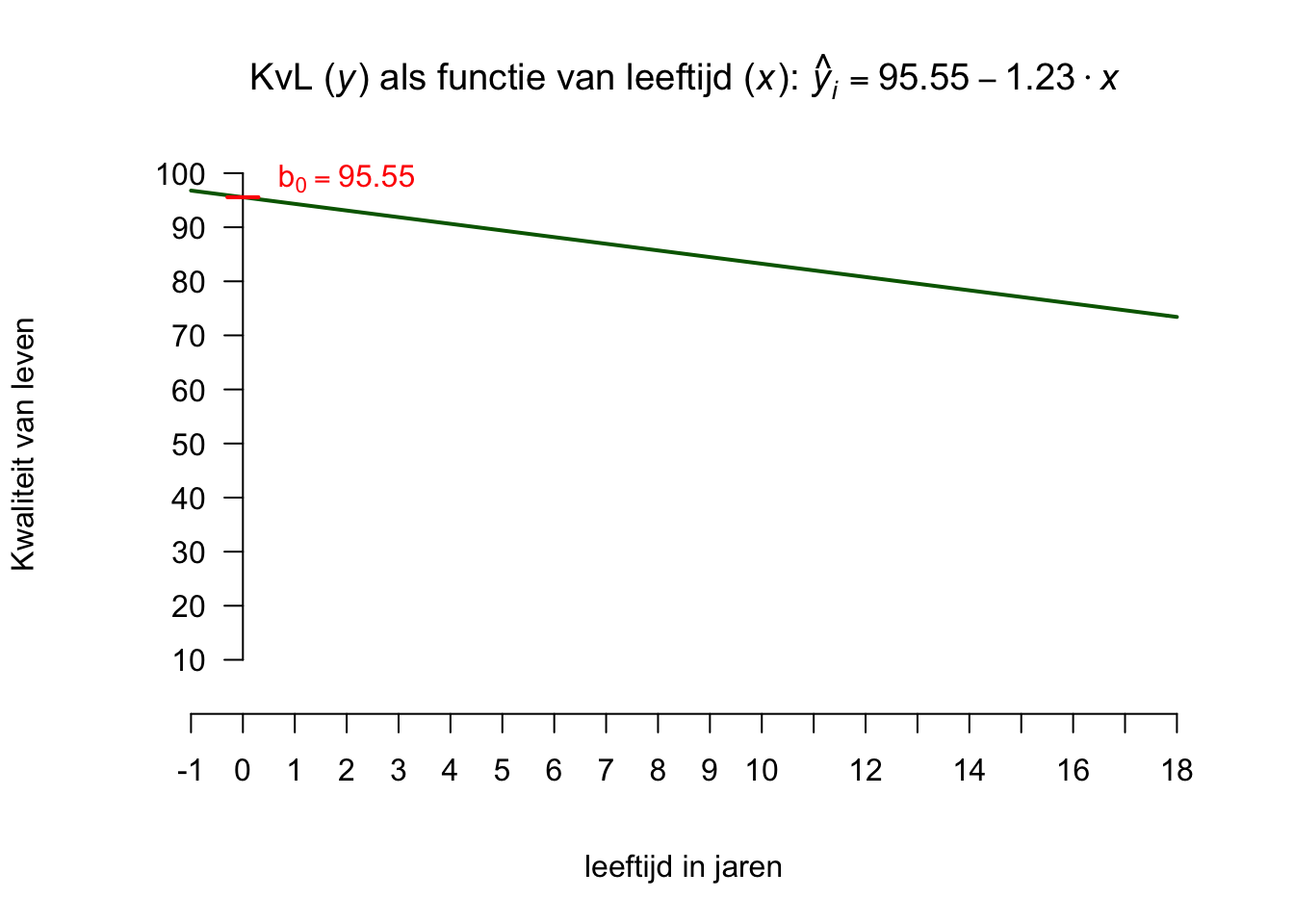

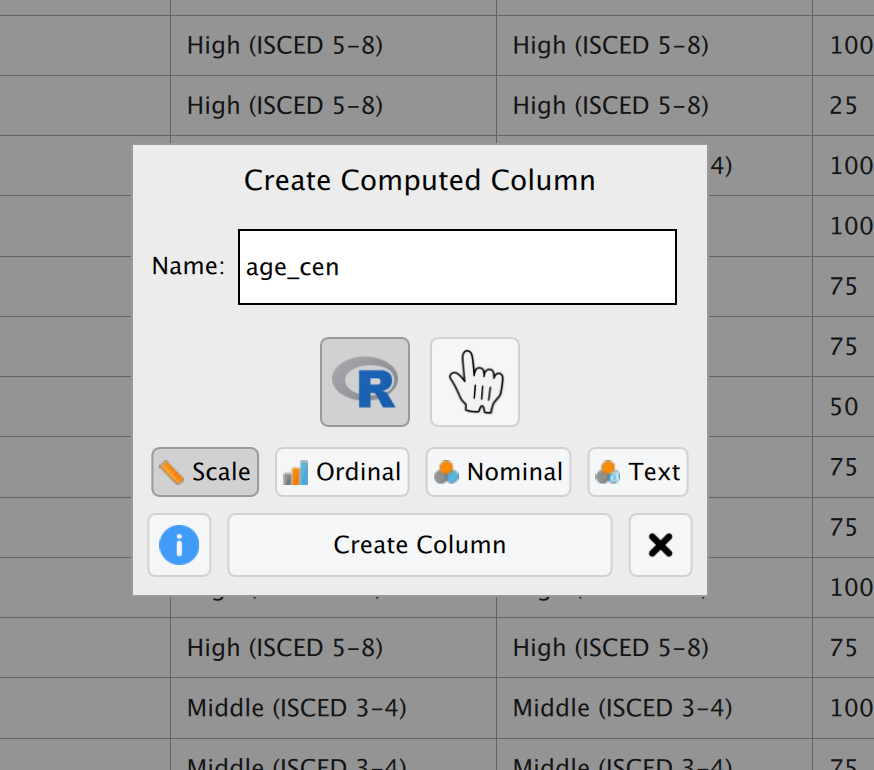

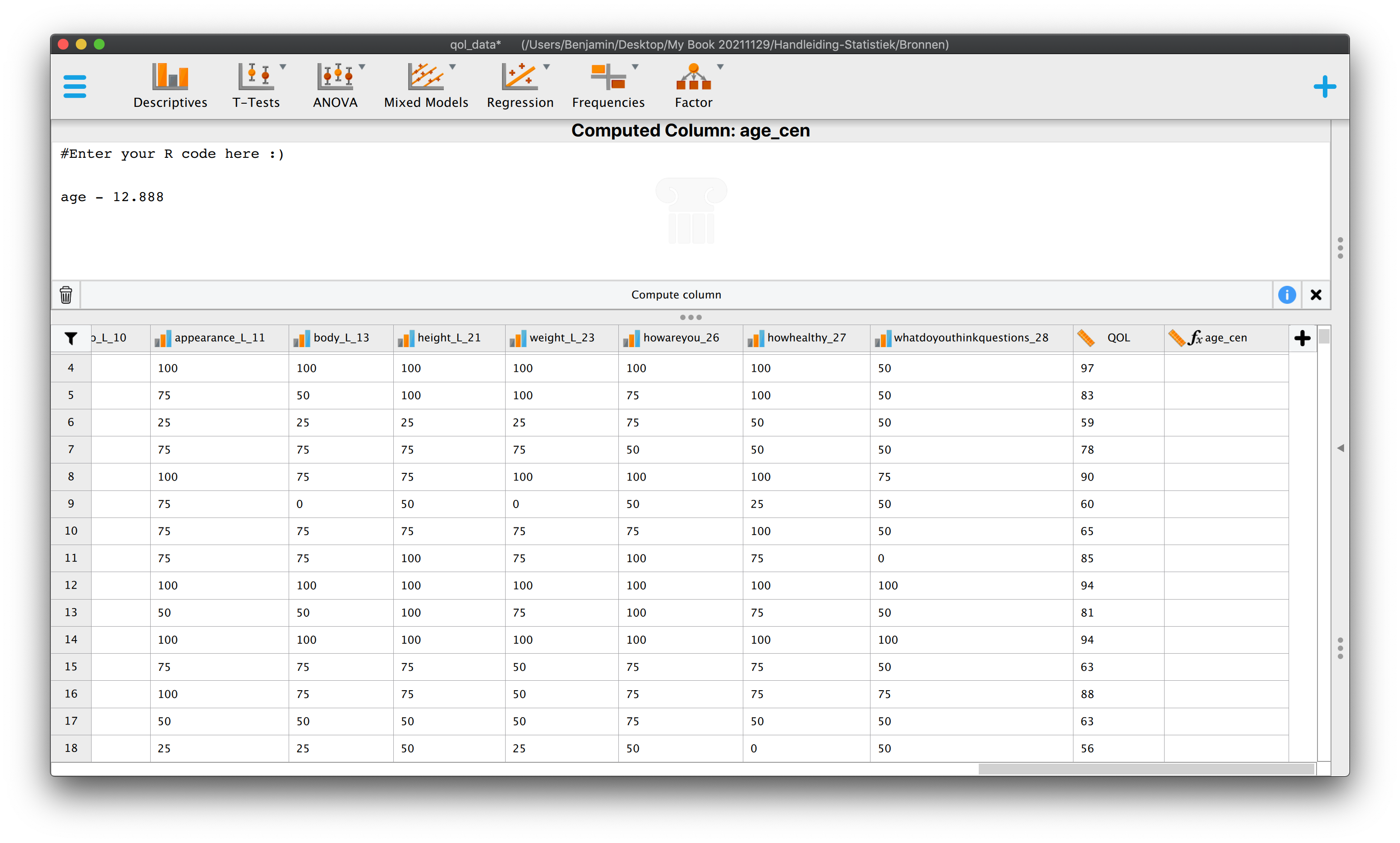

Anyway, you moet dus oppassen als je \(Y\)-waarden toekent op basis van een regressiemodel, bij waarden van \(X\) waar je niks over weet. Natuurlijk kunnen we toetsen of het intercept echt van \(0\) afwijkt, maar goed het zecht dus niets over het verband, het zegt hooguit iets of aapjes dus echt een gemiddelde lengte groter dan \(0\) hebben als ze geboren worden. Ik mag hopen van wel, maar om dit te doen hadden we dus eigenlijk ook aapjes in onze steekproef nodig die net geboren waren, hoe schattig zou dat zijn. In de JASP opgaven, laat ik zien hoe we toch het intercept betekenisvol kunnen maken als we geen \(0\)-waarden voor \(X\) hebben gemeten. Maar omdat een \(CI\) of toetsing dus kan, doe ik het even voor, in een wat sneller tempo, je hebt inmiddels heel wat oefening achter de rug.

5.5.3.1 Betrouwbaarheidsinterval voor het Populatie Intercept (\(\beta_0\))

Onderzoeksvraag: Wat is met \(95\) procent zekerheid het ware populatie intercept?

- Met onze enige echte steekproefgegevens:

- \(n=9\), \(\overline{Y} = 150\), \(S_y^2 = 375\),

- \(\overline{X} = 1.50\), \(S_x^2 = 0.1875\),

- \(r_{xy} = .8944\),

- \(\hat{Y}_i = 90 + 40 \cdot X_{i}\), (\(b_0 = 90\), \(b_1 = 40\)),

- \(R_{yx}^2 = .80\)

- \(SST = 3000\), \(SSM = 2400\), \(SSE = 600\),

- \(S_e = 9.2582\)

- Confidence Interval for Population Intercept (\(\beta_0\))

- lower and upperbound: \(b_0 \pm t_{dfE}^{*} \cdot SE_{b_0}\)

- Met \(SE_{b_0} = s_e \cdot \sqrt{\frac{1}{n} + \frac{\bar{x}^2}{(n-1)\cdot s_x^2}}\)

- invullen geeft: \(SE_{b_0} = 9.2582 \cdot \sqrt{\frac{1}{9} + \frac{1.5^2}{(9-1) \cdot 0.1875}}\)

- \(SE_{b_0} = 9.2582 \cdot \sqrt{\frac{1}{9} + \frac{2.25}{1.5}}\)

- \(SE_{b_0} = 9.2582 \cdot \sqrt{1/9 + 2.25/1.5}= 11.75139\)

- \(dfE = n-p-1 =9-1-1 = 7\)

- de \(t\)-tabel geeft voor \(CL_{95\%}\), \(t^{*}(7) = 2.365\)

- Met \(SE_{b_0} = s_e \cdot \sqrt{\frac{1}{n} + \frac{\bar{x}^2}{(n-1)\cdot s_x^2}}\)

- lower and upperbound: \(90 \pm 2.365 \cdot 11.75139\)

- lower and upperbound: \(90 \pm 27.79204\)

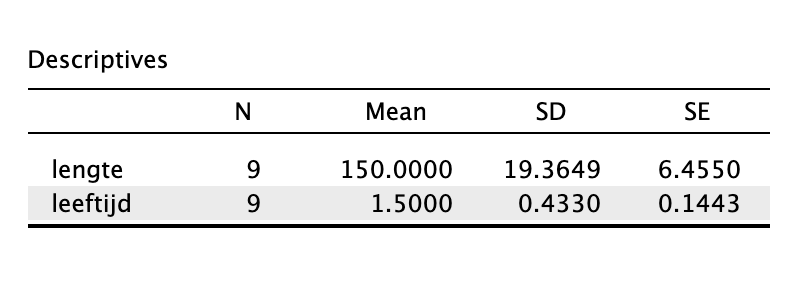

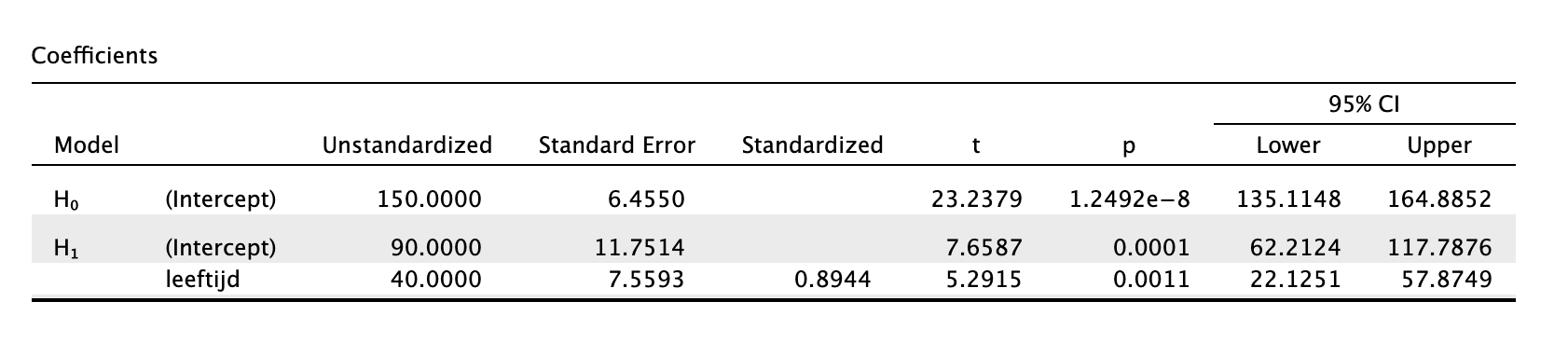

- \(CI_{95\%} \: \beta_0:\) \([62.21;\: 117.79]\)

- lower and upperbound: \(b_0 \pm t_{dfE}^{*} \cdot SE_{b_0}\)

Zo snel kan het dus, een betrouwbaarheidsinterval. Als conclusie kunnen we dus nu zeggen dat het ware intercept met \(95\) procent zekerheid ergens tussen de \(62.71\) en de \(117.79\) ligt, maar of we dit als gemiddelde geboortelengte mogen interpreteren weten we dus niet, niet doen dus!

5.5.3.2 Significantietoets voor het Populatie Intercept (\(\beta_0\))

Onderzoeksvraag: Wijkt het ware populatie intercept (\(\beta_0\)) echt af van \(0\)?

Om dit te onderzoeken (analyseren) stellen we eerst het bijbehorend stelsel van hypotheses op:

\(\:\:\:\:\:\:H_0\) : \(\beta_1 = 0\)

\(\:\:\:\:\:\:H_1\) : \(\beta_1 \ne 0\)

- Met onze enige echte steekproefgegevens:

- \(n=9\), \(\overline{Y} = 150\), \(S_y^2 = 375\),

- \(\overline{X} = 1.50\), \(S_x^2 = 0.1875\),

- \(r_{xy} = .8944\),

- \(\hat{Y}_i = 90 + 40 \cdot X_{i}\), (\(b_0 = 90\), \(b_1 = 40\)),

- \(R_{yx}^2 = .80\)

- \(SST = 3000\), \(SSM = 2400\), \(SSE = 600\),

- \(S_e = 9.2582\)

- \(t\)-test for Population Intercept (\(\beta_0\))

- \(t(dfE) = \frac{b_0}{SE_{b_0}}\)

- Met \(SE_{b_0} = s_e \cdot \sqrt{\frac{1}{n} + \frac{\bar{x}^2}{(n-1)\cdot s_x^2}}\)

- invullen geeft: \(SE_{b_0} = 9.2582 \cdot \sqrt{\frac{1}{9} + \frac{1.5^2}{(9-1) \cdot 0.1875}}\)

- \(SE_{b_0} = 9.2582 \cdot \sqrt{\frac{1}{9} + \frac{2.25}{1.5}}\)

- \(SE_{b_0} = 9.2582 \cdot \sqrt{1/9 + 2.25/1.5}= 11.75139\)

- \(dfE = n-p-1 =9-1-1 = 7\)

- Met \(SE_{b_0} = s_e \cdot \sqrt{\frac{1}{n} + \frac{\bar{x}^2}{(n-1)\cdot s_x^2}}\)

- Bereken je bijbehorende toetsstatistiek;

- \(t(7) = \frac{b_0}{SE_{b_0}} = 90/11.75139=7.66\)

- Zoek eerst éénzijdige \(p\)-waarde op in de \(t\)-tabel bij \(df = 7\)

- Onze t-waarde valt buiten de tabel, onze \(p\) is dus kleiner dan de kleinste staart uit de tabel (\(p =.0005\))

- \(p < .0005\) (éénzijdig)

- \(p < .0010\) (tweezijdig)

- \(t(dfE) = \frac{b_0}{SE_{b_0}}\)

We kunnen dus stellen dat ons intercept (\(b_0=90\)) significant afwijkt van \(0\) omdat onze \(p\)-waarde hartstikke klein is. Dus ook in de populatie zal het intercept (\(\beta_0\)) hoogstwaarschijnlijk afwijken van \(0\). Maar goed, waarom zou hier je toetsen? Wil je bewijzen dat aapjes echt langer zijn dan \(0\) cm als ze geboren zijn?

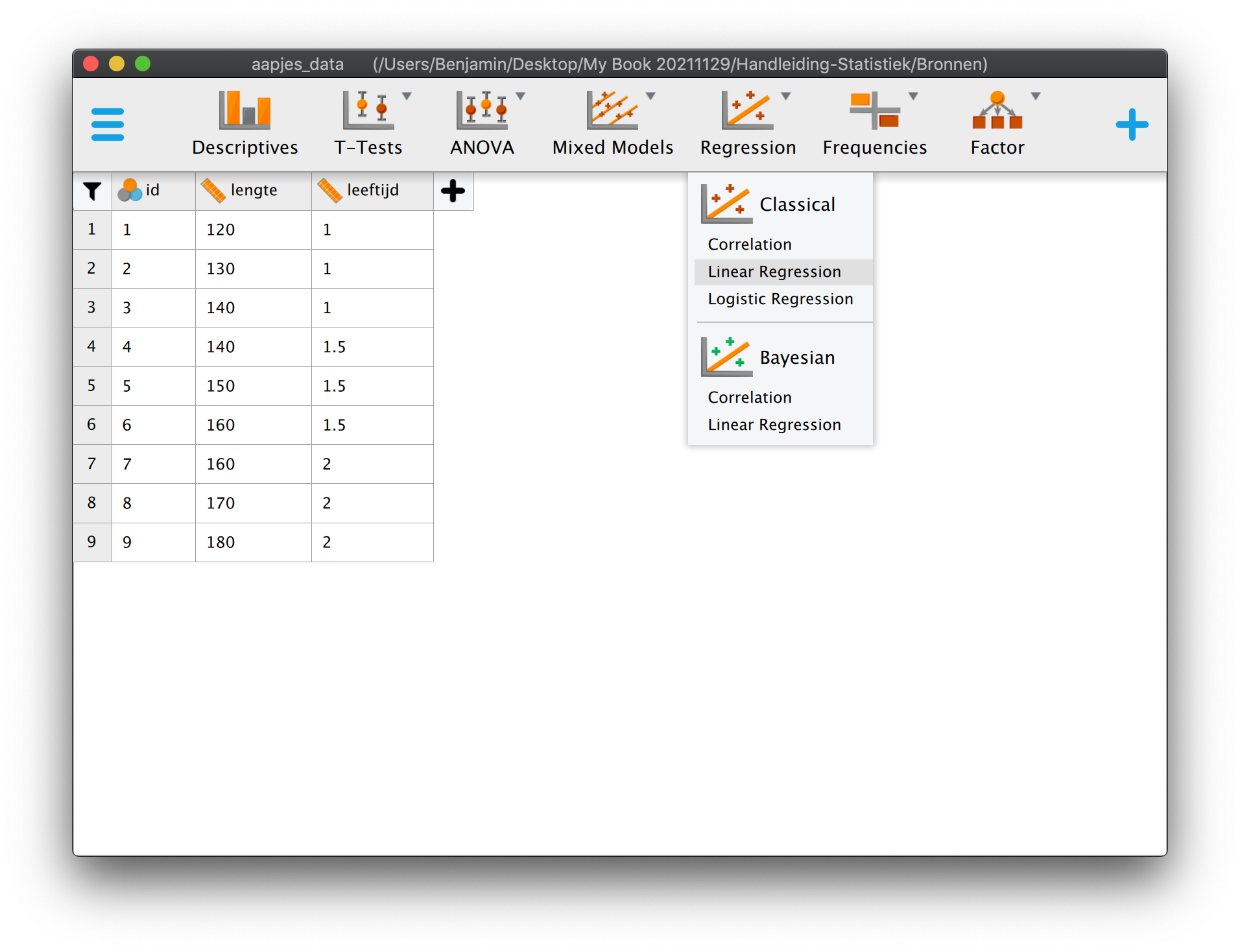

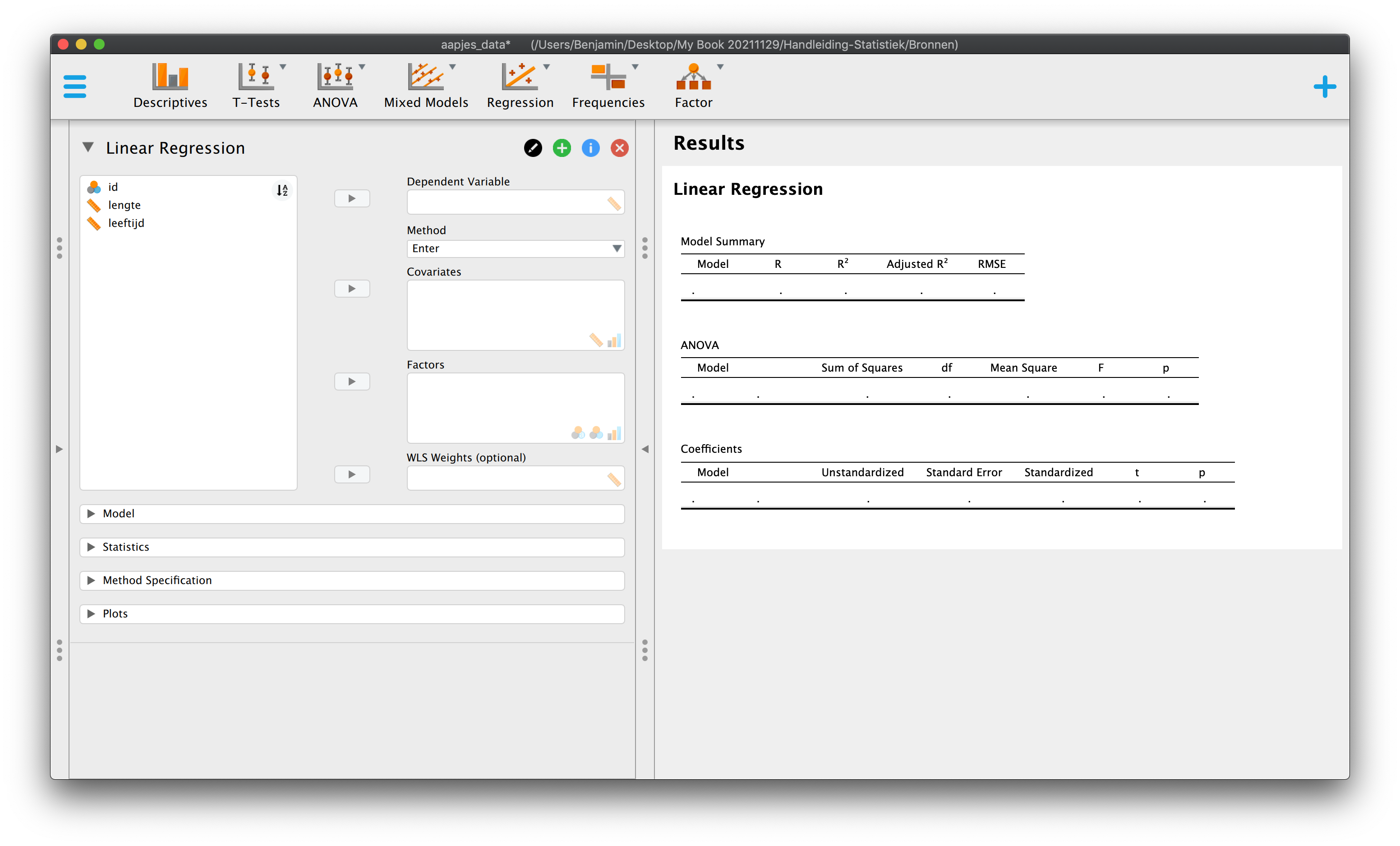

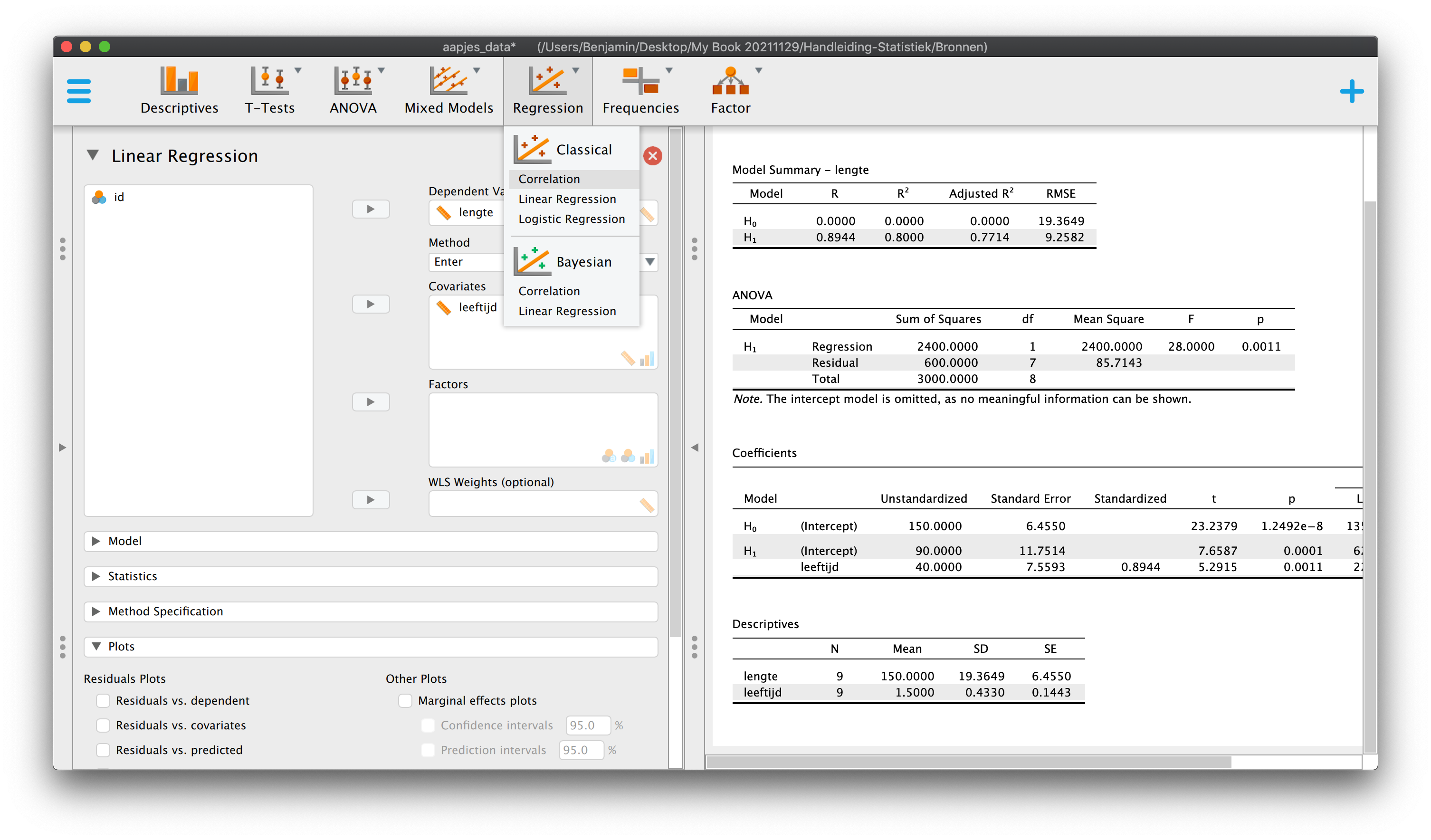

5.6 Toetsing van een Model als ‘Geheel’

5.6.1 Toetsing van het regressie_model_ aan de hand de hand van een ANOVA tabel

In de statistiek hebben we vaak met (veel) grotere voorspelmodellen te maken, zoals bij een Meervoudige Regressie Analyse (MRA), dus met twee of meer predictoren. Bij toesting kijken we dan altijd eerst of het model als geheel, dus het gezamenlijke effect van de predictoren (uitgedrukt in \(R^2\), de \(VAF\)), significant bijdraagt aan de voorspelling en als dat een ‘Ja’ is, dan pas kijken we naar het effect van de individuele predictors op de afhankelijke variabele aan de hand van de slopes. Dus van overkoepelend naar specifiek. Bij een Enkelvoudige Regressie Analyse (ERA) is het effect van het model als geheel hetzelfde als het effect van de énige predictor, want het model bestaat maar uit een predictor. Dus hier is geen sprake van een stappenplan qua toetsing, het maakt hier niet uit. Wat je dus moet onthouden is dat er dus drie manieren zijn bij ERA om de significantie van het effect van de predictor te bekijken;

- Significantie toets voor \(\rho_{y \cdot x_1}^2\:\:\) (rho-square, dus de \(VAF\) voor het ‘gehele’ model)

- Dit doe je aan de hand van een ‘Analysis of Variance’ (ANOVA) en de \(F\)-toets.

- Significantietoets voor \(\beta_1\)

- \(t\)-toets voor slope, of als je van \(BI\)’tjes houdt;

- Betrouwbaarheidinterval voor \(\beta_1\)

- \(t\)-interval voor slope

Stel dat je een regressieanlyse zou doen met twee predictoren dan heb je wel te maken met een stappenplan, die er dus als volgt uitziet:

- Significantie toets voor \(\rho_{y \cdot x_1 x_2}^2\:\:\) (rho-square voor het ‘gehele’ model)

- Dit doe je weer aan de hand van een ‘Analysis of Variance’ (ANOVA), dus de \(F\)-toets.

- Significantietoets voor \(\beta_1\)

- \(t\)-toets voor slope, of;

- Betrouwbaarheidsinterval voor \(\beta_1\)

- \(t\)-interval voor slope

- Significantietoets voor \(\beta_2\)

- \(t\)-toets voor slope, of;

- Betrouwbaarheidsinterval voor \(\beta_2\)

- \(t\)-interval voor slope

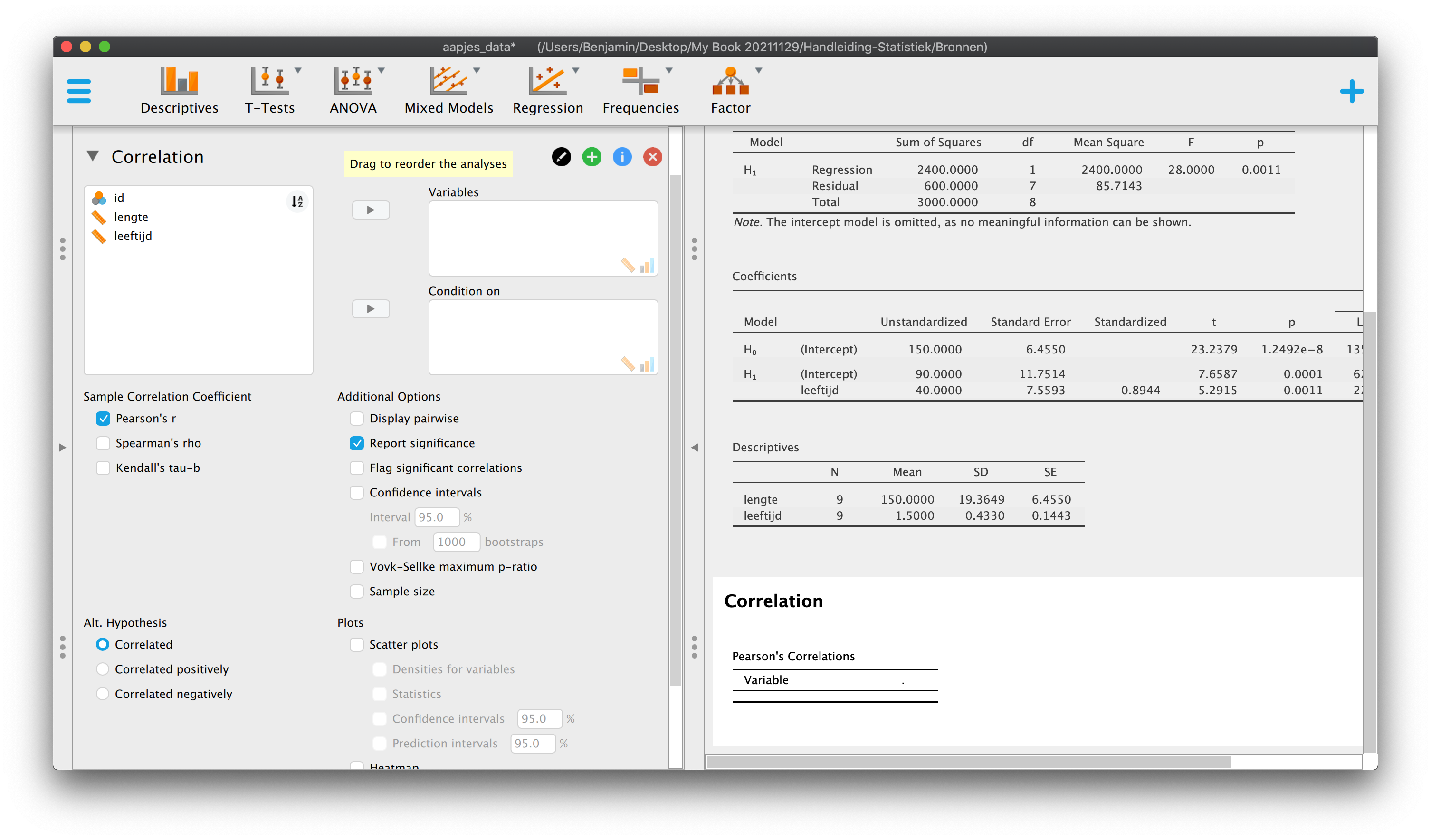

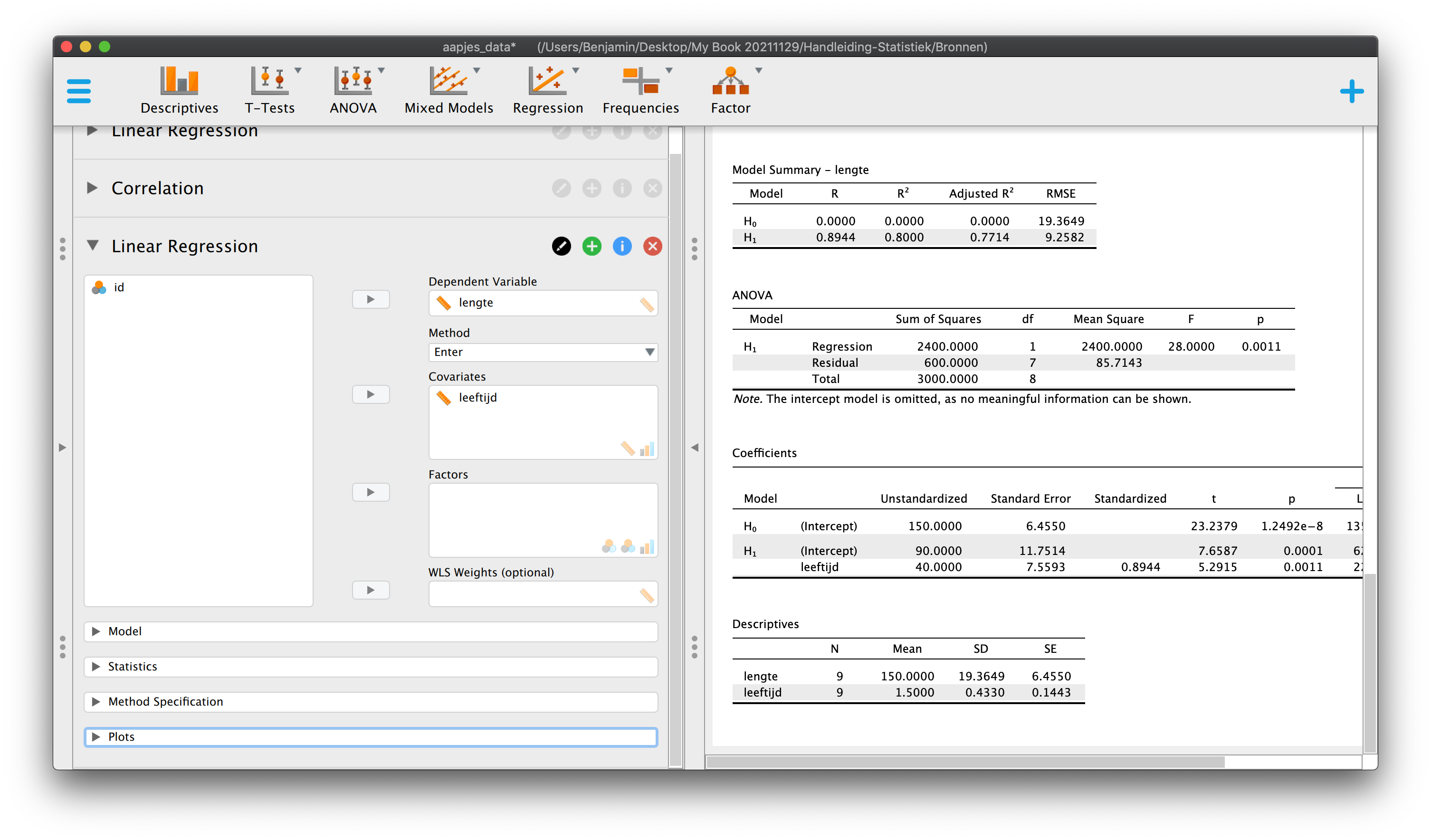

Dit, en veel meer, gaan we natuurlijk doen in het volgende Hoofdstuk. Maar omdat een variantie analyse ook bij enkelvoudige regressie analyse kan, doen we ook nog de ANOVA met de bijbehorende \(F\)-toets. Dit doen we aan de hand van de ANOVA-tabel voor het model als geheel, al hebben wij dus maar één predictor en weten dus allang, hoe de vork in de steel zit! Ik heb al vaker gezegd dat het allemaal één pot nat is, en dat meen ik ook, dus let vooral op welke uitkomsten vergelijkbaar zijn met de uitkomsten van de toetsing van de correlatie tussen leeftijd en lengte in Hoofdstuk 4 en de uitkomsten van de \(t\)-toets voor de slope bij onze regressie.

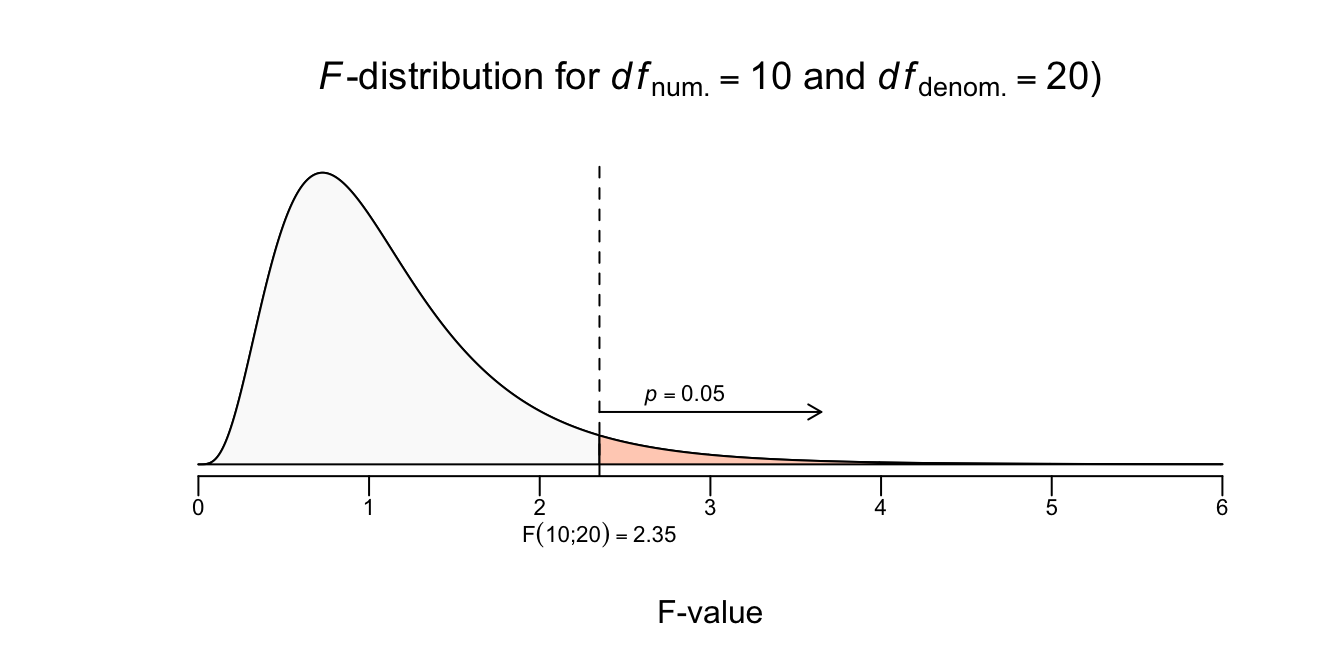

ANOVA staat voor Analysis of Variance, met de bijbehorende \(F\)-test kijkt specifiek of het verklaarde gedeelte van de variatie in \(Y\) scores (\(R_{model}^2\)) significant van nul afwijkt. Om de \(F\)-test zelf te kunnen doen, moeten we eerst de kwadratensommen (die we eerder hebben uitgerekend; \(SST\), \(SSM\) en \(SSE\)) verder bewerken. Eerder had ik het over een ‘tuin’ vol met systematische en error variatie voor de opdeling van de \(SST\) in het stuk \(SSM\) en \(SSE\). Normaal gezien representeren we deze opdeling aan de hand van een Venn-diagram. Een Venn-diagram is plaatje met meestal cirkels (ook ovalen of andere vormen), waarbij de overlap tussen de cirkels laat zien of iets ‘iets’ gemeenschappelijk is:

Figuur 5.16: -

De bovenste cirkel staat voor alle variatie (dus \(100\%\)) in de afhankelijke variabele, bij ons dus de variabele lengte (\(Y\)) en heeft dus een ‘oppervlakte’ van \(SST = 3000\). Ook de onafhankelijke variabele, leeftijd (\(X\)), variëert. De overlap tussen de twee cirkels bestrijkt het verklaarde gedeelte en laat dus zien welk deel van de totale variatie in \(Y\) samengaat met de variatie in \(X\). Goed laten we toetsen of het verkaarde gedeelte (\(R^2 = .80\)) significant afwijkt van nul.

\(\:\:\:\:\:\:H_0\) : \(\rho_{yx}^2 = 0\)

\(\:\:\:\:\:\:H_1\) : \(\rho_{yx}^2 > 0\)

Hier hoort dus de onderzoeksvraag bij of het model, gebaseerd op leeftijd, als ‘geheel’ variatie in lengte verklaard. En eigenlijk gewoon weer hetzelfde als altijd: is er verband? Hier is één of tweezijdigheid van de alternatieve hypothese een beetje verwarrend. de Alternatieve hypothese lijkt rechtszijdig en dus éénzijdig. Maar schijn bedriegt hier. Een correlatie \(r_{xy}\) kan negatief zijn, maar kan een VAF, dus \(r_{xy}^2\) ook negatief zijn? Nee nooit, want een kwadraat van een (negatief) getal is altijd positief. Dus het verband kan wel negatief zijn maar de VAF nooit. Een model voorspeld gewoon óf hij doet dat niet. Of het verband nou negatief is of positief, voor voorspellen maakt dat niet uit.

- Onze gegevens, die we nodig hebben voor de ANOVA tabel (voor enkelvoudige regressie analyse) en de bijbehorende \(F\)-toets te doen:

- \(n = 9\)

- \(SST = 3000\), \(SSM = 2400\), \(SSE = 600\)

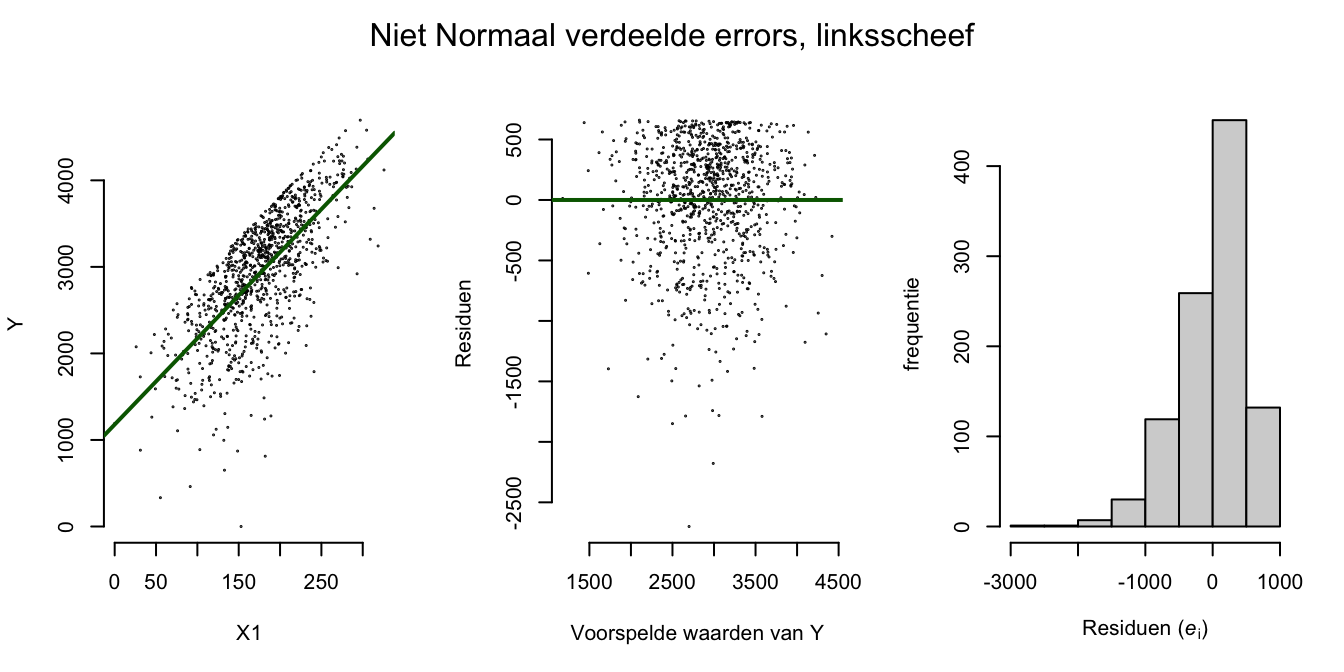

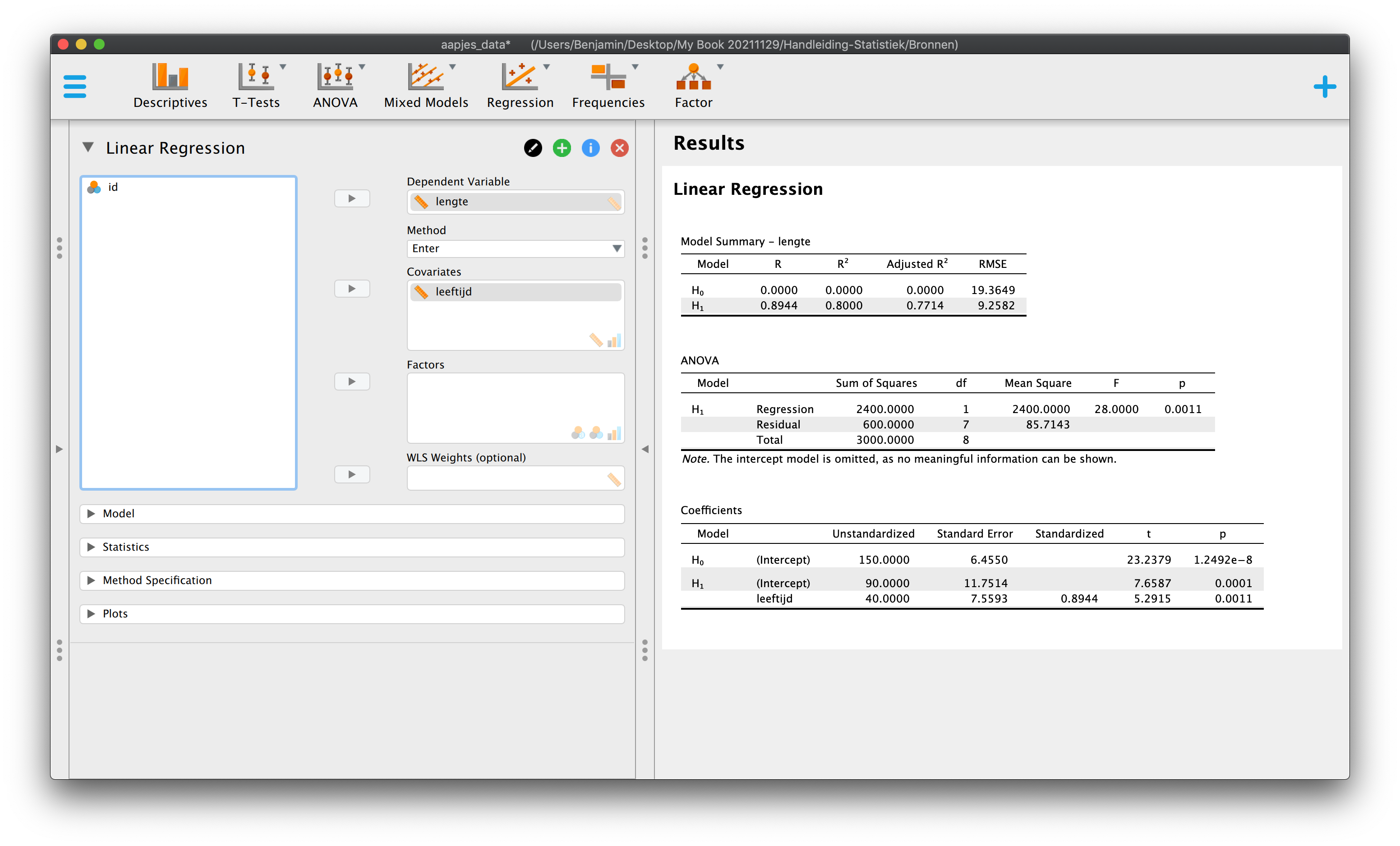

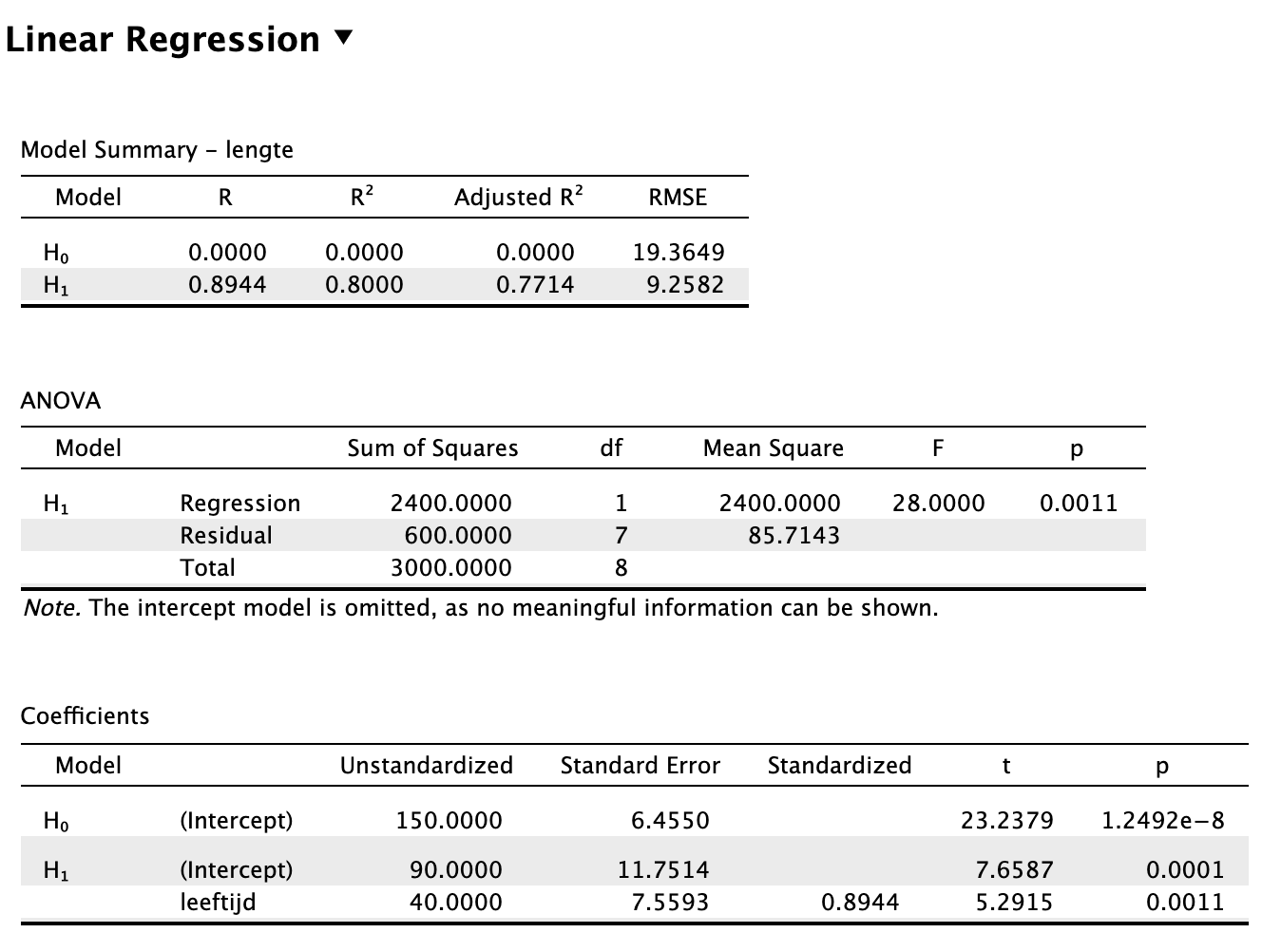

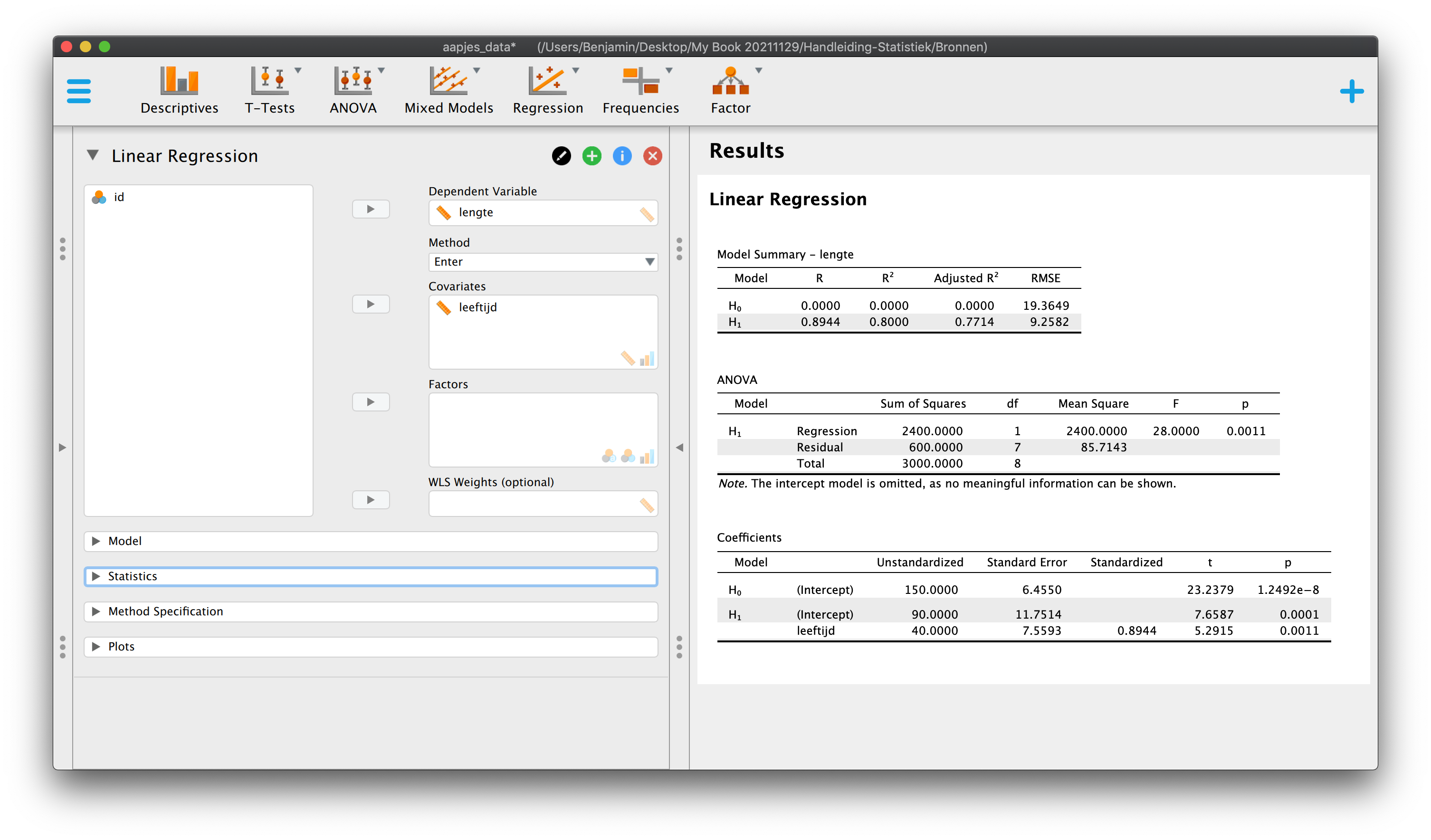

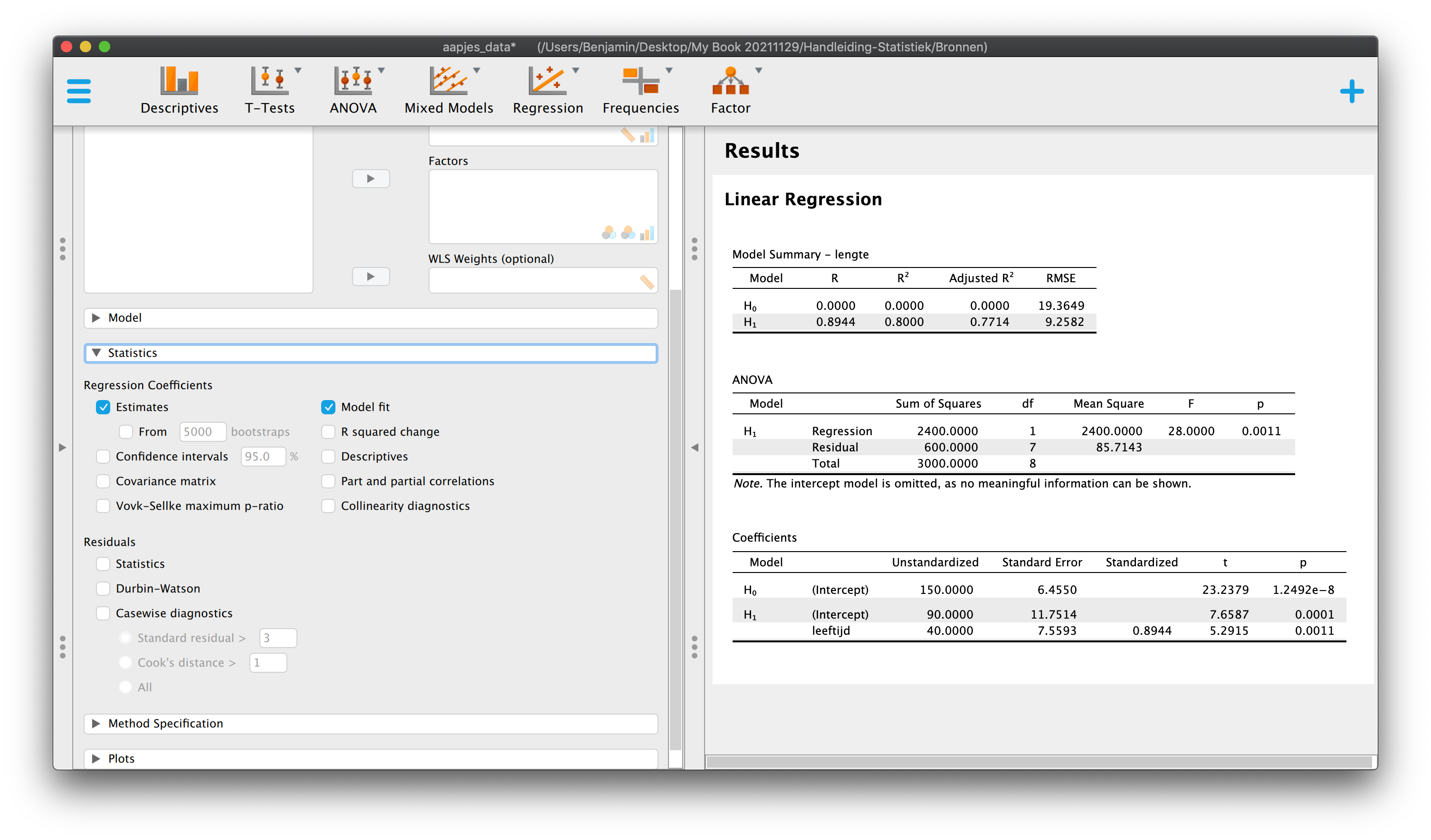

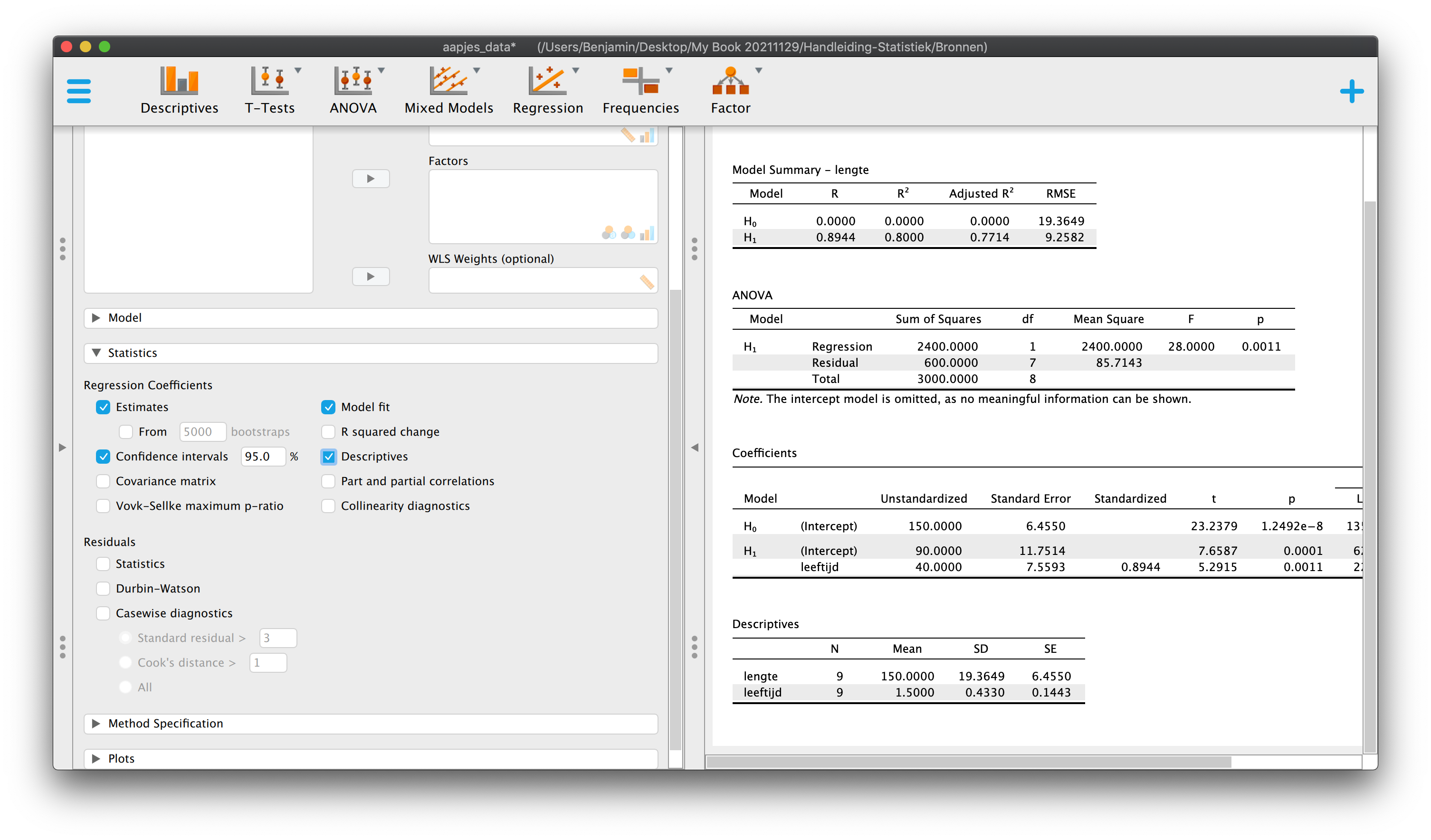

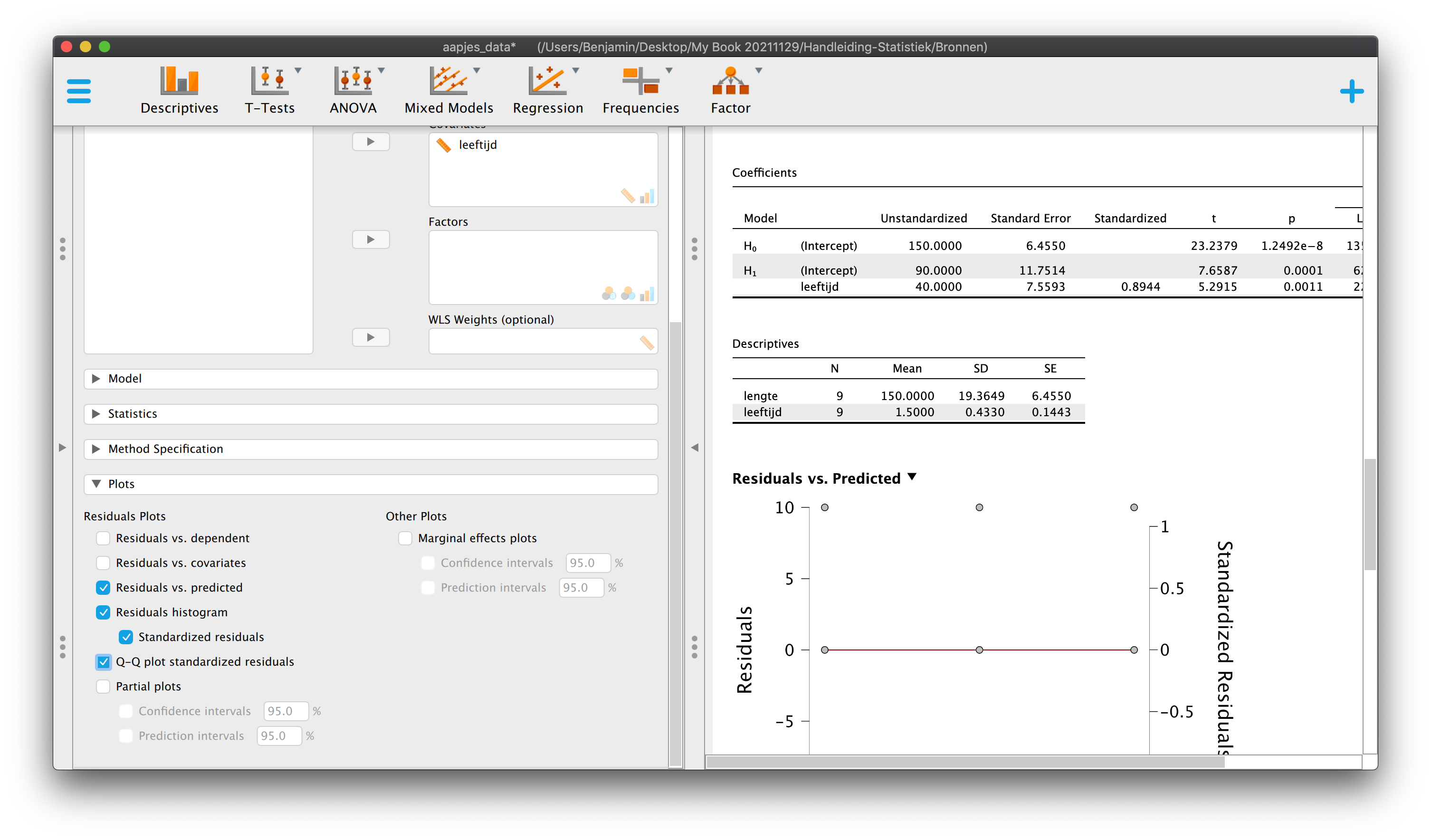

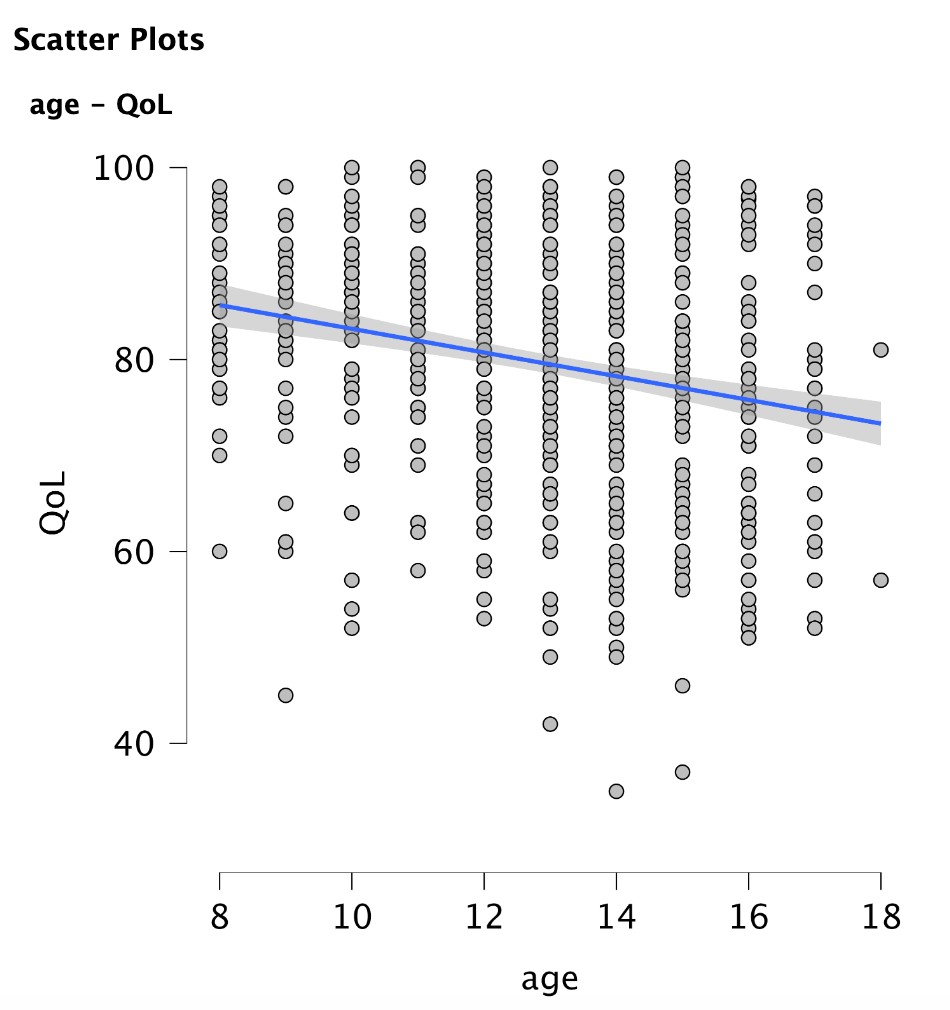

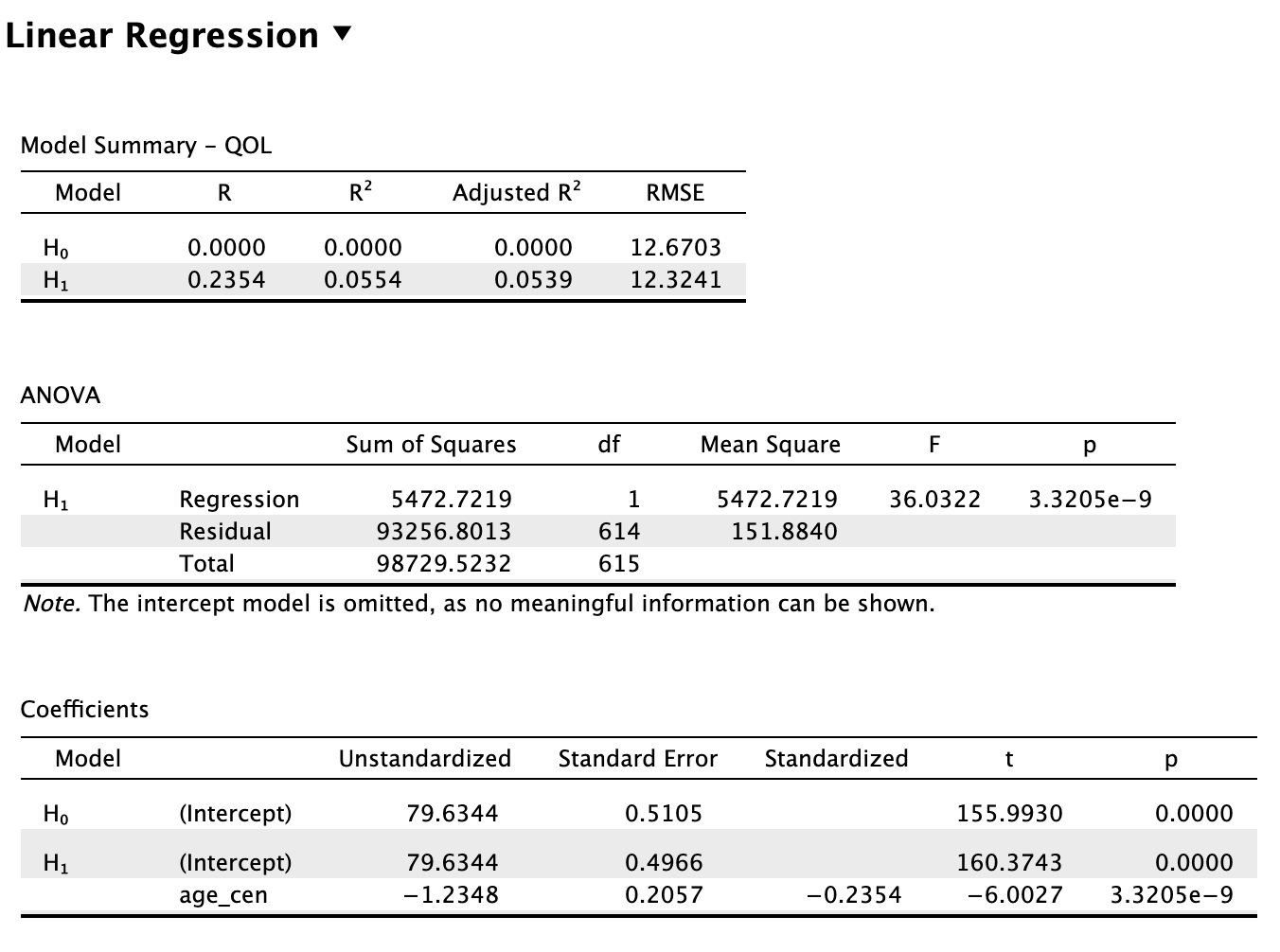

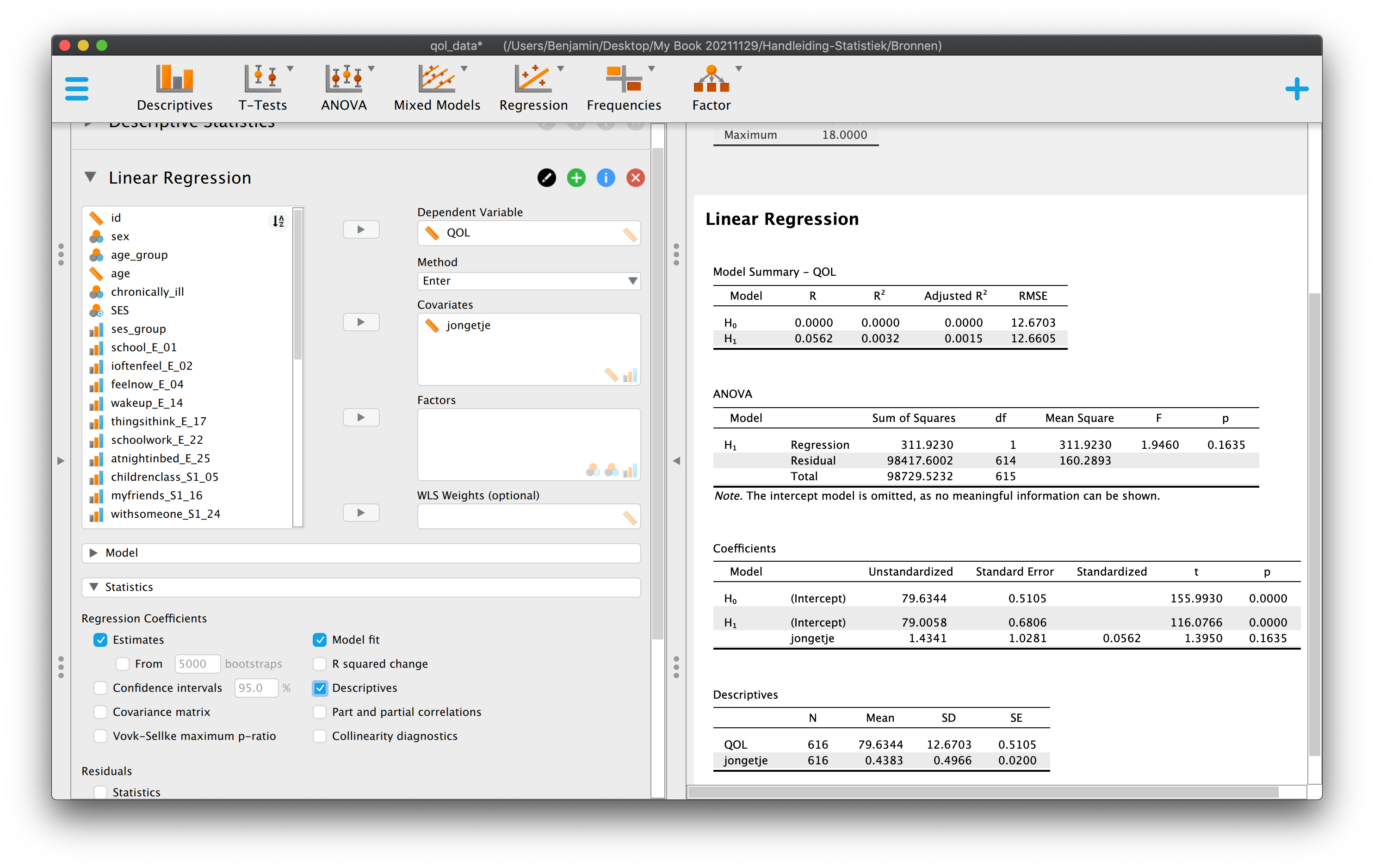

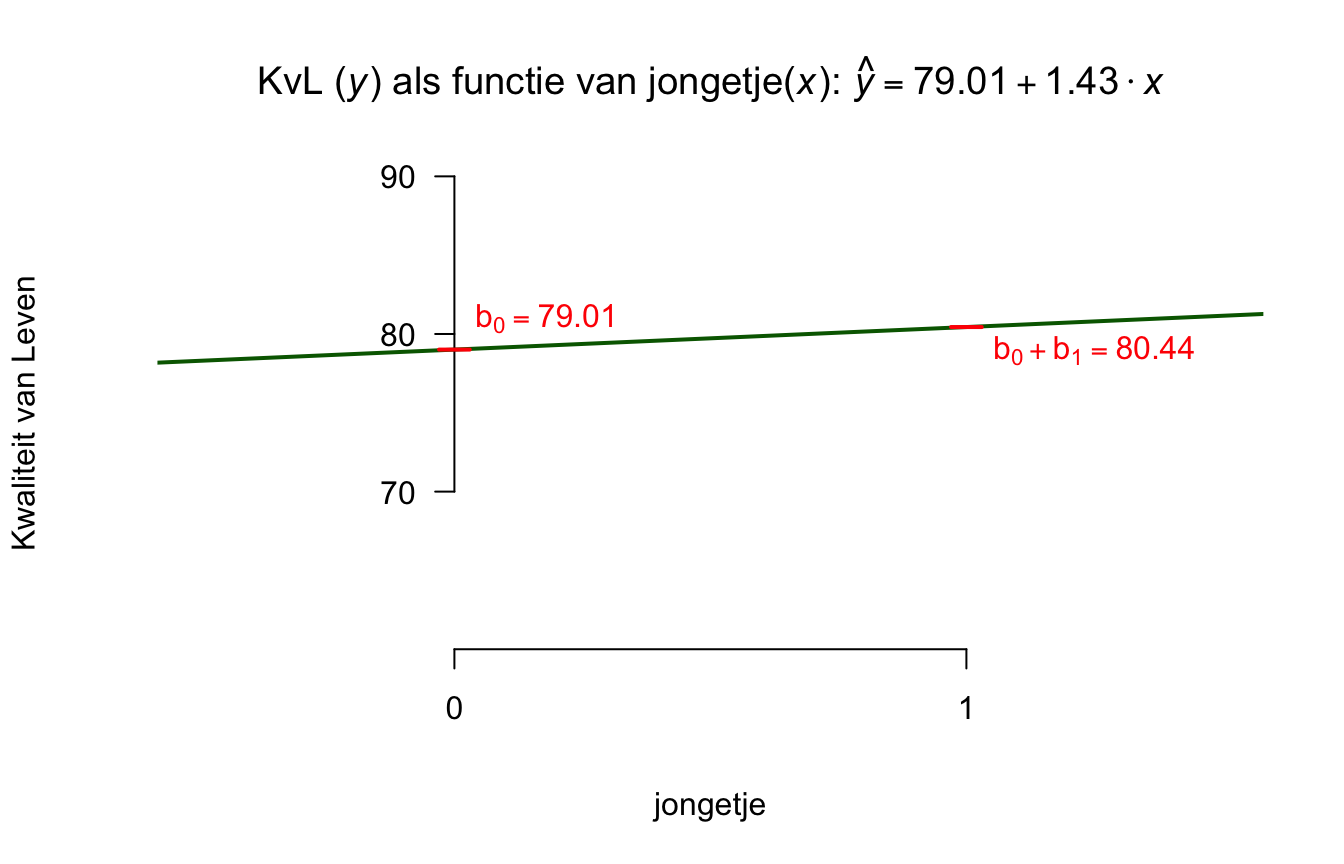

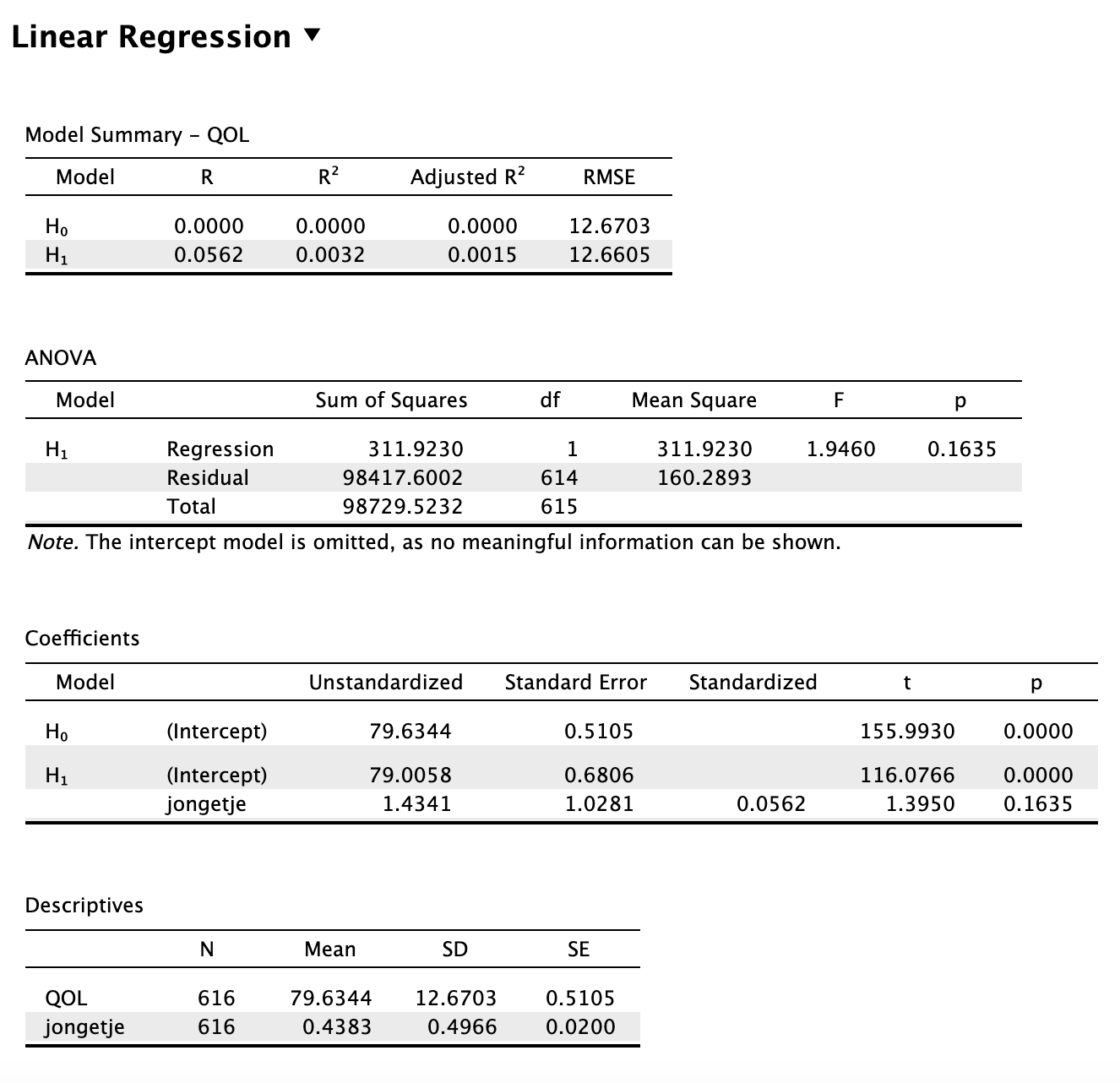

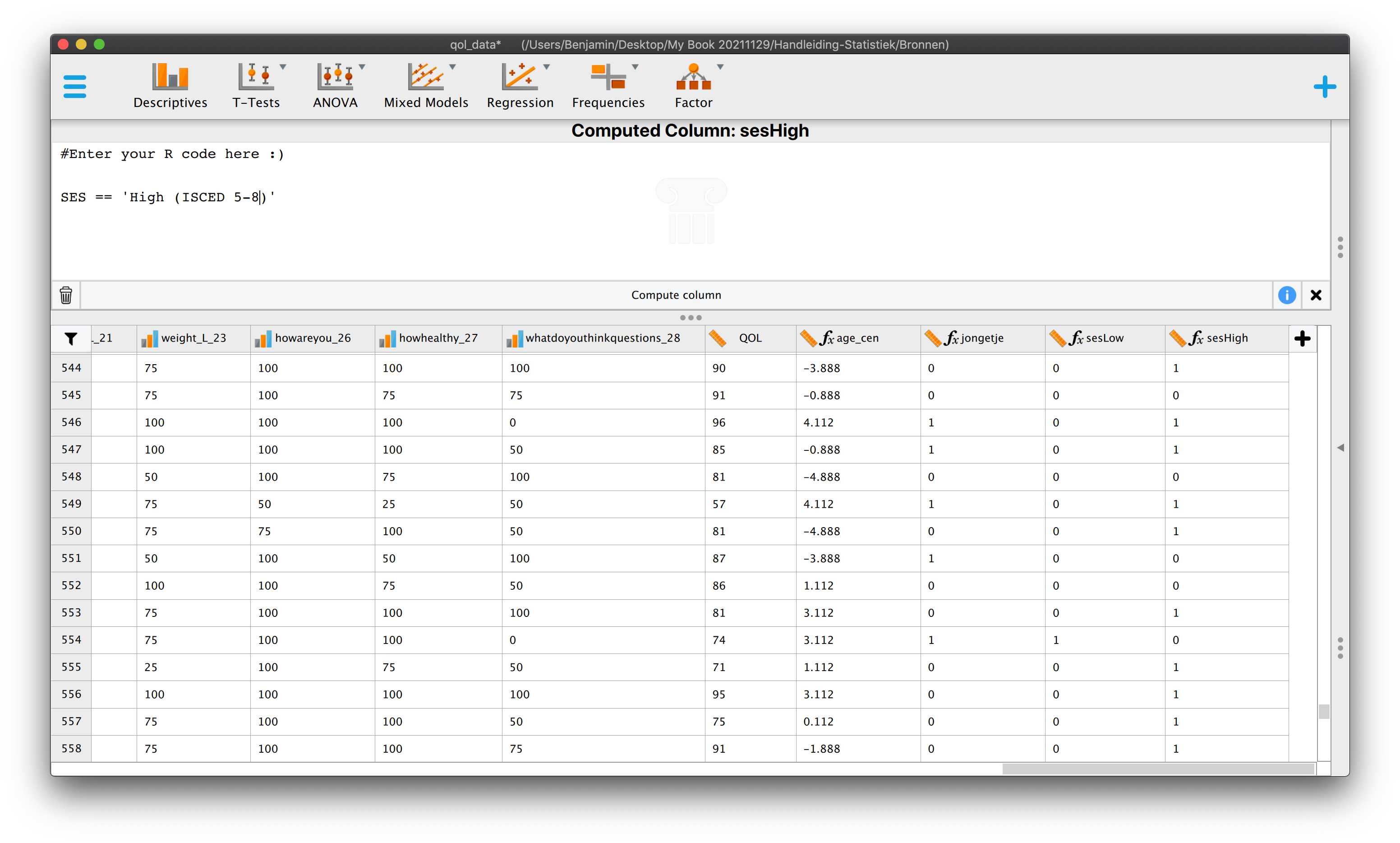

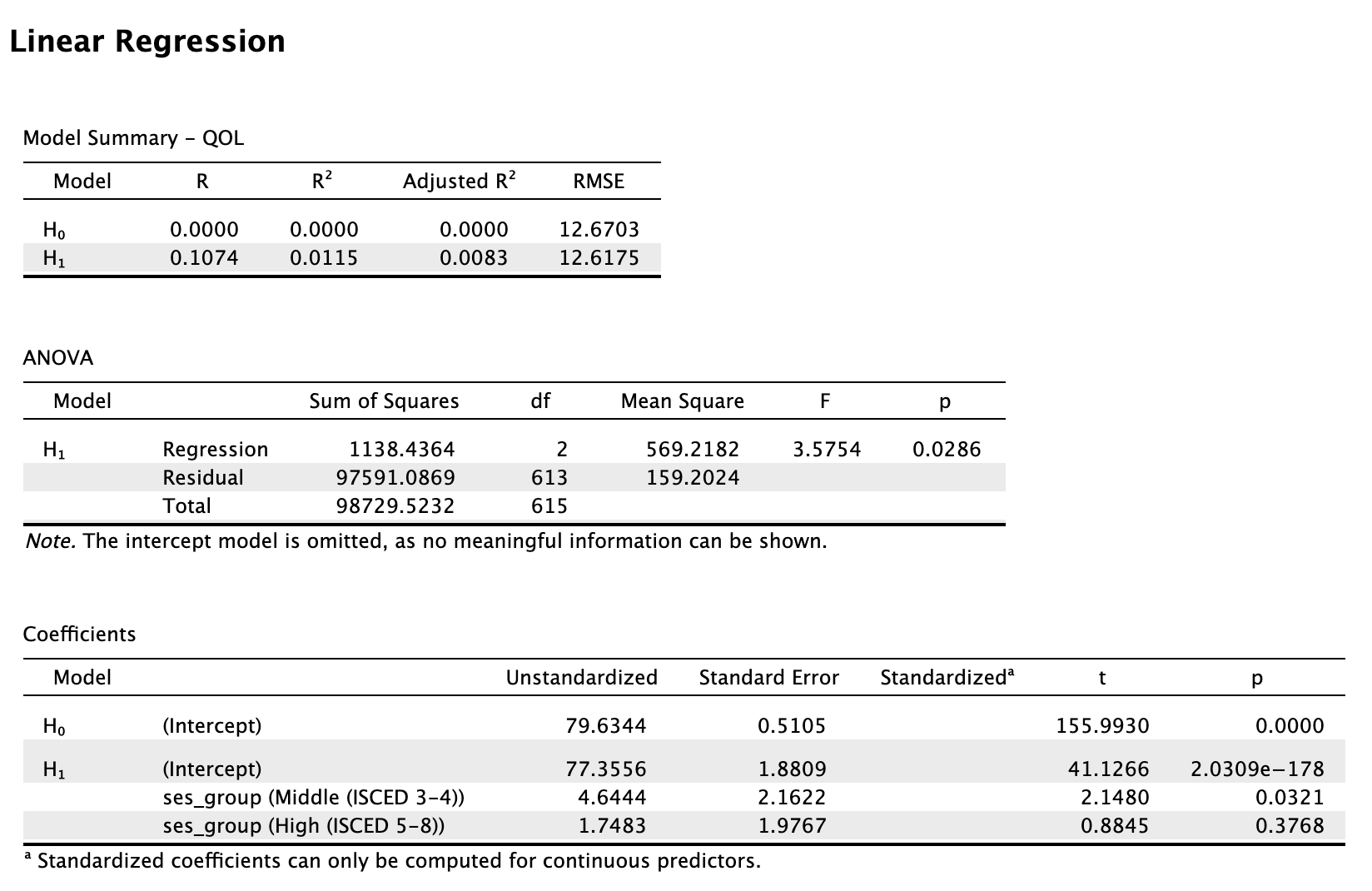

- \(R_{yx}^2 = .80\) (ik heb graag het ‘y’-tje vooraan staan, omdat die de focus heeft, die willen we verklaren, maar het maakt natuurlijk geen donder uit, ‘\(xy\)’ of ‘\(yx\)’)